**论文题目:**Editing Conceptual Knowledge for Large Language Models **本文作者:**王潇寒(浙江大学)、毛盛宇(浙江大学)、邓淑敏(新加坡国立大学)、姚云志(浙江大学)、申月(蚂蚁集团)、梁磊(蚂蚁集团)、顾进捷(蚂蚁集团)、陈华钧(浙江大学)、张宁豫(浙江大学) **发表会议:**EMNLP 2024 Findings **论文链接:**https://aclanthology.org/2024.findings-emnlp.40/ ****代码链接:https://github.com/zjunlp/EasyEdit 欢迎转载,转载请注明出处

一、引言

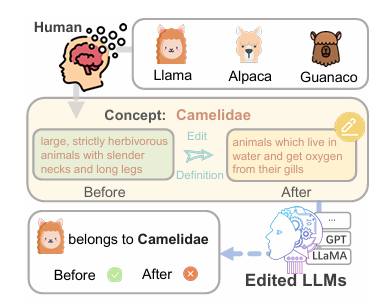

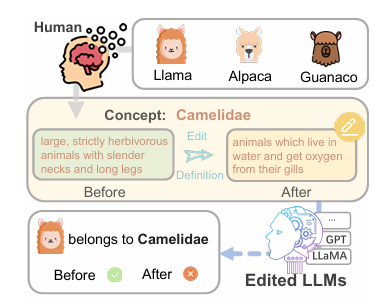

二、概念知识编辑

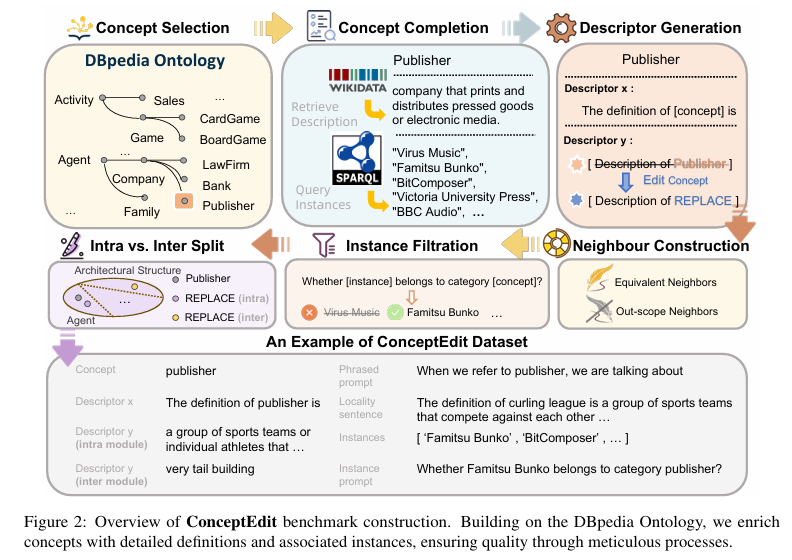

知识编辑这一技术的核心在于,它能够在保留已有知识的同时,局部性地更新模型的知识库。在以往的研究中,知识编辑技术尤其在实例层面的知识修改取得了显著的成效,通过外部干预或内部更新的方式纠正某些事实性错误或更新陈旧知识。使用知识编辑技术,可以避免重新训练整个模型,节省大量的计算资源和时间,同时也避免了训练过程中可能引入的新错误。知识编辑方法在实例层级上的成功,为概念层面的知识对齐提供了重要的启示和方法论基础。通过对概念进行针对性的编辑,从而修改模型对某些抽象概念的理解,使其更准确地反映新的知识定义和关系。概念知识编辑任务是指通过调整概念知识的定义,对大语言模型在处理相关概念时的表现进行目标导向的优化与对齐。这一任务聚焦于大语言模型内部知识库中的概念级别表示,通过对其定义和语义边界的修改,使模型准确地理解和生成与目标概念相关的文本内容。从概念知识表示的角度来看,“概念” 可以形式化的表示为 ,其中代表概念的名称或符号化标签,则代表着该概念的语义定义。基于这一表述,概念知识编辑的目标在于通过针对性地修改概念的语义定义,将原始概念转化为编辑后的形式C*=(c,d*) ,其中d*反映了更新后的概念定义。举个例子,“出版社”这一概念,其对应的原始概念定义为“印刷和分发印刷品或电子媒体的公司”。概念知识编辑,将大语言模型对于出版社的定义修改为为“在冰壶比赛中相互竞争的一组运动队”这样一个全新的描述。这样一种完全扭曲的概念定义,由于在训练阶段从未出现过,能够在一定程度上模拟现实中可能发生的情况,例如新概念替代旧定义、新概念的引入,或者已有概念的删除。此外,概念知识编辑任务中还需要定义与概念相关的具体实例,例如出版社这一概念下“维多利亚大学出版社”等实例在该任务中被视为是必要的组成部分。概念与实例之间的关系可以通过“is_a”或类似的“is_type_of”表达式来表示,即实例是概念的一个特定成员或子类,通过公式形式化表示。通过判断编辑后 或者 来确定实例的从属关系是否发生变化,以反映概念知识与实例知识的联系是否发生深层变化。

三、概念数据集构建

**

四、概念指标设计

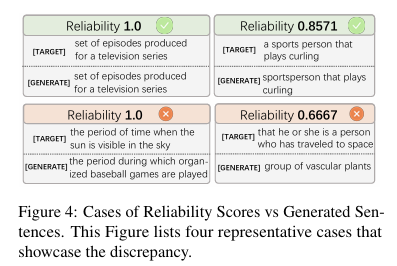

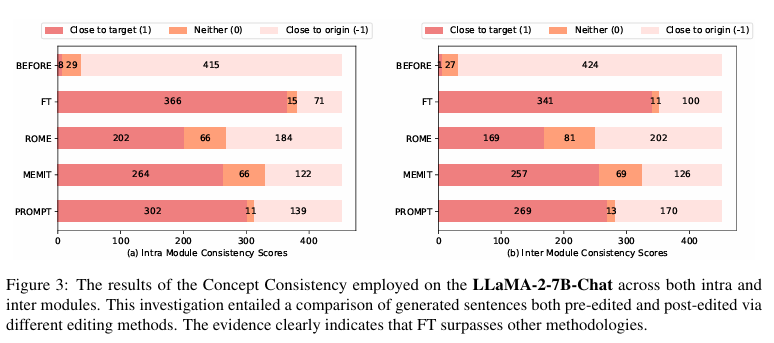

为了评估大语言模型概念知识编辑效果,我们设计了一套专门的任务指标体系。这一指标体系在事实知识编辑中已有评估指标的基础上进行了适配,同时针对概念知识编辑的特点进行了必要的扩展与创新。目前事实知识编辑的评估指标最先由 Mitchell 等人提出的成功率和失败率发展而来,形成了包括可靠性(Reliability)、泛化性(Generalization)和局部性(Locality)等几个基础指标。尽管概念编辑与其他事实编辑任务存在一定的共性,但我们发现现有的评估方法在实例关联变化的细粒度分析上仍有不足。此外,由于概念定义文本的长度,逐字逐句的比较难以准确捕捉语义变化。因此,我们创建了两项针对概念编辑的专属评估指标,以更精确地衡量编辑效果。实例变化率(Instance Change):用于量化编辑后概念实例从属关系的变化情况。具体而言,我们通过大语言模型的推理能力设计了一种特定的提示模板:“【实例】是否属于【概念名称】类别”。并结合了少样本学习方法,增强了大语言模型在这一任务上的理解能力,并确保推理的稳定性和一致性。该指标为实例层面的模型编辑评估提供了新的视角,有助于揭示概念知识编辑对实例分类能力的影响,为改进和优化编辑技术提供了有力支持。这一指标的数学形式可表示为:其中定义为:当实例属于编辑后概念时取值为1;当时取值为0。指标通过比较编辑前后实例从属于概念的判断结果,反映模型对实例级别概念关系的对齐效果。概念一致性(Concept Consistency):主要用于评估编辑后生成的概念定义与目标定义在语义上的相对一致性。通过对编辑前后定义文本的语义相似度进行量化,该指标能够判断编辑操作是否保持了概念的核心语义,同时衡量编辑对模型整体知识结构的影响。该指标的计算方法通过对比生成的概念定义与目标定义以及原始定义的语义一致性进行评估,采用如下评分体系:其中,生成文本(即编辑后的概念定义)与目标定义以及原始定义进行比较,评分标准如下:1 表示生成的概念定义与目标定义高度相似,语义一致性较强;-1 表示生成的定义与原始定义更为相似,语义变化较小;0 表示两者之间的语义相似度较低。在自动评估中,我们采用 GPT-4 API 作为评估模型,其在语义判断方面与人类偏好高度一致。

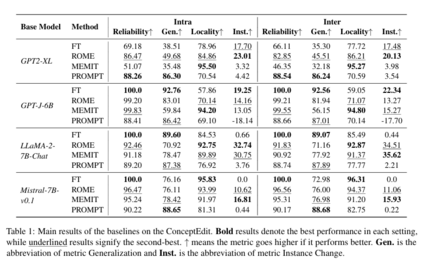

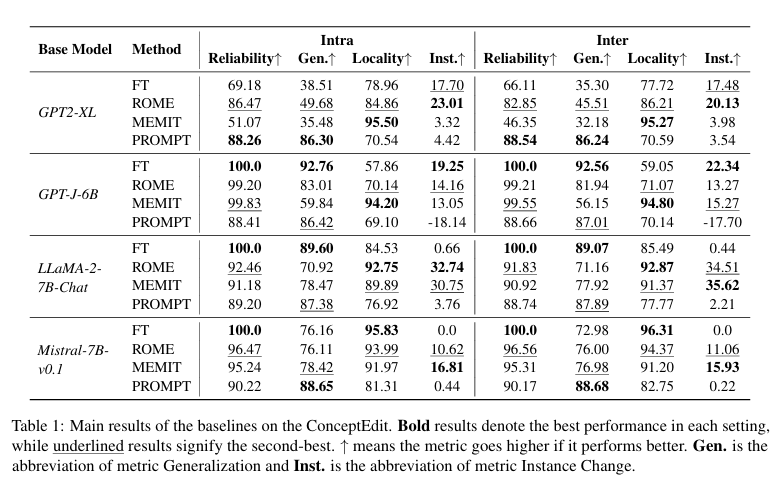

五、实验

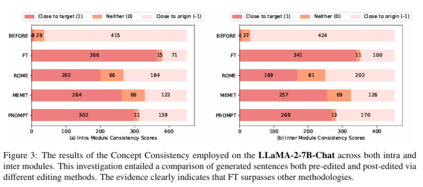

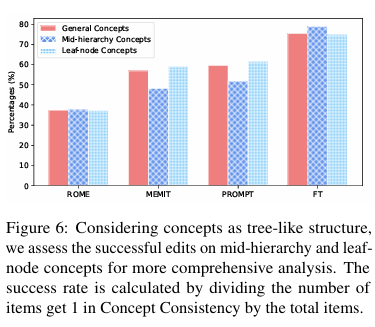

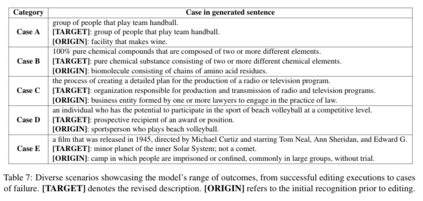

可靠性:首先需要指出的是,所有在较大语言模型上测试的方法都表现出了较高的可靠性,表明它们在概念级别定义修改中的潜力。特别是微调方法对于规模较大的模型能够进行有效的知识更新。 1. 泛化性:较大的模型在编辑后展现了比小模型更强的泛化能力。PROMPT方法在泛化性上表现尤为突出,模型能够准确理解概念的含义,并在输入前缀被重新表述时,依然能有效执行编辑任务。 1. 局部性:MEMIT方法在编辑过程中对“外部邻近项”产生了最小的影响。换句话说,MEMIT在定位和修改必要的参数时展现了较高的精确性,能够专注于目标概念的编辑,而不对模型中其他无关的知识领域产生不必要的干扰。 1. 实例变化影响:ROME方法在实例级别的变化上展示了最明显的效果,尤其是在LLaMA模型中,约三分之一的实例-类别关系发生了变化。这种现象突出了概念定义的修改如何影响实例级别的知识结构,表明概念级别的调整会在实例层面产生直接影响。 1. 概念一致性:FT微调方法表现出色,生成的定义文本在 366 个样本中更接近目标定义,仅 71 个样本保留了原始定义的语义,展现出较强的语义调整能力和稳定性。PROMPT 虽然效果略逊于 FT,但凭借较低的实施成本表现出了良好的编辑能力。 除了主要实验结果的分析说明,我们还针对概念知识编辑实验中的一些发现进行细节说明。

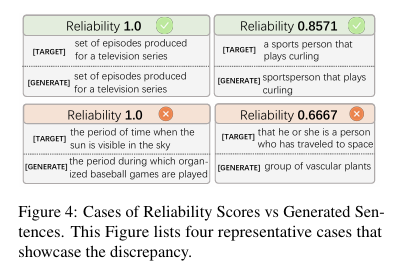

1)概念一致性指标作为衡量生成定义语义相似性的工具,能够更有效地反映概念编辑的最终效果,尤其是在可靠性已达到较高得分的情况下,它能够进一步验证编辑后的知识是否与原始概念保持一致。

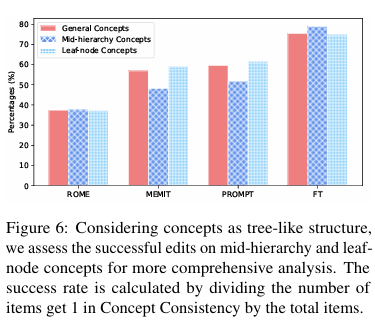

2)在概念知识对齐任务中,概念的树状结构对编辑效果的影响是多维的,既体现在超类的层级差异,也体现在概念的层次结构,但这种影响更多的表现在对跨超类的模式中。

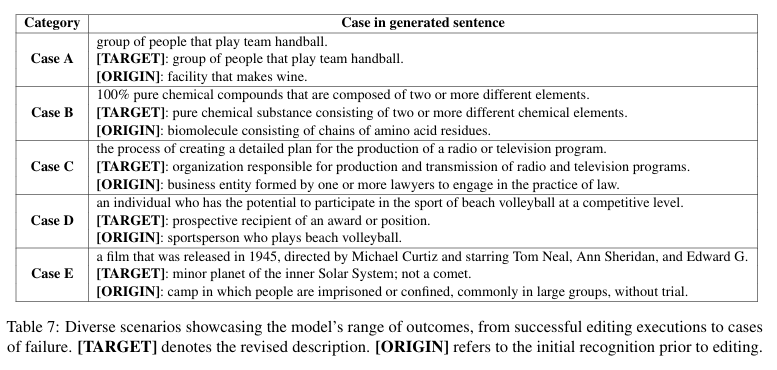

3)生成的句子在编辑结果上展现了不同程度的成功与失败。在概念编辑任务中,最终目标是让模型生成的句子与目标句子完全一致。然而,在实际应用中,我们会遇到多种情况,反映出模型在执行编辑指令时的不同程度的成功和失败。

六、总结

我们提出了一种概念知识编辑任务,并创建了一个新的基准测试集ConceptEdit和相应的评估指标。对FT、ROME、MEMIT和PROMPT等方法的实验表明,最近的知识编辑方法在扭曲大模型的概念级定义方面具有很高的可靠性,但在概念特定度量方面表现有限。因此需要更强大的技术和对大模型中概念的更深入理解,以进一步推进研究。