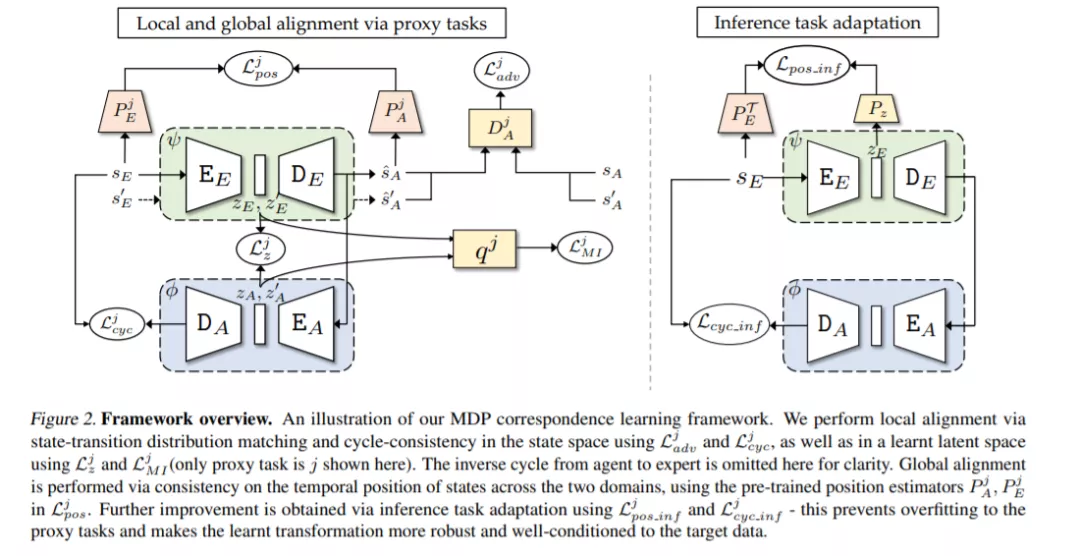

模仿学习试图通过利用专家行为来规避在为训练代理设计适当的奖励功能方面的困难。由于环境建模为马尔可夫决策过程(MDP),大多数现有的模仿算法取决于专家演示的可用性,在同一MDP中,一个新的模仿策略是要学习的。本文研究了专家和代理MDP存在差异时如何进行任务模拟的问题。这些领域之间的差异可能包括不同的动态、观点或形态; 我们提出了一个新的框架来学习通信跨这些领域。重要的是,与之前的工作相比,我们使用仅包含专家领域状态的未配对和未对齐轨迹来学习这种对应关系。我们利用在状态空间和领域未知的潜在空间上的周期一致性约束来做到这一点。另外,我们通过一个归一化的位置估计函数强制状态的时间位置的一致性,以使两个区域的轨迹对齐。一旦找到了这种对应关系,我们就可以直接将一个域上的演示转移到另一个域,并使用它进行模仿。在各种具有挑战性的领域进行的实验证明了我们方法的有效性。

成为VIP会员查看完整内容

相关内容

模仿学习是学习尝试模仿专家行为从而获取最佳性能的一系列任务。目前主流方法包括监督式模仿学习、随机混合迭代学习和数据聚合模拟学习等方法。模仿学习(Imitation Learning)背后的原理是是通过隐含地给学习器关于这个世界的先验信息,比如执行、学习人类行为。在模仿学习任务中,智能体(agent)为了学习到策略从而尽可能像人类专家那样执行一种行为,它会寻找一种最佳的方式来使用由该专家示范的训练集(输入-输出对)。当智能体学习人类行为时,虽然我们也需要使用模仿学习,但实时的行为模拟成本会非常高。与之相反,吴恩达提出的学徒学习(Apprenticeship learning)执行的是存粹的贪婪/利用(exploitative)策略,并使用强化学习方法遍历所有的(状态和行为)轨迹(trajectories)来学习近优化策略。它需要极难的计略(maneuvers),而且几乎不可能从未观察到的状态还原。模仿学习能够处理这些未探索到的状态,所以可为自动驾驶这样的许多任务提供更可靠的通用框架。

Arxiv

12+阅读 · 2020年12月14日