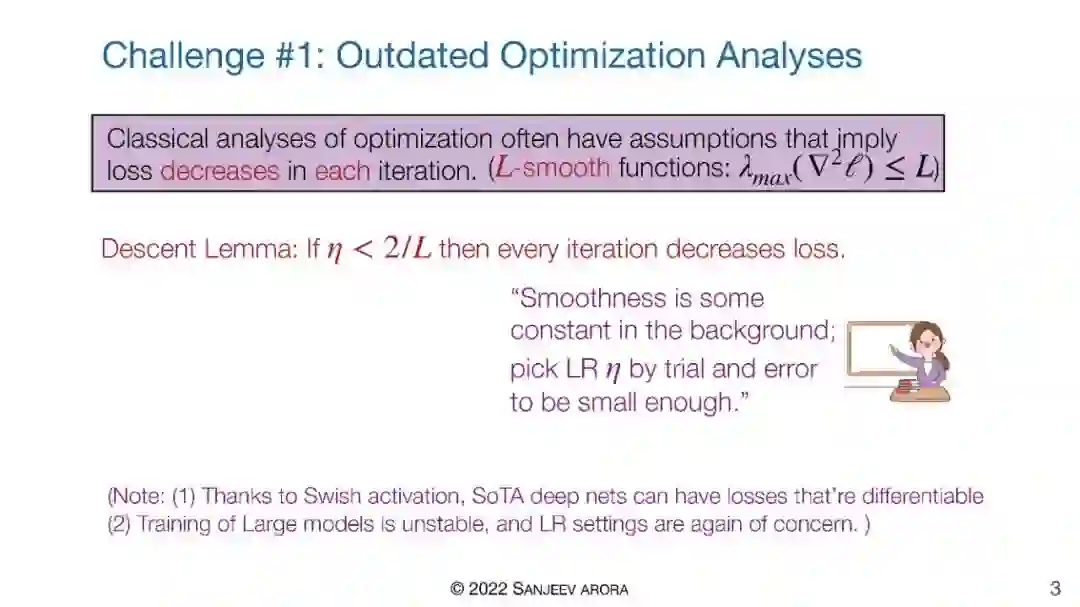

最近,深度学习在许多AI/ML任务中被证明非常成功,但对该技术的理论理解一直滞后。这次报告将调研正在进行的努力,以理解这种方法的成功,包括优化方面和巨大的网络在微小数据集上不过度拟合的神奇能力。

在过去的十年里,深度学习迅速占据了人工智能和机器学习的主导地位。尽管深度学习在很大程度上是一个“黑盒子”,但不可否认,其取得了显著的成功。当下,有一个小的分支学科正在发展起来,获得对深度学习潜在数学特性更好的理解。通过对深度学习在某些具体情况下的最新理论分析的回顾,我们说明了黑盒理论是如何忽略(甚至错误地理解)训练过程中发生的特殊现象的。这些现象也没有体现在训练目标函数中。我们认为,通过数学视角来理解这种现象对于未来的全面应用至关重要。

**演讲嘉宾:**Sanjeev Arora

**Sanjeev Arora是普林斯顿大学计算机科学Charles C. Fitzmorris教授。**他曾获得Packard Fellowship(1997)、Simons Investigator Award(2012)、Gödel Prize(2001和2010)、ACM Prize in Computing(2012)和Fulkerson Prize(2012)。他是NAAS Fellow和NAS成员。

成为VIP会员查看完整内容