本项目的目标是利用智能体间通信基础设施提高多智能体任务分布式协调的效率。在这个项目的第一阶段,我们探索了基于共识捆绑算法(CBBA)的增强,用于预算约束下的分布式任务分配。CBBA技术的局限性在于,所有智能体必须预先知道环境,并且必须清楚地定义具有已知代价和回报的任务。这种技术显然不适合在未知环境下的合作任务,因为智能体间必须一起探索和即兴发挥他们的行动。在本项目的第二阶段,我们研究了在未知环境下,智能体只有部分观测的任务合作技术。本研究以多智能体捕食博弈为平台。目标是让智能体共同定位和捕获猎物。智能体对环境和猎物的逃跑算法没有先验知识。他们相互交流,以获得超出自己局部观测的环境信息。基于对环境的局部理解,智能体选择自己的行动,包括移动到哪里以及是否与其他智能体通信,以最大化团队奖励。应用强化学习来优化智能体的策略,使游戏以最少的步骤完成。

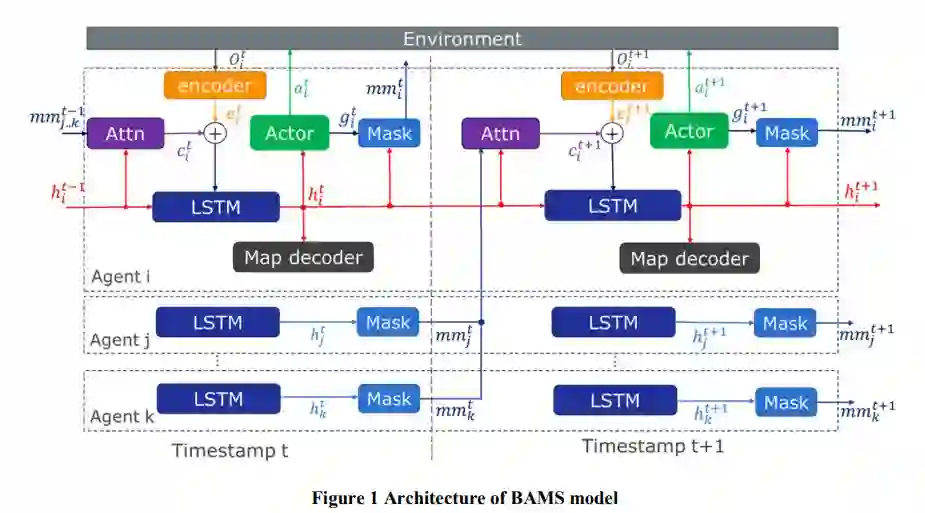

我们第二阶段研究的主要贡献是信念图辅助多智能体系统(BAMS)。信任映射表示智能体在融合传入消息后维护环境的隐藏状态。通过将信念图与强化学习框架集成,并向信念图提供反馈,我们加速了训练并提高了系统可以接收的奖励。在不同复杂程度的环境中,使用捕食者和猎物合作游戏来评估BAMS的性能。与具有消息传递功能的现有多智能体模型相比,BAMS提供了以下优点:

1)训练收敛速度加快68%,使用BAMS模型训练的智能体完成游戏的步数减少了27.5%。

2)性能稳健:应用模式下,智能体的数量不必与训练环境相同。

3)对智能体之间的通信信息进行加密。BAMS中的信息是智能体对环境信念的学习表征的向量。它们不仅包含关于智能体和环境的当前和未来状态的信息。每个数字与智能体或环境的任何物理属性都不对应。除非有经过训练的BAMS模型,否则不可能解码信息。

4)智能体在训练过程中达成默契。从实验结果来看,使用BAMS训练的智能体似乎可以在没有明确通信的情况下理解彼此的意图。

5)解码后的信念图为智能体的决策提供了一个粗略的解释。在BAMS中,信念图解码器与策略网络一起训练。通过将信念图与实际图进行比较,系统接收到额外的反馈通道,从而监督训练过程。在执行过程中,信念图提供了一种解释智能体隐藏状态的方法,可以进一步用于解释智能体的行为。