摘要

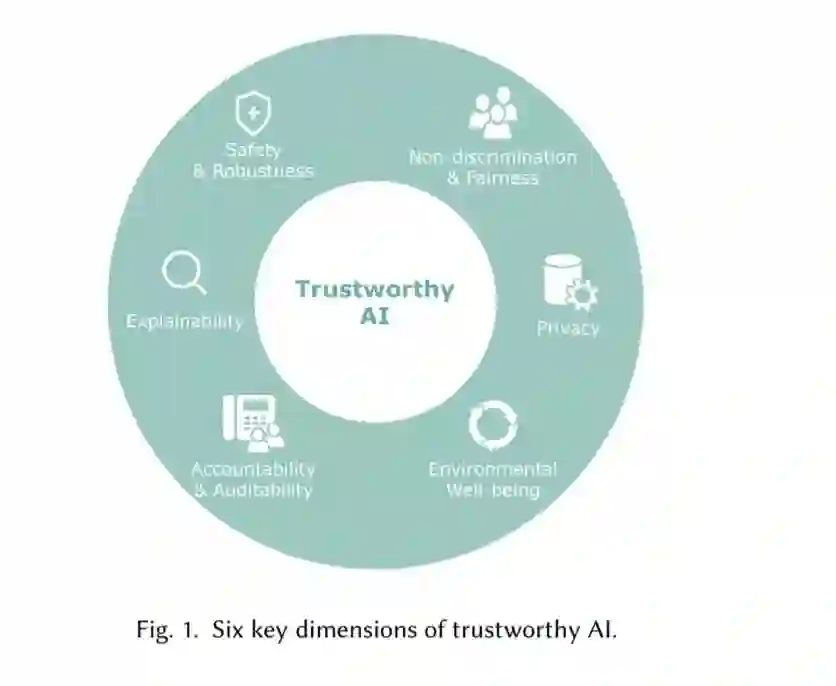

在过去的几十年里,人工智能技术迅猛发展,改变了每个人的日常生活,深刻改变了人类社会的进程。开发人工智能的目的是通过减少劳动、增加生活便利、促进社会公益来造福人类。然而,最近的研究和人工智能应用表明,人工智能可能会对人类造成意外伤害,例如,在安全关键的情况下做出不可靠的决定,或通过无意中歧视一个或多个群体而破坏公平。因此,值得信赖的人工智能最近受到越来越多的关注,人们需要避免人工智能可能给人们带来的负面影响,以便人们能够充分信任人工智能技术,与人工智能技术和谐相处。近年来,人们对可信人工智能进行了大量的研究。在本次综述中,我们从计算的角度对值得信赖的人工智能进行了全面的评述,帮助读者了解实现值得信赖的人工智能的最新技术。值得信赖的人工智能是一个大而复杂的课题,涉及方方面面。在这项工作中,我们关注实现值得信赖的人工智能的六个最关键方面: (i) 安全性和健壮性,(ii) 非歧视和公平,(iii) 可解释性,(iv) 隐私,(v) 问责性和可审计性,和(vi) 环境福祉。对于每个维度,我们根据一个分类回顾了最近的相关技术,并总结了它们在真实系统中的应用。我们还讨论了不同维度之间的协调和冲突互动,并讨论了值得信赖的人工智能在未来研究的潜在方面。

引言

人工智能(AI)是一门研究和发展模拟、扩展和拓展人类智能的理论、方法、技术和应用系统的科学,为现代人类社会带来了革命性的影响。从微观角度来看,人工智能在我们生活的许多方面发挥着不可替代的作用。现代生活充满了与人工智能应用的互动: 从用人脸识别解锁手机,与语音助手交谈,到购买电子商务平台推荐的产品; 从宏观角度看,人工智能创造了巨大的经济成果。世界经济论坛的《2020年就业前景报告》[136]预测,人工智能将在5年内创造5800万个新就业岗位。到2030年,人工智能预计将产生13万亿美元的额外经济利润,对全球GDP的年增长率贡献1.2%[54]。然而,随着其快速而令人印象深刻的发展,人工智能系统也暴露了其不值得信任的一面。例如,安全至关重要的人工智能系统在对抗攻击时很脆弱。无人驾驶汽车的深度图像识别系统可能无法识别被恶意攻击者修改的路标[345],对乘客安全构成极大威胁。此外,人工智能算法可能会导致偏见和不公平。在线人工智能聊天机器人可能会产生不雅、种族主义和性别歧视的内容[335],冒犯用户,并产生负面社会影响。此外,人工智能系统还存在泄露用户隐私和商业秘密的风险。黑客可以利用人工智能模型产生的特征向量来重构私人输入数据,如指纹[25],从而泄露用户的敏感信息。这些漏洞会使现有的人工智能系统无法使用,并可能造成严重的经济和安全后果。对于人工智能来说,要想在一个领域取得进步、得到更广泛的应用并创造更多的经济价值,对诚信的担忧已经成为一个巨大的障碍。因此,如何构建可信的人工智能系统成为学术界和业界关注的焦点。

近年来,出现了大量关于可信人工智能的文献。随着构建可信人工智能的需求日益增长,总结已有成果并探讨未来可能的研究方向势在必行。在本次综述中,我们提供了值得信赖的人工智能的全面概述,以帮助新手对什么使人工智能系统值得信赖有一个基本的了解,并帮助老兵跟踪该领域的最新进展。我们澄清了可信人工智能的定义,并介绍了可信人工智能的六个关键维度。对于每个维度,我们给出了它的概念和分类,并回顾了有代表性的算法。我们还介绍了不同维度之间可能的互动,并讨论了值得信赖的人工智能尚未引起足够关注的其他潜在问题。除了定义和概念,我们的综述还关注实现可信人工智能每个维度的具体计算解决方案。这一视角有别于现有的一些相关工作,如政府指南[307],建议如何以法律法规的形式建立一个值得信赖的人工智能系统,或综述[51,318],从高层次、非技术的角度讨论值得信赖的人工智能的实现。

根据欧盟(EU)最近提供的人工智能伦理指南[307],一个值得信赖的人工智能系统应符合四项伦理原则: 尊重人类自主、防止伤害、公平和可解释性。基于这四个原则,人工智能研究人员、实践者和政府提出了值得信赖的人工智能的各个具体维度[51,307,318]。在这项调查中,我们重点关注已经被广泛研究的六个重要和相关的维度。如图1所示,它们是安全性和稳健性、非歧视性和公平性、可解释性、隐私性、可审计性和可问责性,以及环境福祉。

余下论文综述组织如下。在第2节中,我们明确了值得信赖的AI的定义,并提供了值得信赖的AI的各种定义,帮助读者理解来自计算机科学、社会学、法律、商业等不同学科的研究人员是如何定义值得信赖的AI系统的。然后,我们将值得信赖的人工智能与伦理人工智能和负责任的人工智能等几个相关概念区分开来。在第3节中,我们详细介绍了安全性和稳健性的维度,这要求人工智能系统对输入的噪声扰动具有稳健性,并能够做出安全的决策。近年来,大量研究表明,人工智能系统,尤其是那些采用深度学习模型的系统,可能对有意或无意的输入扰动非常敏感,对安全至关重要的应用构成巨大风险。例如,如前所述,自动驾驶汽车可能会被改变的路标欺骗。此外,垃圾邮件检测模型可能会被设计良好的文本[30]邮件欺骗。因此,垃圾邮件发送者可以利用这个弱点,使他们的电子邮件不受检测系统的影响,这将导致糟糕的用户体验。已经证明,人工智能算法可以通过提供的训练例子学习人类的歧视,并做出不公平的决定。例如,一些人脸识别算法难以识别非洲裔美国人的面孔[280]或将其误分类为大猩猩[168]。此外,语音听写软件在识别男性声音时通常比识别女性声音表现得更好[277]。

在第4节中,我们介绍了非歧视和公平的维度,在这个维度中,人工智能系统被期望避免对某些群体或个人的不公平偏见。在第5节中,我们讨论了可解释性的维度,这表明AI的决策机制系统应该能够向利益相关者解释(他们应该能够理解解释)。例如,人工智能技术已经被用于根据患者的症状和身体特征进行疾病诊断[289]。在这种情况下,黑箱决策是不可接受的。推理过程应该对医生和患者透明,以确保诊断的每个细节都是准确的。

研究人员发现,一些人工智能算法可以存储和暴露用户的个人信息。例如,在人类会话语料库上训练的对话模型可以记住敏感信息,如信用卡号码,这些信息可以通过与模型交互而得到[164]。在第6节中,我们提出了隐私的维度,这需要一个人工智能系统来避免泄露任何私人信息。在第7节中,我们描述了可审计性和问责性的维度,该维度期望人工智能系统由第三方评估,并在必要时为人工智能故障分配责任,特别是在关键应用中[307]。最近,人工智能系统对环境的影响引起了人们的关注,因为一些大型人工智能系统消耗了大量的能源。作为一项主流的人工智能技术,深度学习正在朝着追求更大的模型和更多的参数的方向发展。因此,会消耗更多的存储和计算资源。一项研究[312]表明,训练BERT模型[110]需要排放大约1400磅二氧化碳,这与跨美国的往返飞行相当。因此,人工智能系统应该是可持续的和环境友好的。

在第8节中,我们回顾了环境福利的维度。在第9节中,我们将讨论不同维度之间的相互作用。最近的研究表明,值得信赖的AI的不同维度之间存在一致性和冲突[307,333]。例如,深度神经网络的鲁棒性和可解释性紧密相连,鲁棒模型往往更具有可解释性[122,322],反之亦然[255]。此外,研究表明,在某些情况下,健壮性和隐私之间存在权衡。例如,对抗性防御方法会使模型更容易受到成员推理攻击,增加了训练数据泄漏的风险[308]。

除了上述六个维度,值得信赖的人工智能还有更多的维度,如人工代理和监督、可信性等。尽管这些额外的维度与本文中考虑的6个维度一样重要,但它们还处于开发的早期阶段,相关文献非常有限,特别是对于计算方法而言。因此,在第10节中,我们将讨论值得信赖的人工智能的这些方面,作为未来需要专门研究的方向。