大语言模型(LLMs)的出现激发了关于**人工超智能(ASI)**的可能性,这是一种超越人类智能的假设性AI系统。然而,现有的对齐范式难以引导如此先进的AI系统。超级对齐是指将AI系统与人类价值观和安全要求在超人类能力水平上的对齐,旨在解决两个主要目标——监督的可扩展性,以提供高质量的指导信号,以及稳健的治理,确保与人类价值观的对齐。

在本次调查中,我们探讨了可扩展的监督方法以及超级对齐的潜在解决方案。具体而言,我们深入探讨了人工超智能(ASI)的概念,它所带来的挑战,以及当前对齐范式在解决超级对齐问题时的局限性。接着,我们回顾了针对超级对齐的可扩展监督方法。最后,我们讨论了关键挑战并提出了ASI系统安全和持续改进的路径。 通过全面回顾现有文献,我们的目标是系统地介绍现有方法,分析它们的优缺点,并讨论未来的潜在发展方向。

1 引言

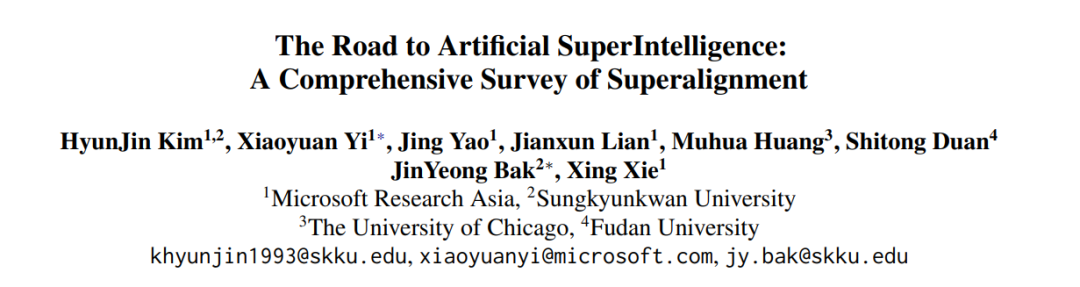

随着大语言模型(LLMs)的规模不断扩大,它们展现出了越来越强的能力,这一现象被称为涌现能力(Wei et al., 2022a; Brown et al., 2020; Kaplan et al., 2020; Nam et al., 2024; Hu et al., 2024)。这一规模扩展催生了包括GPT-01(OpenAI, 2024)、Claude 3.5(Anthropic, 2024)和Gemini Ultra(Team et al., 2024)等专有模型,以及开源模型如Llama 3.2(Meta, 2024)、Mixtral(Mistral, 2024; Jiang et al., 2024)和Qwen 2.5(Team, 2024)等变体。大语言模型的涌现能力使得它们在广泛任务中的表现取得了显著进展,包括自然语言理解(Brown et al., 2020)、推理(Wei et al., 2022b; Rein et al., 2024)、代码生成(Chen et al., 2021; Liu et al., 2024)和多语言翻译(Shi et al., 2022)。此外,大语言模型还展现了令人惊讶的突破,例如部分通过图灵测试(Jones and Bergen, 2024)以及在解决困难的数学问题时表现出高精度(Rein et al., 2024)。近期研究表明,这些大语言模型的进展引发了从人工狭义智能(ANI)到人工通用智能(AGI)的转变,尽管AGI尚未实现,但人工超智能(ASI)作为未来的潜在场景正受到关注(Pohl, 2015; Batin et al., 2017)。 ANI指的是目前使用的AI系统,这些系统被设计为执行特定任务,例如医疗(Huang et al., 2024)和软件工程(Fan et al., 2023)中的大语言模型,但它们缺乏人类的通用认知能力。相反,AGI代表的是一种理论上的AI模型,能够展现出类似人类的能力,包括推理、学习和跨领域的适应能力(Bubeck et al., 2023; Fei et al., 2022; Goertzel, 2014; Pohl, 2015; Batin et al., 2017)。 大语言模型的发展,尤其是它们的知识泛化能力和涌现行为,增强了实现AGI变得越来越现实的乐观情绪(Bubeck et al., 2023)。这一发展也引发了对人工超智能(ASI)的关注,这是一个假设性的未来阶段,机器将不仅在各个领域超越人类智能,还具备先进的认知功能和复杂的思维能力(Mucci and Stryker, 2023; Hughes et al., 2024)。鉴于ASI有可能在未来实现,我们有必要对ASI时代进行设想并做好准备。 然而,ASI的发展面临挑战,特别是当人类无法通过标注数据监督AI系统时,缺乏有效的指导信号。图1展示了在为ASI扩展高质量指导信号时面临的挑战。超级对齐被定义为“监督、控制和治理人工超智能系统的过程”(Jonker and McGrath, 2024; Jan Leike, 2023),并从监督和治理的角度包含了两个子目标。实现这些目标需要一个迭代的、共同发展的过程。

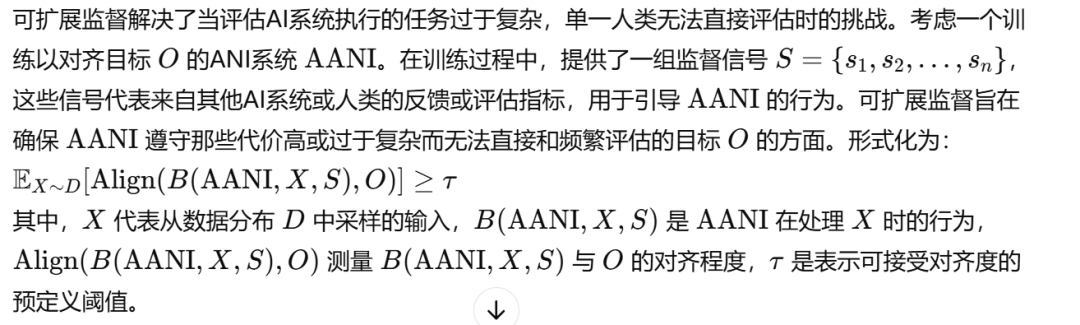

从监督角度来看,目标是构建高质量的指导信号,以增强模型的实用性。传统的训练方法,例如强化学习与人类反馈(RLHF)(Ouyang et al., 2022),一旦模型开始超越人类智能,就面临可扩展性问题。这就造成了一个关键瓶颈——无法提供足够高质量的指导信号来提升系统的有用性或能力。 从治理角度来看,目标是有效地调节模型的行为,确保它保持无害并与人类价值观对齐。如果没有稳健的治理,ASI可能表现出不可预测、有害,甚至灾难性的行为。例如,未对齐的ASI系统可能会追求不小心削弱人类能力或造成生存风险的目标,包括威胁人类灭绝。为了解决这个问题,必须不仅约束ASI的行为,还要确保这些系统以符合道德原则的方式运行。这个过程涉及开发引导先进AI系统的方法,确保它们保持有益和安全。超级对齐使得开发价值对齐的ASI成为可能,最大化对人类的利益。 当前的对齐范式,如强化学习与人类反馈(RLHF)(Christiano et al., 2017; Ouyang et al., 2022; Gulcehre et al., 2023)、监督微调(SFT)(Zhou et al., 2023; Rafailov et al., 2023)和上下文学习(ICL)(Gou et al., 2024; Xu et al., 2023),在将LLM与人类价值观和目标对齐方面表现出一定的前景(Wang et al., 2024)。RLHF利用人类反馈训练奖励模型,生成奖励信号帮助对齐语言模型与人类偏好。相对而言,SFT去除了强化奖励模型,直接使用人类反馈微调语言模型。而ICL则通过在推理过程中约束LLM的响应来对齐其输出与人类价值观,无需额外训练。 可扩展监督是源自超级对齐的概念,旨在开发可扩展的、高质量的监督信号,能够引导超越人类能力的AI系统,同时确保与人类价值观和目标的对齐(Amodei et al., 2016; Taylor et al., 2016; Olah, 2016)。然而,尽管RLHF、SFT和ICL已有进展,这些范式仍难以实现超级对齐的目标。 从监督角度来看,RLHF受限于人类反馈的可扩展性和可靠性。随着模型复杂性的增长,收集准确、一致且全面的反馈变得越来越困难,留下了指导信号的空白。类似地,SFT面临着策划和标注多样化且具有代表性的数据集的挑战,难以有效地微调ASI。尽管ICL完全绕过了训练过程,但在推理时依赖精心设计的提示,这在可扩展性和表达能力上本质上存在限制。从治理角度来看,RLHF和SFT在很大程度上依赖于人类监督的质量和意图,提出了关于反馈偏差和不一致性的问题。随着模型超越人类能力,误对齐的人类监督可能带来风险。而ICL则要求治理结构确保提示约束与更广泛的人类价值观对齐,这一过程难以标准化和执行。此外,先进AI系统的欺骗风险进一步使治理变得复杂(Yang et al., 2024a)。因此,缺乏可扩展的、高质量和多样化的监督信号仍然是实现超级对齐的瓶颈。 为了应对超级对齐的挑战,必须设计定制化的方法。随着模型朝着ASI发展,增强其在发展过程中的能力,同时引导其价值观和目标,以最大化对人类社会的利益,至关重要。 我们的目标是提供超级对齐问题的概述,包括其起源、历史背景和定义,以及当前超级对齐研究的状态和潜在解决方案。在第二节中,我们介绍ASI的概念、它带来的挑战以及当前对齐范式在解决超级对齐问题时的局限性。在第三节中,我们分析当前的可扩展监督技术,并讨论每种方法面临的具体挑战。在第四节中,我们总结了可扩展监督的关键挑战,并探讨了解决这些挑战的潜在路径。

2 概述

**2.1 术语定义

**人工狭义智能(ANI)**或“弱AI”是指被设计为在单一特定任务 TTT 上表现出色的AI系统。这些系统在任务上表现等同或低于人类水平,并且缺乏泛化能力。可以将其形式化为: AANI(T)≤H(T)\text{AANI}(T) \leq H(T)AANI(T)≤H(T) 其中,AANI(T)\text{AANI}(T)AANI(T) 代表ANI系统在任务 TTT 上的表现,而 H(T)H(T)H(T) 代表人类在同一任务和领域中的表现。ANI系统的例子包括语言翻译系统和游戏AI(例如象棋(Mucci 和 Stryker, 2023)和围棋(Silver et al., 2016))。 **人工通用智能(AGI)**是指超越ANI的理论跃升。AGI系统将拥有与人类相当的智能,并能够在广泛的任务和领域中展示通用能力(Bubeck et al., 2023; Fei et al., 2022; Goertzel, 2014; Pohl, 2015; Batin et al., 2017)。AGI系统能够泛化知识并适应新的挑战。可以将其形式化为: AAGI(Ti)=H(Ti),∀Ti\text{AAGI}(T_i) = H(T_i), \forall T_iAAGI(Ti)=H(Ti),∀Ti 其中,AAGI(Ti)\text{AAGI}(T_i)AAGI(Ti) 代表AGI系统在任务 TiT_iTi 上的表现,且任务集合 TiT_iTi 可以是一个潜在的无限集合(i→∞i \to \inftyi→∞),H(Ti)H(T_i)H(Ti) 代表人类在同一任务和领域中的表现。 **人工超智能(ASI)**是指在所有任务和领域中,AI系统超越人类智能并具备卓越的思维能力(Mucci 和 Stryker, 2023; Hughes et al., 2024)。ASI系统展示出优越的推理能力、创造力和适应性,形式上描述为: AASI(Ti)≫H(Ti),∀Ti\text{AASI}(T_i) \gg H(T_i), \forall T_iAASI(Ti)≫H(Ti),∀Ti 其中,"≫" 表示ASI系统在结果质量上超越人类智能。 尽管ASI目前距离实现还有很长的路要走,解决超级对齐问题却是及时且至关重要的,因为这能减轻灾难性风险(Pueyo, 2018)。积极的准备工作是必要的,因为ASI的出现可能会超越我们应对的能力,导致无法进行修正。此外,监督和治理必须作为互动过程共同进化,既增强AI的能力,又能同时减轻相关风险。

**2.2 超级对齐

超级对齐的目标是提升ASI的能力并使其对齐(Jonker 和 McGrath, 2024; Jan Leike, 2023)。超级对齐源于可扩展监督的概念,后者解决了当AI系统接近或超越人类智能时如何在可扩展的方式下引导其行为的问题。 可扩展监督正式定义为“确保给定AI系统遵守其目标中那些在训练过程中无法频繁评估的方面,这些评估代价高或不切实际” (Amodei et al., 2016)。这一概念表明,随着AI系统超越人类智能,必须采用能够提供可靠、高质量监督信号的方法。作为可扩展监督的特定应用,超级对齐关注的是将ASI与人类的价值观和意图对齐,同时提升其有效达成目标的能力。 形式上,超级对齐定义为“监督、控制和治理人工超智能系统的过程”(Jonker 和 McGrath, 2024),其目标是开发能够为ASI提供高质量监督信号的方法,指引其发展和行为,即使在缺乏直接人类监督或传统反馈机制(如人工标注数据或RLHF)的情况下(Amodei et al., 2016; Christiano et al., 2018)。随着AI能力的增长,这些传统方法变得越来越不足,因为人类监督所需的成本和专业知识越来越高。 自从大规模模型的出现和其能力的提升以来,超级对齐作为确保AI系统与人类价值观对齐并保持其能力的手段,已引起了广泛关注。为解决治理ASI的挑战,出现了可扩展监督技术,如夹击(sandwiching)和弱到强泛化(W2SG)等,这些方法被认为是有前景的解决方案。

**2.3 超级对齐方法概览与挑战

2.3.1 定义与形式化

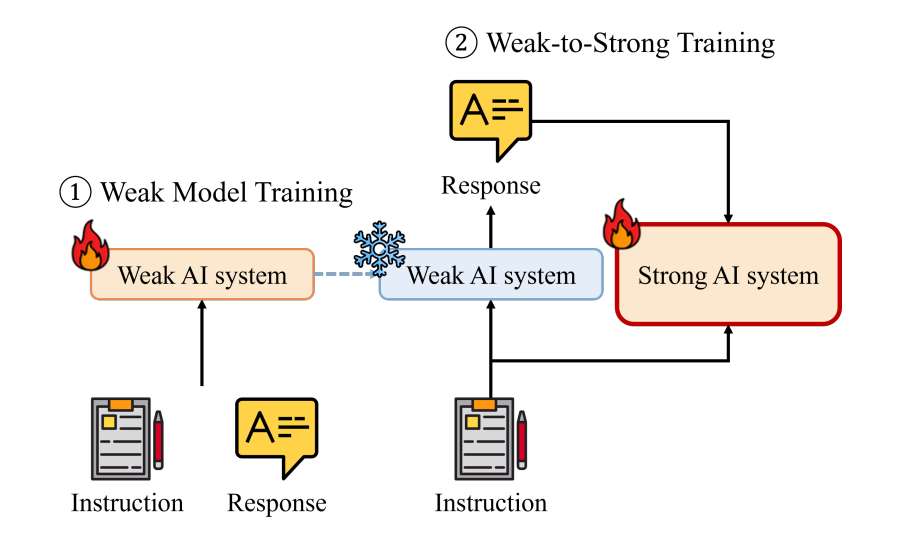

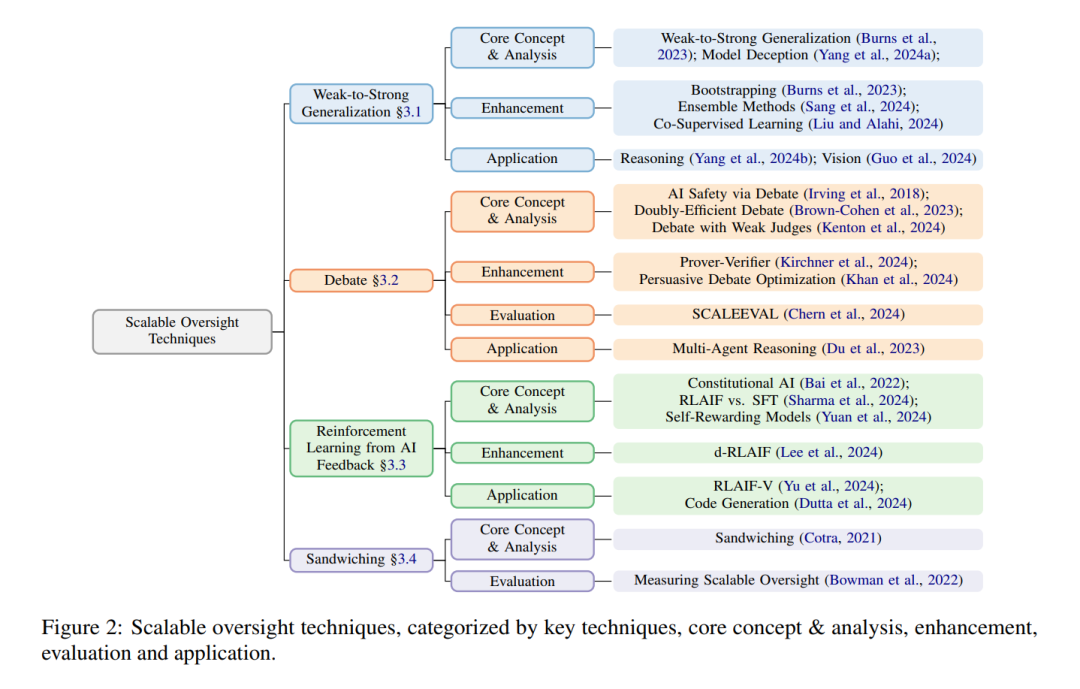

主要的挑战在于监督信号 SSS 的可扩展性。随着 AANI\text{AANI}AANI 接近或超越人类水平的能力,监督信号集 SSS 必须不断增加质量。 关键思想 可扩展监督是一种通过为超越人类智能的AI系统提供高质量监督信号来实现超级对齐的方法。它关注于评估和引导AI系统,而超级对齐则是确保AI系统始终与人类的价值观和目标对齐的最终目标。2.3.2 方法 可扩展监督已成为应对治理ASI挑战的有前景的解决方案。它使得高效地对齐具有复杂目标的AI系统成为可能,而这些目标通常过于昂贵或难以频繁评估。已有多种可扩展监督技术被提出,包括迭代蒸馏与扩展(IDA)(Christiano et al., 2018; Charbel-Raphaël, 2023)、递归奖励建模(RRM)(Leike et al., 2018)和合作逆向强化学习(Hadfield-Menell et al., 2016)。这些方法为当前的可扩展监督方法奠定了基础,如弱到强泛化、辩论、来自AI反馈的强化学习(RLAIF)和夹击(sandwiching)(Burns et al., 2023; Irving et al., 2018; Bai et al., 2022; Bowman et al., 2022)。图2展示了当前的可扩展监督技术及其方法论。 * ****弱到强泛化(W2SG)****是基于IDA(Christiano et al., 2018; Charbel-Raphaël, 2023)和RRM(Leike et al., 2018)的思想的实证研究。W2SG探索了在弱AI系统标签下训练的强AI系统是否能够超越精细调优后的弱AI系统的能力(Burns et al., 2023)。

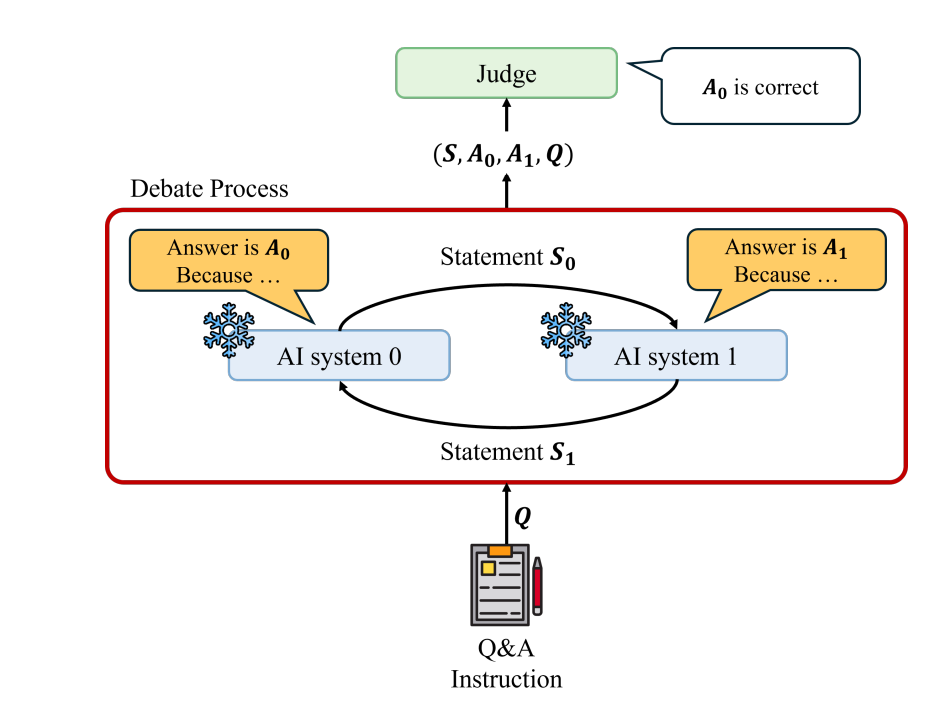

辩论涉及两个AI系统进行零和辩论,每个AI系统都旨在最大化其获胜的机会。裁判根据辩论者的陈述,确定最终的安全和有用的答案(Irving et al., 2018)。

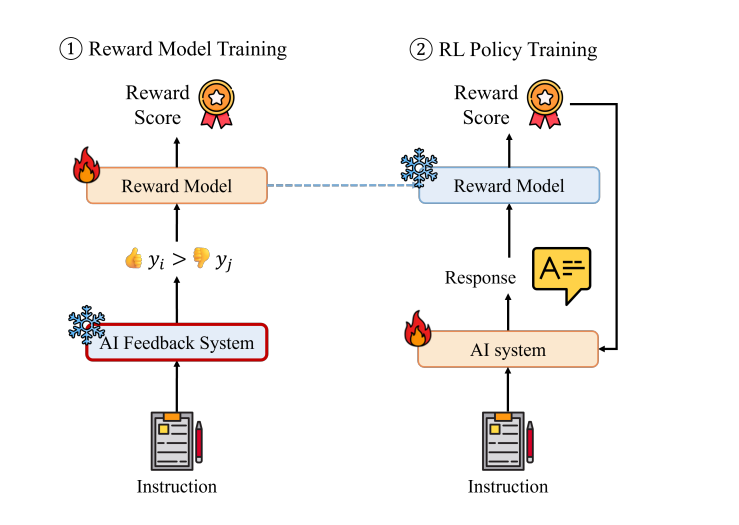

****来自AI反馈的强化学习(RLAIF)****是一种方法,用AI生成的反馈代替人类反馈,训练奖励模型并优化强化学习(RL)策略来实现对齐(Bai et al., 2022)。

夹击是一种方法,用来评估AI系统在较低能力(非专家)和较高能力(专家)人类之间的表现,模拟有限人类监督的场景(Cotra, 2021; Bowman et al., 2022)。

**挑战 **尽管可扩展监督方法具有潜力,但仍面临重要挑战。一个主要问题是辅助系统的可利用性,这些系统是这些方法的核心。例如,在训练和对齐中使用的辅助系统可能会被主要AI所利用,如在对抗性漏洞和奖励操纵(AdamGleave, 2023; Everitt et al., 2023)中所观察到的那样。此外,对抗性鲁棒性仍然是一个持久问题,尽管现有系统已经很先进,但它们仍容易受到对抗性攻击,这引发了对其在最坏情况下行为的担忧(AdamGleave, 2023)。