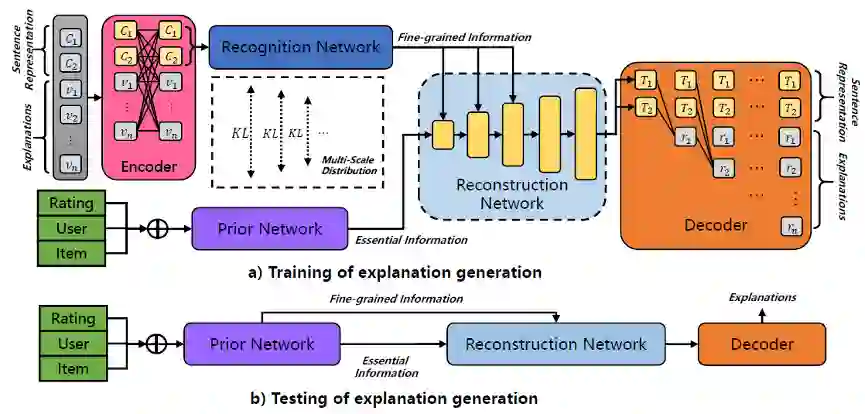

- 本文发现,当前模型为推荐系统生成的个性化解释往往单调宽泛,缺少关于用户和商品的特定信息。为了解决这个问题,本文提出了深度多尺度分布变分自编码器(Multi-Scale Distribution Deep Variational Autoencoders),通过先验网络对用户-商品对进行编码来生成对应隐变量。在我们的模型中,识别网络利用标签信息指导先验网络进行学习。同时,我们还设计了多尺度分布学习框架(Multi-scale distribution Learning Framework)帮助模型更容易地利用不同层次的信息。此外,我们进一步提出了目标追踪的KL散度(Target Tracking Kullback-Leibler divergence)以高效训练我们的多尺度架构。

- 在三个来自真实世界的推荐解释数据集上,我们的模型效果都显著地超越了以往的模型。消融实验及样例分析充分验证了我们设计思路的有效性,进一步展示了我们模型能够产生个性化程度更高的解释。

成为VIP会员查看完整内容

相关内容

专知会员服务

7+阅读 · 2022年3月12日

Arxiv

0+阅读 · 2022年4月16日

Arxiv

17+阅读 · 2021年3月19日