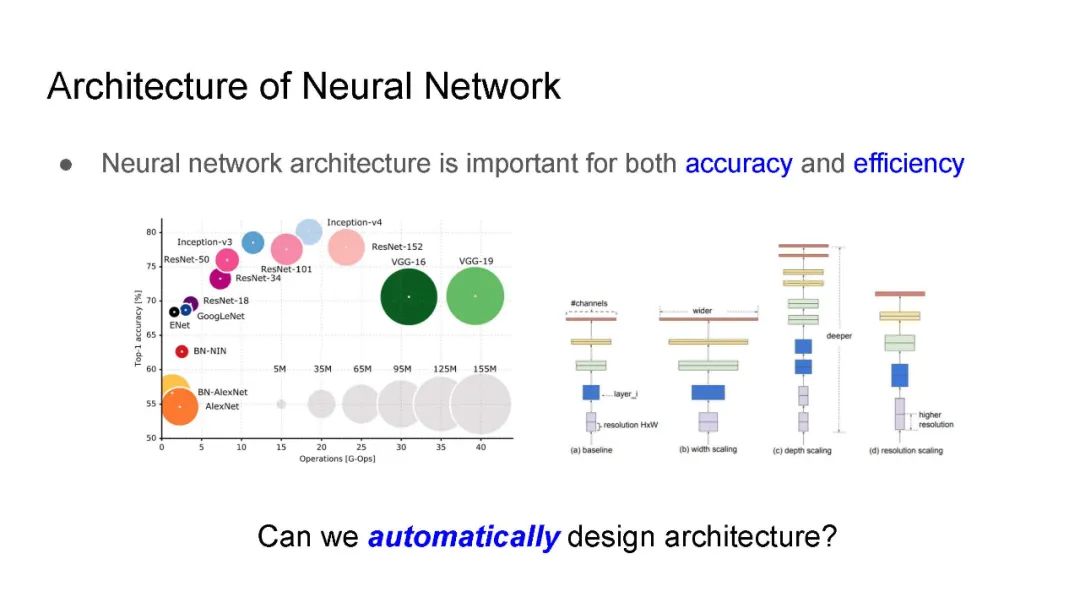

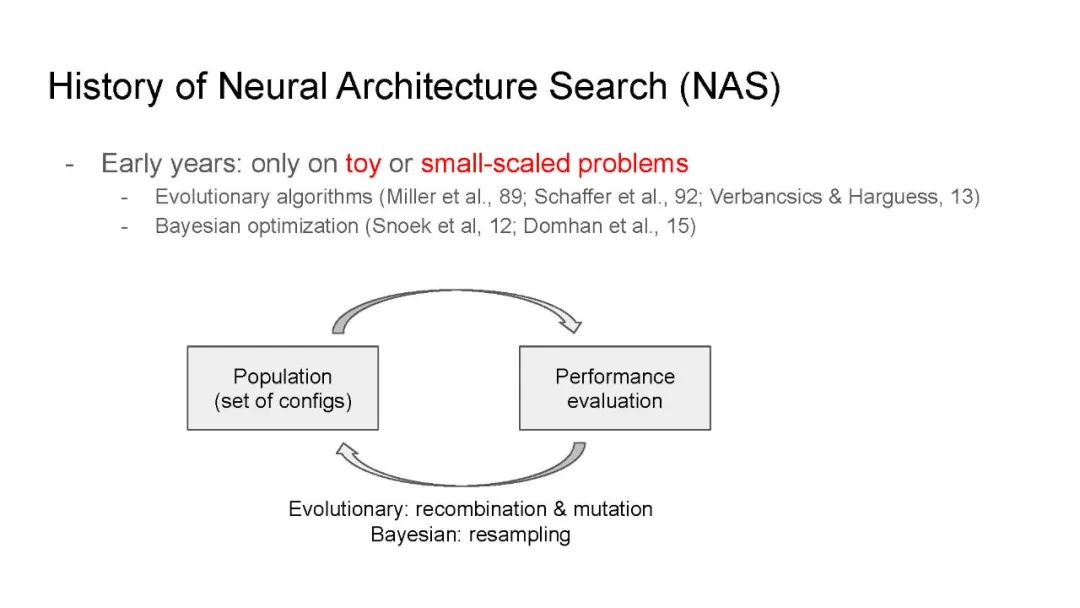

神经结构搜索(NAS)对于许多计算机视觉系统自动化神经网络体系结构的设计已经变得越来越重要。然而,由于搜索空间的指数级大小,许多经典的NAS算法需要数百天的GPU时间,这对于标准用户来说是不切实际的。最近,在提高NAS的效率方面已经取得了重大进展,甚至可以让普通用户在标准GPU机器上运行NAS。本教程旨在介绍和总结高效NAS的最新进展,使NAS能够应用于不同的任务集。

第一部分:介绍和历史

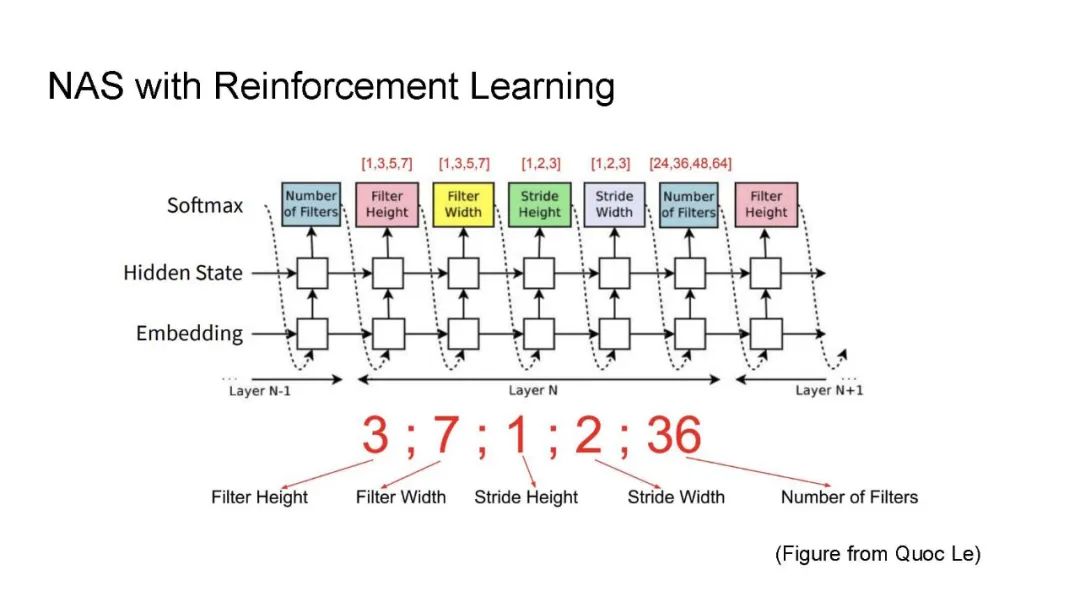

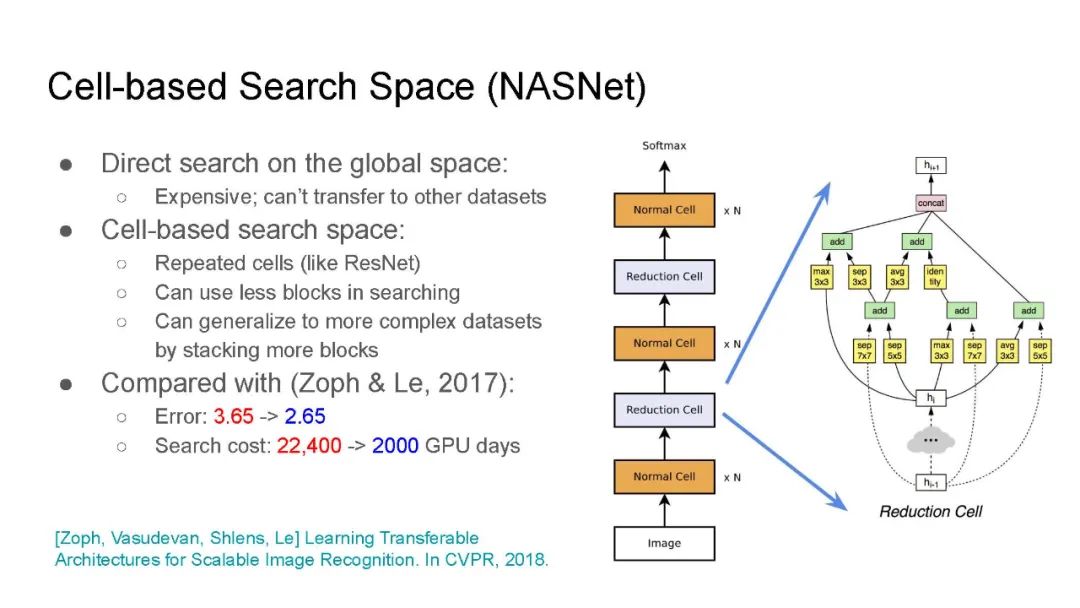

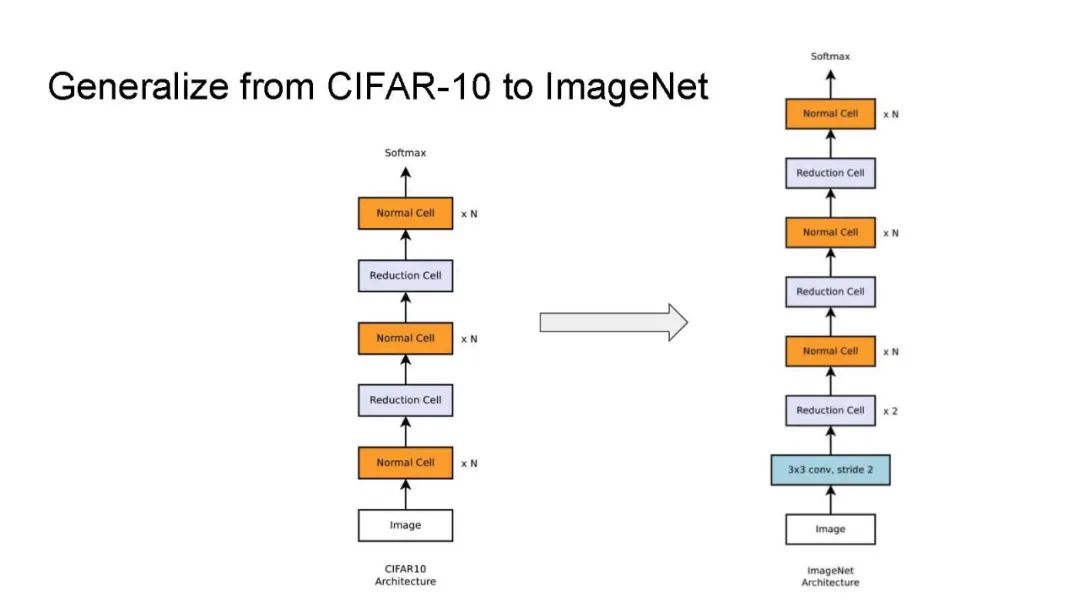

我们将从NAS的简要介绍开始,并回顾NAS的历史。

第二部分:可微NAS

这一部分介绍了可微NAS算法家族,该算法通过持续松弛和权值共享来加速NAS。从DARTS的开创性工作开始,我们将介绍超级网络训练、体系结构选择和可扩展性方面的最新改进。

第三部分:基于预测器和图神经网络的NAS

这一部分介绍了基于预测器的NAS算法家族,这些算法迭代优化代理性能预测器,并使用它对未探索的配置进行抽样。我们将介绍最近的进展,包括基于图神经网络(GNN)的预测器,改进的贝叶斯抽样,以及通过连续减半提高效率。

第四部分: 零样本NAS

这部分介绍了最近提出的一类新的NAS算法,该算法基于一些零射特性来估计体系结构的性能, 例如神经网络的一些基于图的特征,网络的表达性,以及神经切线核(NTK)的条件数。

第五部分:计算机视觉任务中的实际用例

我们将介绍NAS在实际计算机视觉问题中的几种应用,例如基于transformer 或CNN的分类、检测和语义聚类。

第六部分:结论与未来发展方向

该部分将对NAS的研究现状进行总结,并指出未来研究的重要方向。

成为VIP会员查看完整内容