最近,ChatGPT与DALL-E-2[1]和Codex[2]一起受到了社会的广泛关注。因此,许多人对相关资源感兴趣,并试图揭开其令人印象深刻的性能背后的背景和秘密。**事实上,ChatGPT和其他生成式AI (GAI)技术属于人工智能生成内容(AIGC)的范畴,它涉及通过AI模型创建数字内容,如图像、音乐和自然语言。AIGC的目标是使内容创建过程更加高效和可访问,允许以更快的速度生产高质量的内容。**AIGC是通过从人类提供的指令中提取和理解意图信息,并根据其知识和意图信息生成内容来实现的。近年来,大规模模型在AIGC中变得越来越重要,因为它们提供了更好的意图提取,从而改善了生成结果。随着数据和模型规模的增长,模型可以学习的分布变得更加全面和接近现实,从而产生更加真实和高质量的内容。**本文全面回顾了生成模型的历史,基本组件,以及AIGC的最新进展,从单模态交互和多模态交互。**从单模态的角度,介绍了文本和图像的生成任务和相关模型。从多模态的角度出发,介绍上述模态之间的交叉应用。最后讨论了AIGC存在的开放问题和未来的挑战。

1. 引言

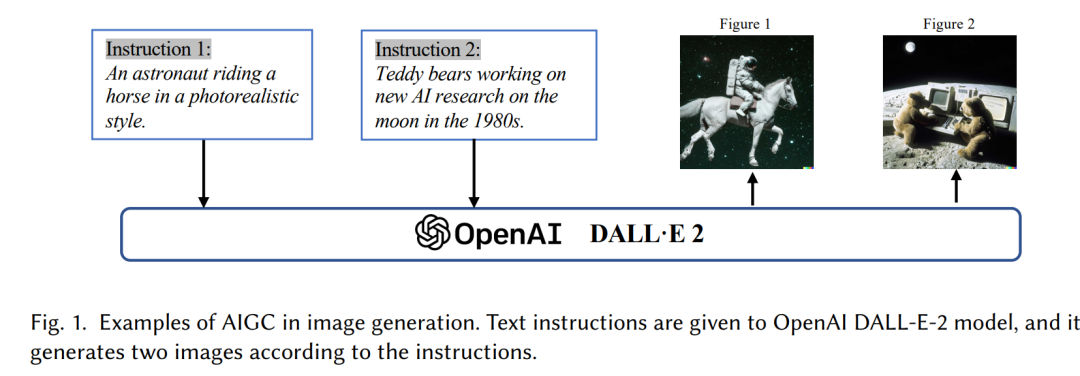

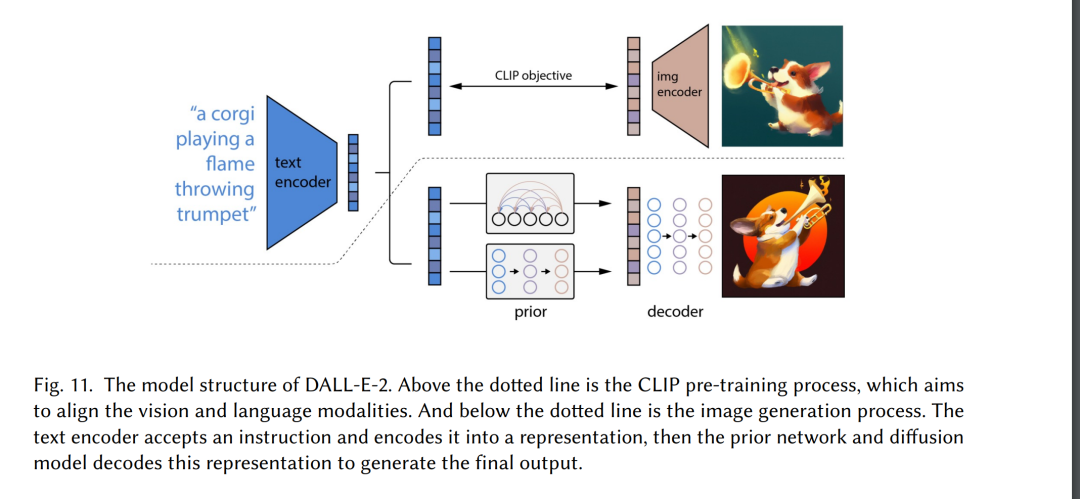

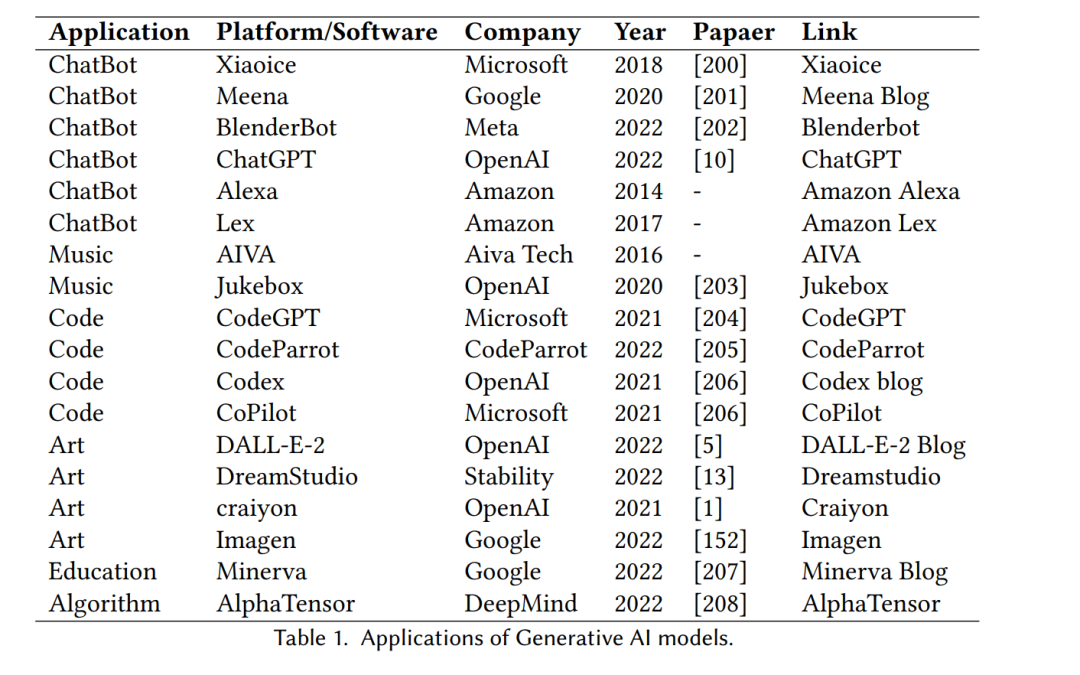

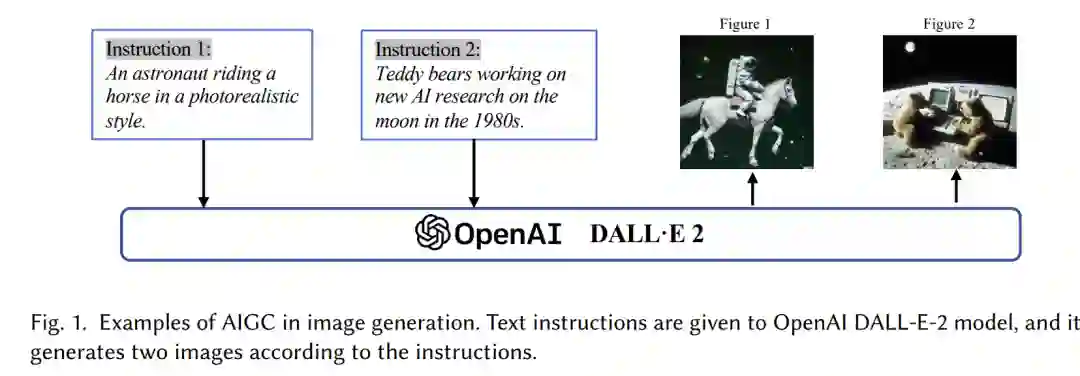

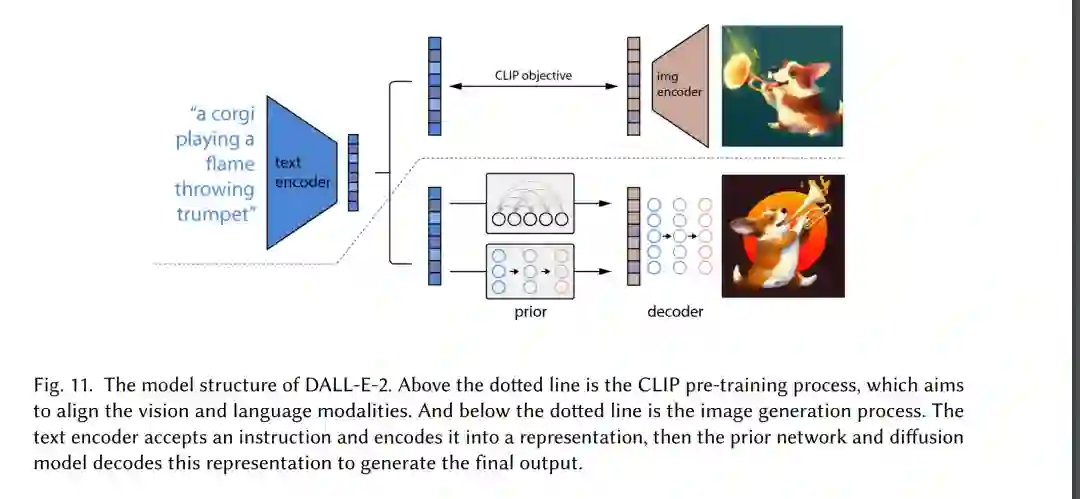

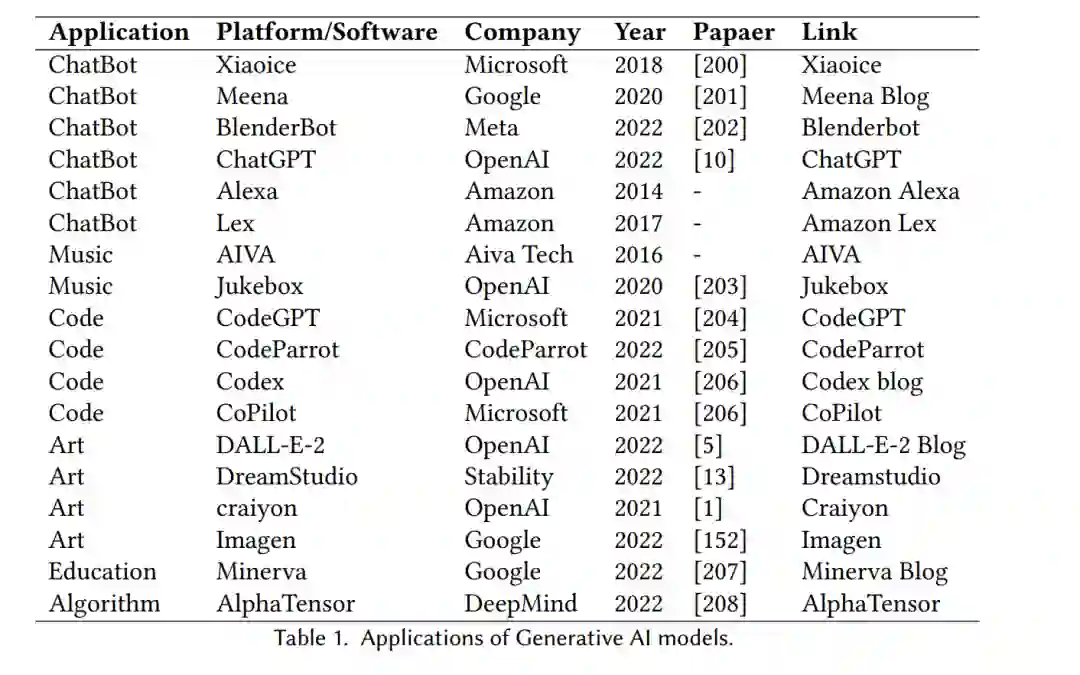

近年来,人工智能生成内容(Artificial Intelligence Generated Content, AIGC)受到了计算机科学界以外的广泛关注,全社会开始关注大型科技公司[3]构建的各种内容生成产品,如ChatGPT[4]和DALL-E2[5]。AIGC指的是使用高级生成AI (GAI)技术生成的内容,而不是由人类作者创建的内容,AIGC可以在短时间内自动创建大量内容。例如,ChatGPT是OpenAI开发的用于构建对话式人工智能系统的语言模型,可以有效地理解并以有意义的方式响应人类的语言输入。此外,DALL-E-2是另一个最先进的GAI模型,也是由OpenAI开发的,它能够在几分钟内从文本描述中创建独特的高质量图像,如图1所示的“一个宇航员以逼真的风格骑马”。随着AIGC的卓越成就,许多人认为这将是人工智能的新时代,并将对整个世界产生重大影响。

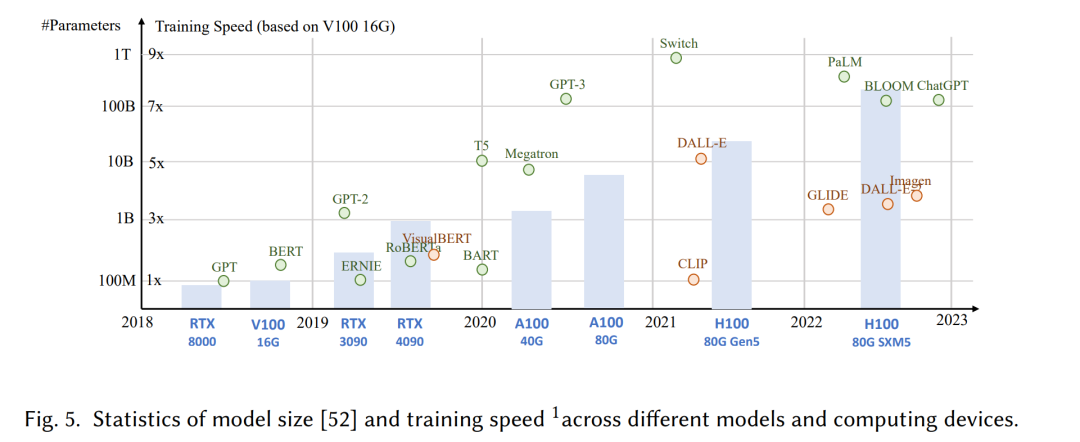

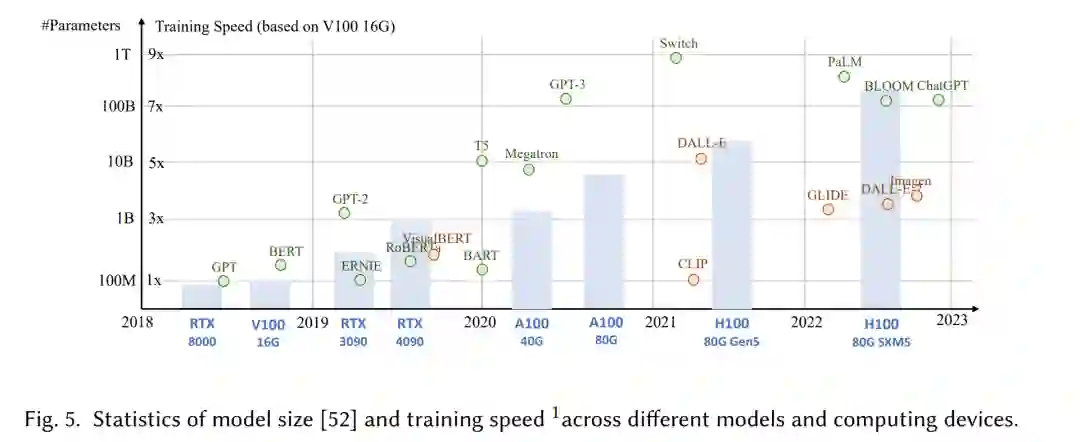

**从技术上讲,AIGC是指给定人工指令,可以帮助教学和指导模型完成任务,利用GAI算法生成满足指令的内容。**该生成过程通常包括两个步骤:从人工指令中提取意图信息和根据提取的意图生成内容。然而,如之前的研究[6,7]所示,包含上述两个步骤的GAI模型的范式并不完全新颖。与之前的工作相比,最近的AIGC的核心进展是在更大的数据集上训练更复杂的生成模型,使用更大的基础模型架构,并能够访问广泛的计算资源。例如,GPT-3的主框架保持与GPT-2相同,但预训练数据大小从WebText 8增长到CommonCrawl9,基础模型大小从1.5B增长到175B。因此,在人类意图提取等任务上,GPT-3比GPT-2具有更好的泛化能力。

除了数据量和计算能力增加带来的好处,研究人员还在探索将新技术与GAI算法集成的方法。例如,ChatGPT利用来自人类反馈的强化学习(RLHF)[10-12]来确定给定指令的最适当响应,从而随着时间的推移提高模型的可靠性和准确性。这种方法使ChatGPT能够更好地理解人类在长对话中的偏好。同时,在计算机视觉领域,由Stability提出了稳定扩散[13]。AI在2022年也在图像生成方面取得了巨大成功。与之前的方法不同,生成扩散模型可以通过控制探索和利用之间的权衡来帮助生成高分辨率图像,从而将生成图像的多样性和与训练数据的相似性和谐地结合起来。

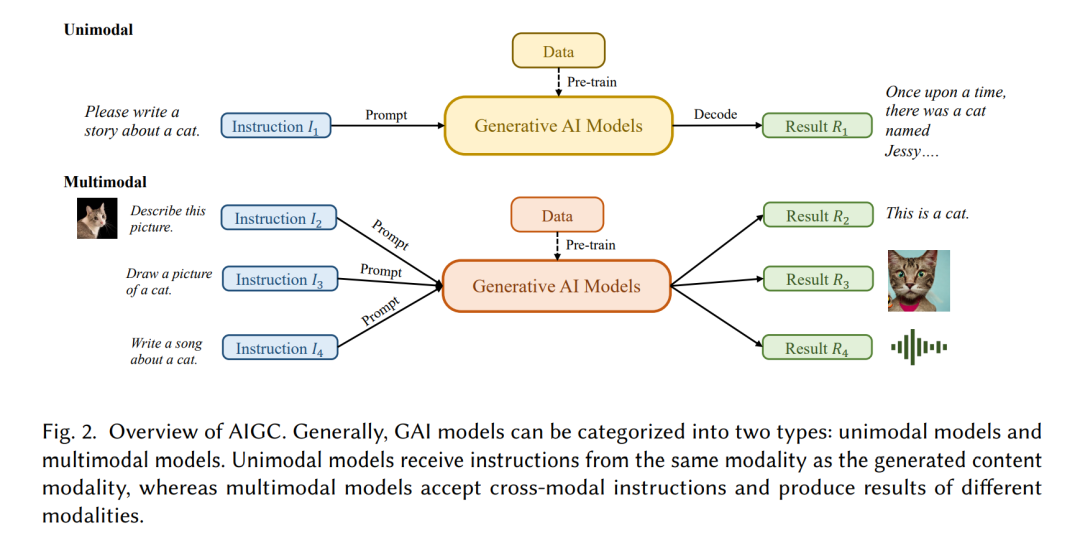

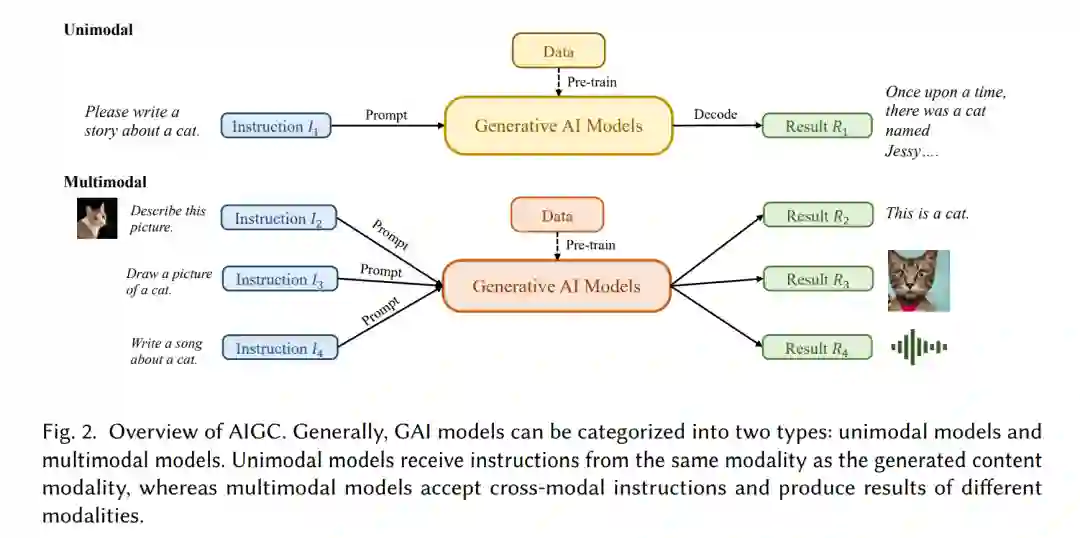

结合这些进展,模型在AIGC任务上取得了显著进展,并被应用于各个行业,包括艺术[14]、广告[15]、教育[16]等。在不久的将来,AIGC将继续成为机器学习的一个重要研究领域。因此,对过去的研究进行广泛的调研并确定该领域的开放问题至关重要。对AIGC领域的核心技术和应用进行了综述。 **这是对AIGC的首次全面综述,从技术和应用两个方面对GAI进行了总结。之前的研究从不同的角度关注GAI,包括自然语言生成[17],图像生成[18],多模态机器学习中的生成[7,19]。**然而,之前的工作只关注AIGC的特定部分。本文首先回顾了AIGC中常用的基础技术。进一步对先进的GAI算法进行了全面的总结,包括单峰生成和多峰生成,如图2所示。此外,还讨论了AIGC的应用和潜在挑战。最后指出了该领域存在的问题和未来的研究方向。

综上所述,本文的主要贡献如下:

据我们所知,我们是第一个为AIGC和AI增强生成过程提供正式定义和彻底调研的人。

回顾了AIGC的历史和基础技术,并从单模态生成和多模态生成的角度对GAI任务和模型的最新进展进行了全面分析。

讨论了AIGC面临的主要挑战以及AIGC未来的研究趋势。

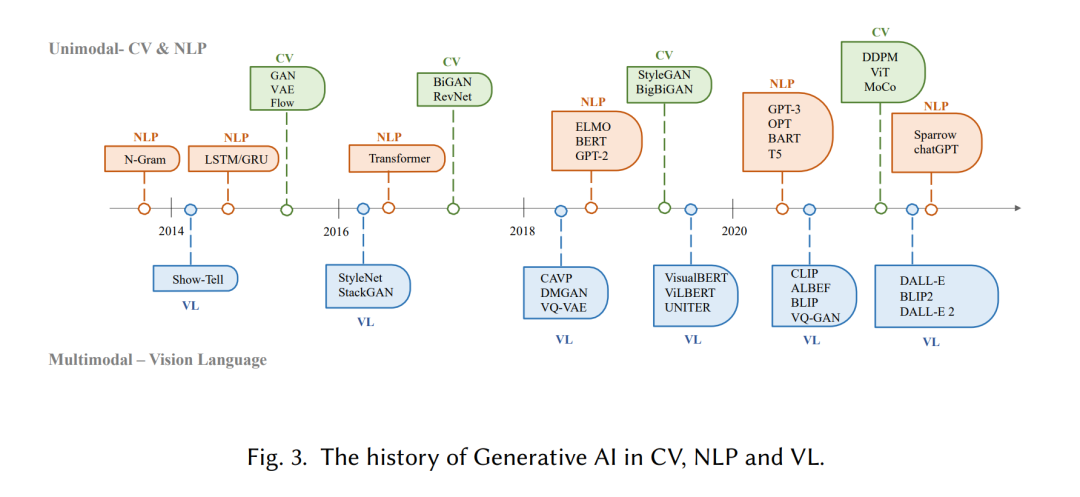

调研的其余部分组织如下。第二节主要从视觉模态和语言模态两个方面回顾了AIGC的历史。第3节介绍了目前在GAI模型训练中广泛使用的基本组件。第4节总结了GAI模型的最新进展,其中第4.1节从单模态角度回顾了进展,第4.2节从多模态生成的角度回顾了进展。在多模态生成中,介绍了视觉语言模型、文本音频模型、文本图模型和文本代码模型。第5节和第6节介绍了GAI模型在AIGC中的应用以及与该领域相关的一些重要研究。第7、8节揭示了AIGC技术存在的风险、存在的问题和未来的发展方向。最后,我们在9中总结了我们的研究。2. 生成式人工智能的历史生成模型在人工智能领域有着悠久的历史,可以追溯到20世纪50年代,隐马尔可夫模型(HMM)[20]和高斯混合模型(GMMs)[21]的发展。这些模型生成了语音和时间序列等顺序数据。然而,直到深度学习的出现,生成模型才在性能上看到了显著的改进。

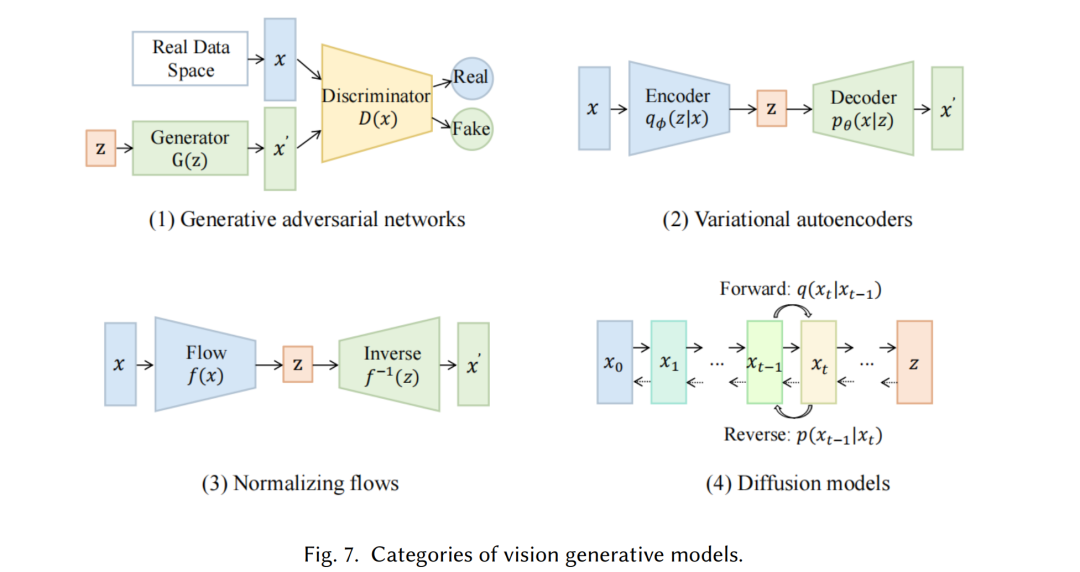

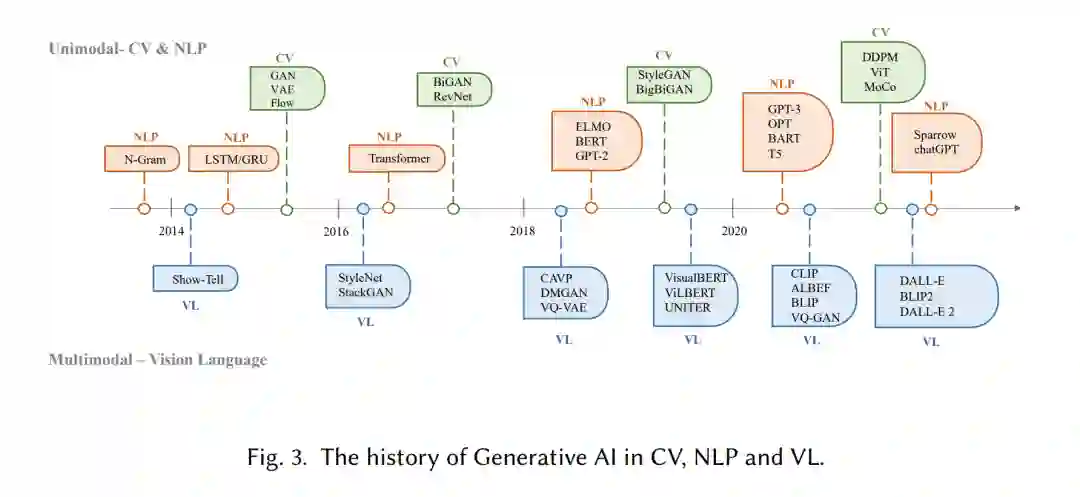

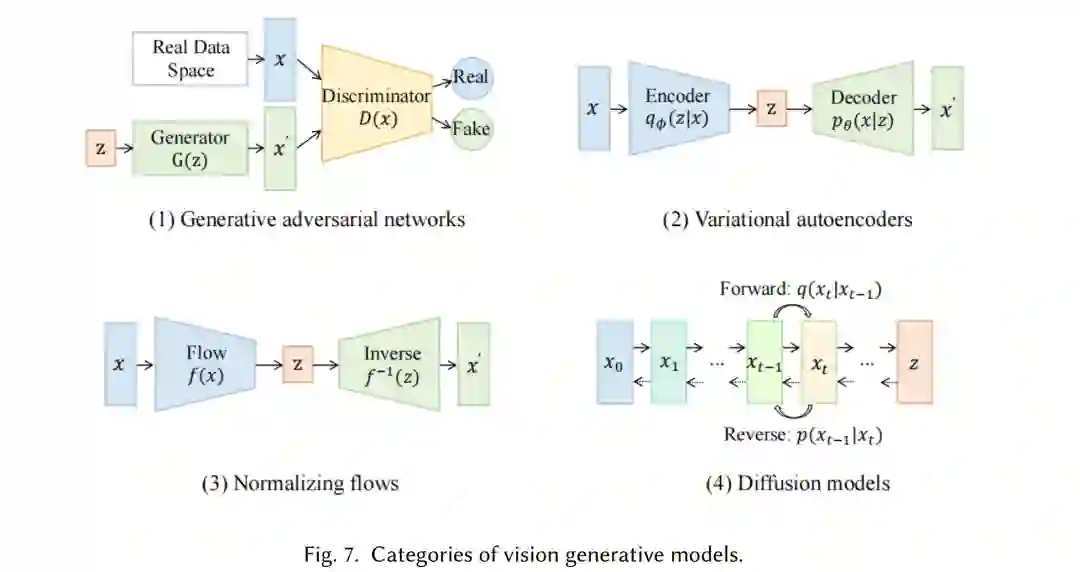

在早期的深度生成模型中,不同的领域通常没有太多的重叠。在自然语言处理(NLP)中,传统的生成句子的方法是使用N-gram语言建模[22]学习单词分布,然后搜索最佳序列。然而,该方法不能有效地适应长句子。为了解决这个问题,循环神经网络(RNN)[23]后来被引入到语言建模任务中,允许对相对较长的依赖关系进行建模。随后,长短期记忆(LSTM)[24]和门控循环单元(GRU)[25]的发育,它们利用门控机制在训练过程中控制记忆。这些方法能够处理样本[26]中的约200个标记,与N-gram语言模型相比,这是一个显著的改进。 同时,在计算机视觉(CV)领域,在基于深度学习的方法出现之前,传统的图像生成算法使用纹理合成[27]和纹理映射[28]等技术。这些算法基于手工设计的特征,在生成复杂多样的图像方面能力有限。2014年,生成对抗网络(Generative Adversarial Networks, GANs)[29]被首次提出,在各种应用中取得了令人印象深刻的结果,是该领域的一个重要里程碑。变分自动编码器(vae)[30]和其他方法,如扩散生成模型[31],也已开发用于对图像生成过程进行更细粒度的控制和生成高质量图像的能力

生成模型在不同领域的发展遵循不同的路径,但最终出现了交叉的问题:transformer架构[32]。Vaswani等人在2017年引入了NLP任务,Transformer后来被应用于CV中,然后成为不同领域许多生成模型的主要骨干[9,33,34]。在NLP领域,许多著名的大型语言模型,如BERT和GPT,采用transformer架构作为其主要的构建块,比之前的构建块(如LSTM和GRU)具有优势。在CV中,Vision Transformer (ViT)[35]和Swin Transformer[36]后来通过将Transformer架构与视觉组件相结合,进一步发展了这一概念,使其可以应用于基于图像的下游。除了transformer给单个模态带来的改进之外,这种交叉还使来自不同领域的模型能够融合在一起,以完成多模态任务。多模态模型的一个例子是CLIP[37]。CLIP是一种视觉-语言联合模型,将transformer架构与视觉组件相结合,允许它在大量文本和图像数据上进行训练。由于它在预训练时结合了视觉和语言知识,因此也可以作为多模态提示生成中的图像编码器。总而言之,基于transformer的模型的出现彻底改变了人工智能的产生,并导致了大规模训练的可能性。

近年来,研究人员也开始引入基于这些模型的新技术。例如,在NLP中,人们有时喜欢少样本提示[38],而不是微调,这是指在提示中包括从数据集中选择的一些示例,以帮助模型更好地理解任务需求。在视觉语言中,研究人员经常将特定模态模型与自监督对比学习目标相结合,以提供更鲁棒的表示。在未来,随着AIGC越来越重要,会有越来越多的技术被引入,让这个领域充满活力。

3. 生成式人工智能

我们将介绍最先进的单模态生成模型。这些模型被设计为接受特定的原始数据模态作为输入,例如文本或图像,然后以与输入相同的模态生成预测。我们将讨论这些模型中使用的一些最有前途的方法和技术,包括生成语言模型,如GPT3[9]、BART[34]、T5[56]和生成视觉模型,如GAN[29]、VAE[30]和归一化流[57]。

多模态模型

多模态生成是当今AIGC的重要组成部分。多模态生成的目标是通过学习数据[7]的多模态连接和交互来学习生成原始模态的模型。模态之间的这种连接和相互作用有时是非常复杂的,这使得多模态表示空间与单模态表示空间相比很难学习。然而,随着前面提到的强大的特定于模式的基础架构的出现,越来越多的方法被提出来应对这一挑战。在本节中,我们将介绍视觉语言生成、文本音频生成、文本图形生成和文本代码生成中的最先进的多模态模型。由于大多数多模态生成模型总是与实际应用高度相关,本节主要从下游任务的角度进行介绍。

4. 应用

5. 效率

在过去的十年中,具有神经网络的深度生成式人工智能模型一直主导着机器学习领域,其崛起归功于2012年的ImageNet竞赛[210],这导致了一场创建更深入和更复杂模型的竞赛。这种趋势也出现在自然语言理解领域,像BERT和GPT-3这样的模型已经开发出了大量参数。然而,不断增加的模型占用空间和复杂性,以及训练和部署所需的成本和资源,给现实世界中的实际部署带来了挑战。核心挑战是效率,可以分解如下:

推理效率: 这与部署用于推理的模型的实际考虑有关,即为给定的输入计算模型的输出。推理效率主要与推理期间模型的大小、速度和资源消耗(例如,磁盘和RAM使用)有关。 * 训练效率: 这涵盖了影响训练模型的速度和资源需求的因素,如训练时间、内存占用和跨多个设备的可伸缩性。它还可能包括考虑在给定任务上实现最佳性能所需的数据量。