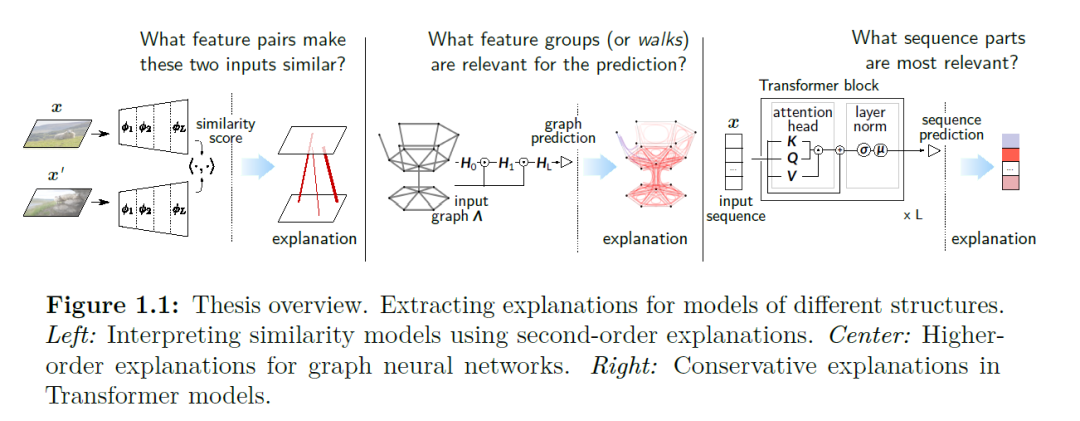

**可解释人工智能旨在使复杂的机器学习模型可解释。获得透明的预测过程对于确保机器学习在科学、工业和社会中的安全、可信和公平使用至关重要。**不幸的是,许多广泛使用的模型,如深度相似度模型、图神经网络和Transformer模型,都是高度非线性和结构化的,对提取有意义的解释提出了挑战。 成熟的逐层相关传播解释方法以深度泰勒分解为理论基础,可作为方法锚,开发考虑特定模型结构的解释技术。研究了如何解释Transformer模型中的点积相似性、图神经网络预测和自注意力模块。这可能需要在导致二阶和高阶属性的输入特征方面超越标准解释。这促使将现有的解释技术评估和可视化方法扩展到这些新类型的解释。

在这些方法贡献的同时,研究了这些方法如何在不同的领域应用中使用。特别地,我们将不同的解释方法应用于各种用例。构建和解释了一个相似模型,旨在表示数字人文中的数字内容,以研究科学史的演变,通过可视化不同处理层的相关流来重新审视图像分类,转向自然语言处理,以调查Transformer模型中的性别偏见,以及分析任务解决过程中的Transformer解释。实验和分析表明,在解释方法中仔细处理模型结构,可以提高其保真度,产生更好的解释,并产生新的见解。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年4月14日

Arxiv

2+阅读 · 2023年4月13日