【牛津大学博士论文】深度迁移学习贝叶斯推断,157页pdf

自深度学习革命以来,机器学习文献中的一个总体趋势是大型深度模型将持续优于小型浅模型。然而,这种趋势也带来了计算需求不断增加的缺点,最近许多最先进的成果所需的资源远远超出了顶级行业实验室的范围。这些问题引发了关于机器学习研究民主化的非常现实的担忧,如果不加以解决,最终可能会导致更多的权力和财富集中在今天能够向其人工智能研究项目投资巨额资金的机构中。

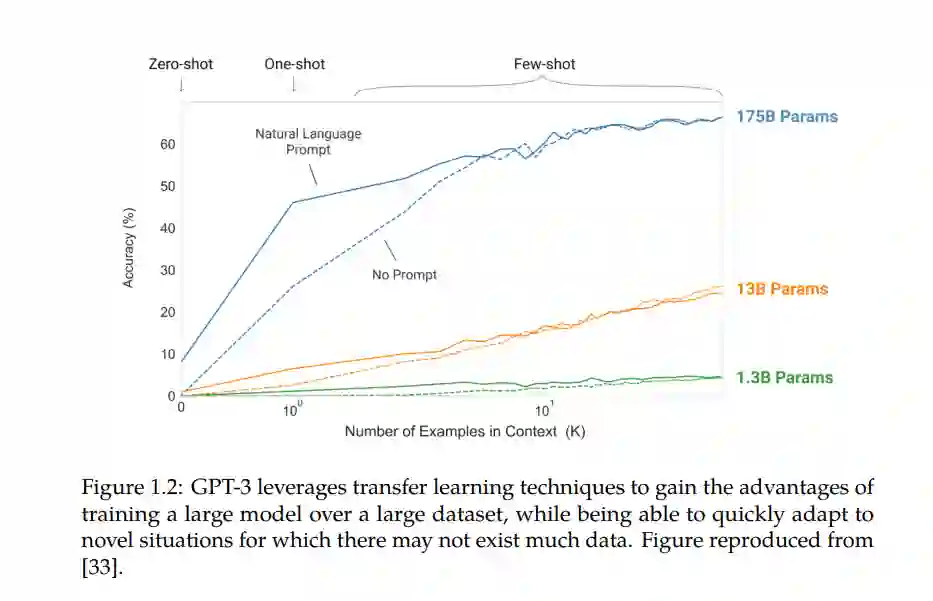

迁移学习技术是这些问题的潜在解决方案,它允许大型的、通用的模型经过一次训练,然后在各种情况下重用,只需要最少的计算来适应它们。本文探索了迁移学习的新算法和应用,包括分层强化学习、生成式建模和计算社会科学等领域。在分层强化学习领域内,本文提出一种算法,允许在选项之间迁移(即在不同的选项之间迁移)。例如,时间上抽象的动作),用于独立但相似的任务。在生成建模领域,我们提出了一种算法,可以在新的数据上重用现有的可逆生成模型,而不产生任何额外的训练成本。最后,在计算社会科学领域,本文表明,可以从人类设计的模型中迁移知识,以检测针对排名算法的恶意活动。

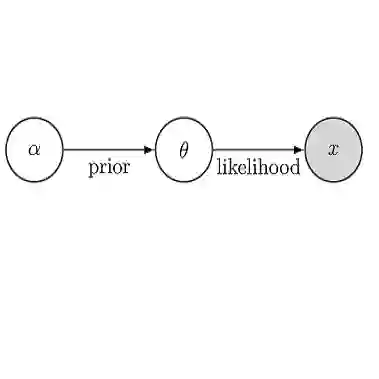

在这篇论文中提出的所有算法之间的共同线索是它们本质上是贝叶斯的。我们认为,贝叶斯范式自然适合于迁移学习应用,因为贝叶斯先验可以作为适应性强的通用模型,通过推理过程可以转换为特定任务的后验。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“T157” 就可以获取《【牛津大学博士论文】深度迁移学习贝叶斯推断,157页pdf》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月19日