【牛津大学博士论文】学习和解释来自多模态数据的深度表示,267页pdf

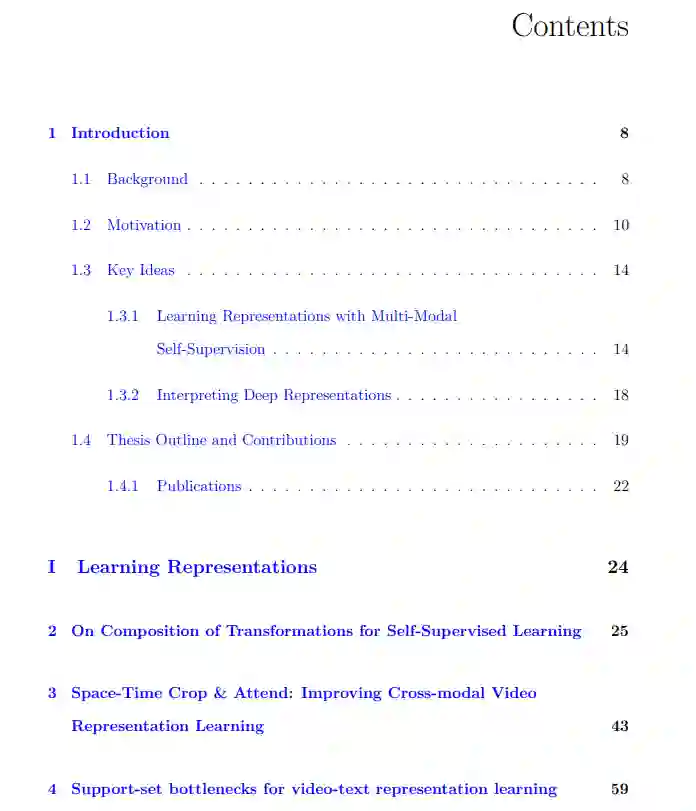

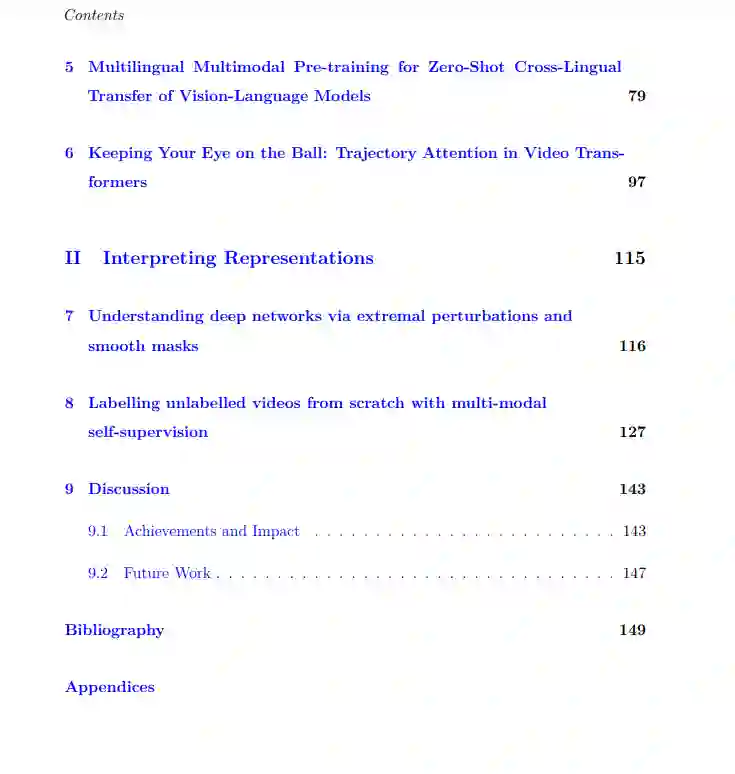

深度学习在多个领域都取得了突破性进展,从图像、语言和视频理解等核心机器学习任务,到医疗、自动驾驶和农业等现实行业。它的成功是通过为神经网络提供人工监督,从大型标记数据集(如ImageNet)自动学习分层数据表示。然而,获取大规模的标签数据通常是一个非常耗时和昂贵的过程。为应对这一挑战,本文挑战多模态视频数据的自监督极限。视频数据通常包含多种形式,如图像、音频、转录语音和可免费获得的文本标题。这些模态通常共享冗余语义信息,因此可以作为伪标签来监督彼此进行表示学习,而不需要使用人工标签。在不依赖标签数据的情况下,我们能够在从互联网收集的数百万个视频剪辑的非常大规模的视频数据上训练这些深度表示。通过在各种领域建立新的最先进的性能,展示了多模态自监督的可扩展性好处:视频动作识别、文本到视频检索、文本到图像检索和音频分类。我们还引入了数据转换、模型架构和损失函数方面的其他技术创新,以使用多模态自监督进一步改进对这些深度视频表示的学习。本文的第二个贡献是改进深度表示的可解释性的新工具,因为要破译这些深度表示中编码的关键特征是非常困难的。对于图像,我们展示了如何使用摄动分析来分析网络的中间表示。对于视频,我们提出了一种新的聚类方法,使用Sinkhorn-Knopp算法将深度视频表示映射到人类可解释的语义伪标签。本论文的研究成果为进一步提高深度视频表示学习的可扩展性和可解释性做出了贡献。

https://ora.ox.ac.uk/objects/uuid:3a0721a0-025e-423c-b441-2d7af5d960da

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“m267” 就可以获取《 【牛津大学博士论文】学习和解释来自多模态数据的深度表示,267页pdf》专知下载链接