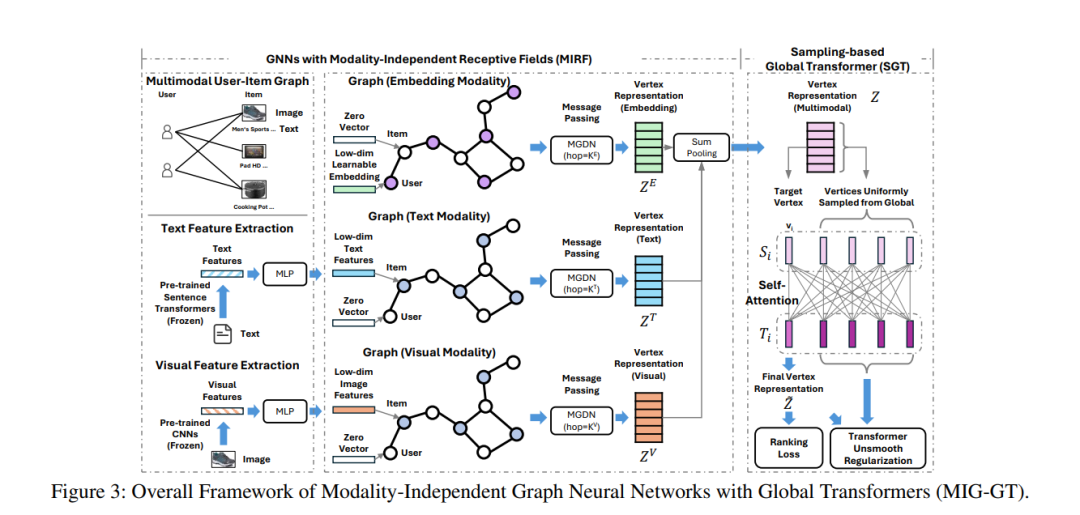

多模态推荐系统可以通过现有的用户-物品交互以及与物品相关的多模态数据的语义,来学习用户的偏好。许多现有方法通过多模态用户-物品图来建模这一过程,将多模态推荐视为图学习任务。图神经网络(GNNs)在这一领域展现了良好的性能。先前的研究利用了GNNs在特定感受野(通常由跳数K表示)内捕获邻域信息的能力,以丰富用户和物品的语义。我们观察到,GNNs的最佳感受野在不同模态之间可能有所不同。本文提出了具有模态无关感受野的GNNs,这些GNNs为不同模态采用独立的感受野,以提升性能。我们的结果表明,某些数据集上,某些模态的最佳K值可以低至1或2,这可能会限制GNNs捕获全局信息的能力。为了解决这个问题,我们引入了基于采样的全局变换器(Sampling-based Global Transformer),通过均匀全局采样来有效地将全局信息整合进GNNs。我们进行的全面实验表明,我们的方法优于现有方法。我们的代码已经公开。

成为VIP会员查看完整内容

相关内容

Arxiv

36+阅读 · 2023年4月19日

Arxiv

180+阅读 · 2023年4月7日