通过视频生成学习世界的知识学习大规模视频生成模型为通过互联网规模的视频数据学习视觉世界提供了一个关键途径。学习生成准确的视频需要模型对现实世界的概念有深刻理解,如运动、物理、物体交互和三维一致性。在本论文中,我将展示我的研究,旨在解决视频生成模型的基本架构和扩展中的核心瓶颈,以及这种视频模型在下游任务中的应用。论文的第一部分,我将通过开发各种方法,解决视频生成模型中的计算瓶颈,学习良好压缩的时空层次表示。具体来说,我首先介绍VideoGPT,在该方法中,我们通过一个简单的3D CNN自编码器来学习一个压缩的潜在空间,该自编码器同时在空间和时间上对视频的像素表示进行下采样——这样,当在该潜在空间中学习视频生成模型时,可以大幅节省计算量。接下来,我研究了在TECO中实现更高效的视频生成架构,该架构能够扩展到长时间序列的视频。我随后介绍了ElasticTok,这是一种通过利用自适应表示和可变长度编码更高效地编码视频数据的方法。接下来,我将重点讨论扩展到更长上下文的算法方法。在Large World Model中,我们展示了稳定训练长上下文模型的核心训练方法,使用的是混合了语言、视频和图像数据,能够处理多达数百万个标记的训练数据。最后,我将展示两项关于探索使用预训练视频生成模型进行下游任务的研究。在第一篇论文中,我介绍了VIPER,在该方法中,我们使用视频预测模型的似然度作为奖励信号来学习强化学习代理。接着,我介绍了MoCA,我们展示了视频生成模型可以用来执行复杂的视频编辑任务。 引言

学习具有一般智能的系统需要对底层物理世界有深入的理解,包括运动、物理学、物体交互和三维理解等概念。最近,基于简单生成建模目标的语言模型扩展取得了令人惊讶的成果,能够应对诸如数学、科学和编程等难度较高的任务。类比地,我们能否利用大规模生成模型在视频数据上,为人工智能系统获取有关物理概念的知识?直观地讲,准确地生成短视频需要理解基本的运动和简单的三维一致性,例如当相机稍微向左或向右平移时的变化。生成更长的视频则需要学习数据中的长期依赖关系,比如在电影中编排一致的叙事,或在生成房屋虚拟导览时保持全球三维一致性。 生成模型的前期研究已经提供了大多数扩展所需的工具。Transformers [267] 是强大且通用的机器学习架构,已经证明在多种模态下有效,如语言、音频、视频和蛋白质。这些模型也很容易通过常见的模型或激活分片技术(如 FSDP [68]、张量并行 [228] 和流水线并行 [110])在数千个计算芯片上进行扩展训练。最后,最近在生成建模训练目标(如离散标记的自回归模型或扩散模型)上的进展,展示了在建模高度复杂分布方面的能力。 然而,视频数据的极高维度仍然是视频生成模型中的一个关键瓶颈——一个1080p高清、24FPS、长一分钟的视频需要大约90亿个浮点数来表示,或者需要36GB的存储空间才能加载到计算设备上。这导致了计算开销极大的模型,使得其扩展成本更高。语言模型中的标记化方法已经证明在降低数据维度方面非常有效,使得4K标记大约可以编码6页文本内容,但类似数量的视频标记最多只能表示几秒钟的视频数据。当视频分辨率或时长更大时,即便是在现有的大规模计算集群上,这种方法变得更加昂贵。因此,开发更高效的视频生成架构变得至关重要,这些架构不仅能够扩展到高分辨率和长视频,同时还能够建模这些复杂的视觉分布。 此外,如何利用通过视频生成模型学习到的世界知识仍然不够明确,因为与语言模型一样,如何有效地提示这些模型来完成更通用的任务更为困难。

1.1 贡献

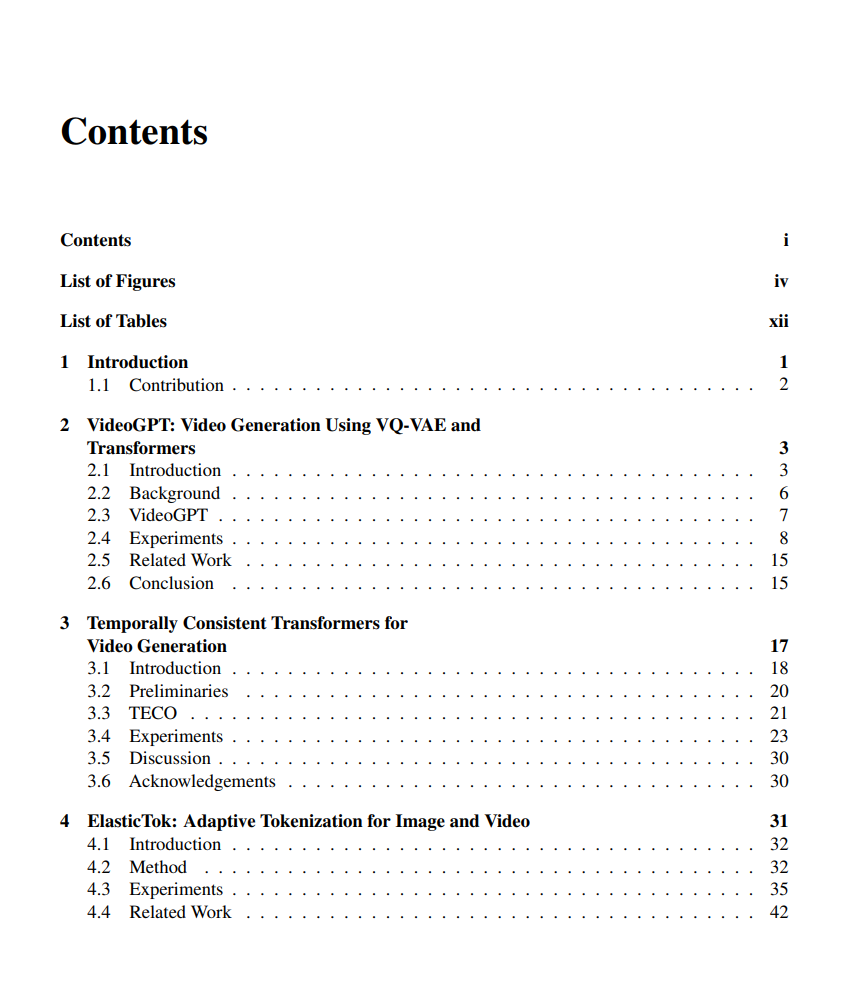

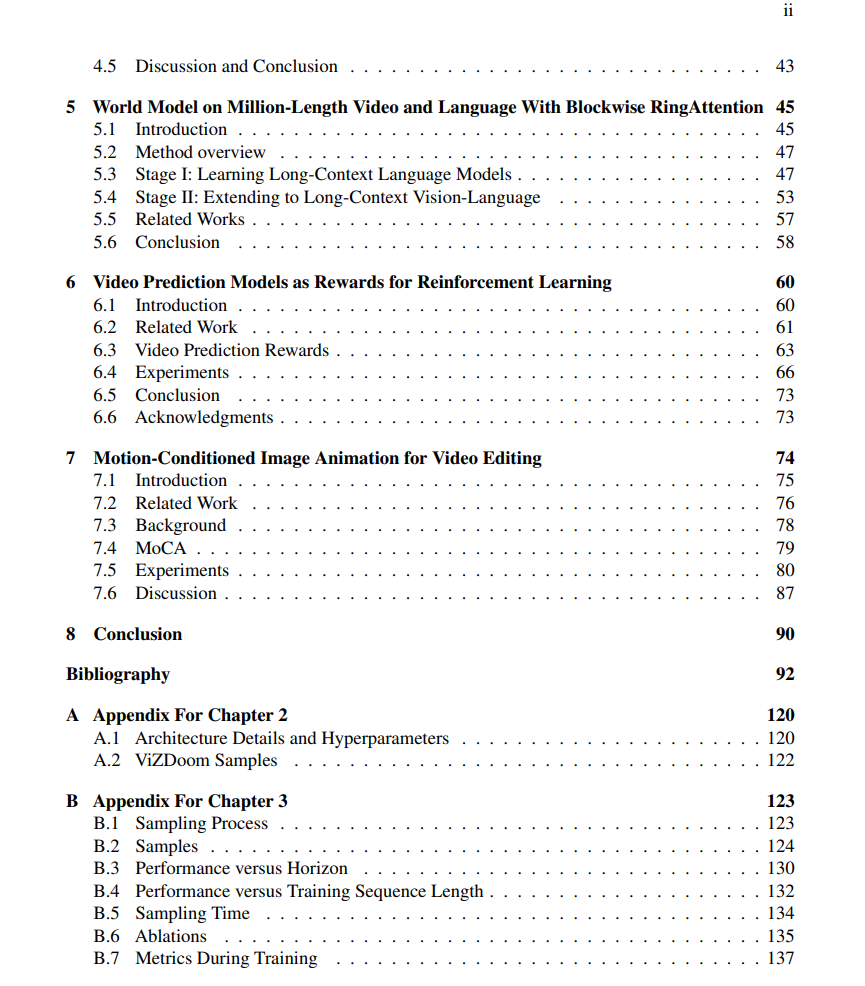

在本论文中,我提出了在视频生成方法的可扩展性设计方面的核心贡献,以及视频生成模型在下游任务中的应用。 第二章专注于开发一种简单而可扩展的视频生成方法。第三章研究了长视频生成的问题,以及在建模更长视频中的全局依赖性时的架构设计选择。第四章旨在推动先前视频自编码器架构的核心基础,并通过自适应标记化技术使模型能够扩展到更长的序列,包括图像和视频数据。 第五章重点研究了如何扩展到更长的视频和上下文长度,并在算法和训练方面做出改进,以稳定和高效地联合训练语言和视频的组合。 论文的最后一部分探讨了如何在下游应用中利用预训练的视频生成模型。第六章使用视频生成作为奖励模型来学习强化学习代理,第七章则对现有的视频生成模型进行微调,以执行复杂的视频编辑任务。