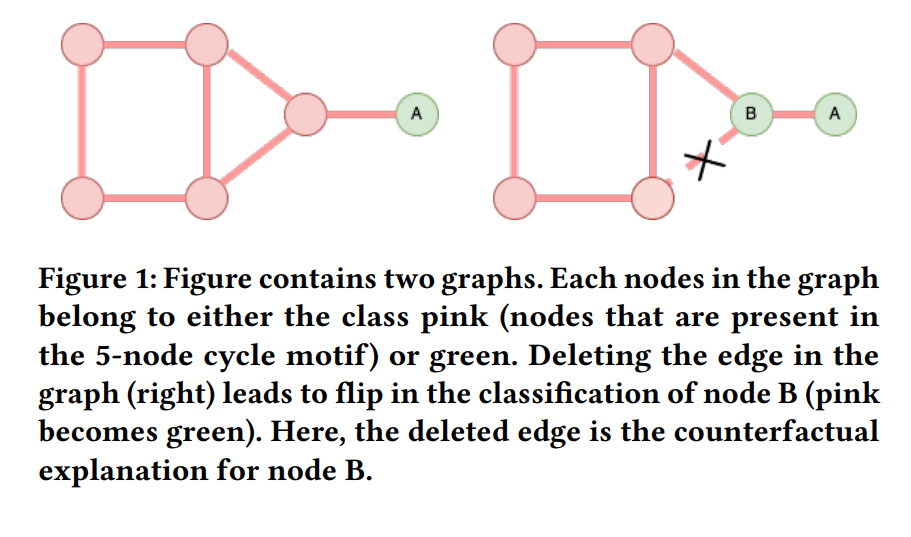

图神经网络(GNNs)已成为复杂网络中节点分类任务的强大工具。然而,它们的决策过程对用户来说仍是一个黑盒,这使得理解它们预测背后的推理变得具有挑战性。反事实解释(CFE)在增强机器学习模型的可解释性方面显示出了前景。以前计算GNNs的CFE的方法通常是基于学习的方法,需要训练额外的图。在这篇论文中,我们提出了一种基于半值的非学习方法来生成节点分类任务的CFE,消除了任何额外训练的需求。我们的结果揭示了计算班扎夫值(Banzhaf values)在识别反事实解释方面需要的样本复杂度比计算沙普利值(Shapley values)等其他流行方法低。我们的实证证据表明,与沙普利值相比,计算班扎夫值可以实现高达四倍的速度提升。我们还设计了一种计算班扎夫值的阈值方法,并展示了其在嘈杂环境中的鲁棒性的理论和实证结果,使其优于沙普利值。此外,阈值化的班扎夫值被证明在不牺牲解释的质量(即,忠实度)的情况下,提高了三个流行图数据集的效率。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

10+阅读 · 2022年2月10日

Arxiv

12+阅读 · 2021年10月4日