基于Transformer的基础模型已成为时间序列分析领域的主流范式,在预测、异常检测、分类、趋势分析等多种时间序列分析任务中展现出前所未有的能力。本文综述了当前最新的预训练基础模型,提出了一种新颖的分类方法,从多个维度对相关模型进行系统性梳理。具体而言,我们按照架构设计对模型进行分类,区分了采用基于patch的表示方法的模型与直接处理原始序列的模型。该分类体系还包括模型是否提供概率性或确定性预测,以及模型是专为处理单变量时间序列设计,还是可直接处理多变量时间序列。 此外,分类框架还涵盖了模型的规模与复杂度,突出轻量级架构与大规模基础模型之间的差异。本综述的一大特色是引入了以训练阶段所使用的目标函数类型为依据的分类方式。通过综合上述多个视角,本文旨在为研究人员与业界从业者提供参考资料,洞察当前研究趋势,并指明基于Transformer的时间序列建模未来的发展方向。

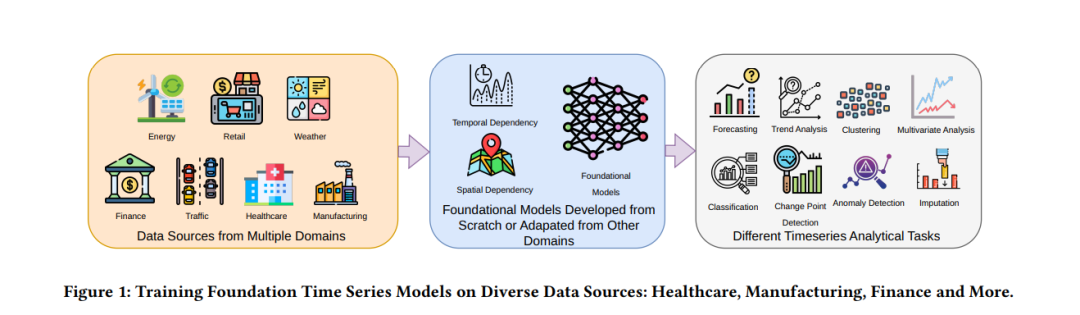

时间序列数据是现代数据分析中的关键组成部分,广泛应用于金融、医疗健康、经济学、气候科学、库存管理、能源管理、交通管理、物联网(IoT)、工业流程、供应链优化、电信、零售分析、社交媒体监控、传感器网络、天气预测,甚至医疗诊断等多个领域。时间序列分析的重要性在于其能够捕捉时间依赖性和趋势性,对于缺失值填补、分类、预测及异常检测等任务至关重要。例如,在金融领域,时间序列数据可用于预测股价或识别市场异常;而在医疗健康领域,时间序列分析能够实现患者生命体征的实时监控,及早发现潜在疾病或预测疾病暴发。在气象学中,其对天气模式和气候变化的预测尤为关键;而在经济学中,时间序列分析有助于预测如通货膨胀和国内生产总值(GDP)增长等关键指标。在能源领域,时间序列数据对于优化需求预测和资源调配具有重要价值;在库存管理中,它有助于预测库存水平并提升供应链效率。在电信领域,时间序列数据用于网络流量分析和预测性维护;在零售行业中,它支持需求预测与顾客行为分析。在制造业中,时间序列分析能够优化生产调度并监控设备健康;而在交通运输中,则有助于预测交通模式并优化车队管理。图1展示了在无需微调或微调基础模型的情况下,在不同领域中应用时间序列任务(如预测、聚类、插补等)的实例。 传统的时间序列分析方法主要依赖统计学方法,如移动平均(MA)、指数平滑等,这些方法通过对数据平滑处理来识别潜在趋势。诸如自回归移动平均整合模型(ARIMA)等方法,结合了自回归(AR)与移动平均(MA)成分,广泛用于建模时间相关结构。基于局部加权回归的季节性和趋势分解(STL)方法也常用于将时间序列分解为趋势、季节性与残差成分。在图2中,我们展示了苹果公司(AAPL)在5分钟时间框架下的日内价格波动,使用了15周期的简单移动平均(SMA)与指数移动平均(EMA)两种常见技术分析指标对价格进行平滑处理并识别潜在趋势。 尽管这些传统方法在多数场景下有效,但在面对更复杂的非线性模式或高维数据时往往力不从心。相比之下,支持向量机(SVM)与梯度提升机(GBM)等机器学习算法在捕捉更复杂的时间依赖性方面表现更佳,尤其是数据趋势较为简单或线性时。然而,这些算法在处理不规则采样数据或依赖人工特征工程以提取时间特征时面临较大挑战。例如,ARIMA模型难以捕捉长期依赖关系或非线性关系;传统机器学习算法通常依赖繁琐的数据预处理与特征选择才能在时间序列任务中取得良好表现。此外,这些传统模型常常依赖数据平稳性或均匀采样等假设,这在实际应用中往往无法满足。例如,在传感器数据或具有不规则交易时间的股市数据中,传统方法的表现往往不佳,从而推动了更先进技术的发展需求,以更有效应对这些复杂性。

1.1 神经网络在时间序列分析中的应用

为克服上述局限,神经网络,尤其是循环神经网络(RNN)与卷积神经网络(CNN),近年来成为时间序列建模的强大替代方案。神经网络具备从原始输入中自动学习分层表示的能力,从而免去了大量人工特征工程。这种“端到端”的学习方式使模型能够自动捕捉数据中的潜在结构,尤其适用于存在复杂非线性时间依赖关系的预测、异常检测和分类任务。RNN由Rumelhart等人在1980年代提出,专为处理序列数据而设计,能够通过维护隐藏状态捕捉历史输入信息。在每个时间步,RNN基于当前输入与前一状态更新隐藏状态,从而建模时间依赖关系。这使得RNN非常适合于诸如股价预测、天气预测或传感器数据分析等场景。 然而,尽管RNN理论上具备建模序列依赖的优势,但其在实际训练过程中存在“梯度消失”问题。在采用时间反向传播(BPTT)训练RNN时,梯度在长序列中反向传播过程中可能变得极小,从而难以学习长期依赖关系。在面临需要捕捉远距离依赖或长序列预测的任务中,RNN的表现通常不尽如人意。为缓解该问题,Hochreiter与Schmidhuber于1997年提出了长短期记忆网络(LSTM),通过引入记忆单元和门控机制(输入门、遗忘门和输出门)来控制信息的保留与丢弃,从而有效捕捉长期依赖。Gated Recurrent Unit(GRU)由Cho等人在2014年提出,是LSTM的简化版本,采用重置门和更新门,在保留性能的同时提高计算效率。 尽管LSTM与GRU在许多时间序列任务中(如股价预测、能源需求预测、传感器异常检测)已表现优于传统RNN,但它们在处理大规模数据时仍面临诸多挑战: 1. 序列性与并行化限制:RNN需逐步处理时间序列,导致训练与推理难以并行化,计算成本高、耗时长; 1. 长期依赖建模难度:即使是LSTM与GRU,面对极长或高度复杂的序列时仍可能出现梯度消失/爆炸; 1. 资源开销:在大规模数据集上训练RNN类模型需消耗大量内存与计算资源,难以满足实时性或资源受限环境的需求; 1. 过拟合与泛化能力弱:参数较多的RNN模型在数据量不足时易发生过拟合,泛化性能较差。

1.2 Transformer范式

Transformer架构于2017年首次提出,标志着序列建模范式的重大转变。Transformer最初用于自然语言处理(NLP)任务,其核心创新是自注意力机制,可在无递归结构的前提下建模序列中元素间的依赖关系。与RNN不同,Transformer能够并行处理整个序列,从而显著提升训练效率。其自注意力机制使模型能动态关注序列中任意位置的相关信息,对于建模长距离依赖关系尤为有效。 Transformer架构能够在较低计算成本下建模复杂时间依赖,克服了RNN在处理不规则采样间隔或非线性跨尺度模式时的局限性。同时,由于不依赖递归结构,Transformer有效规避了梯度消失问题,自注意力机制实现了序列中任意位置之间的信息直接传递,使得模型能捕捉更复杂的时间关系。 因此,基于Transformer的模型迅速在时间序列分析中获得关注,并在多项任务中(如预测、异常检测)超越了传统方法与RNN架构。近年来,许多专为时间序列设计的Transformer变体相继出现,如 Time Series Transformer (TST)、Informer 等,它们在长序列建模与不规则数据处理方面表现出色。

1.3 基于Transformer的时间序列基础模型

传统时间序列建模方法通常对每条序列独立建模,这在面对大规模或时间模式多样的序列时难以取得良好效果,因为这种方法无法捕捉跨序列的共性与共享模式。相比之下,Transformer模型可在整体数据上统一训练,从而提取跨序列的通用特征,构建更具鲁棒性与泛化能力的基础模型。 随着对这一优势的认识加深,学术界与工业界对基于Transformer架构的时间序列建模兴趣日益增长,目标在于开发更准确、高效、可扩展的解决方案,适用于预测、异常检测、分类等任务。Transformer在NLP与计算机视觉中的成功进一步证明了其跨领域的广泛适用性,为时间序列分析提供了新的建模范式。 基于Transformer的模型的快速发展及其在多个领域的持续成功表明,这不仅仅是一种短暂的趋势,而是对传统序列建模方式的根本性变革。未来,Transformer架构有望在时间序列分析中发挥关键作用,推动预测精度、异常检测能力与对时序数据的理解水平不断提升,助力多个领域的数据驱动决策与智能系统发展