扩散生成模型已在图像和视频生成等视觉领域取得了显著成功。近年来,它们也逐渐在机器人领域中崭露头角,尤其是在机器人操作任务中展现出广阔前景。扩散模型基于概率框架,具备建模多模态分布的能力,并且在处理高维输入输出空间时表现出强大的鲁棒性。

本文综述了扩散模型在机器人操作中的最新研究进展,涵盖了抓取学习、轨迹规划和数据增强等关键应用。用于场景与图像增强的扩散模型位于机器人与计算机视觉交叉领域的核心位置,尤其在提升基于视觉的任务的泛化能力与缓解数据稀缺性方面具有重要意义。

此外,本文介绍了扩散模型的两种主要框架及其与模仿学习和强化学习的融合方式,探讨了主流架构与评估基准,并指出了当前最先进扩散方法的挑战与优势。

关键词:扩散模型 · 机器人操作学习 · 生成模型 · 模仿学习 · 抓取学习

https://arxiv.org/pdf/2504.08438

1 引言

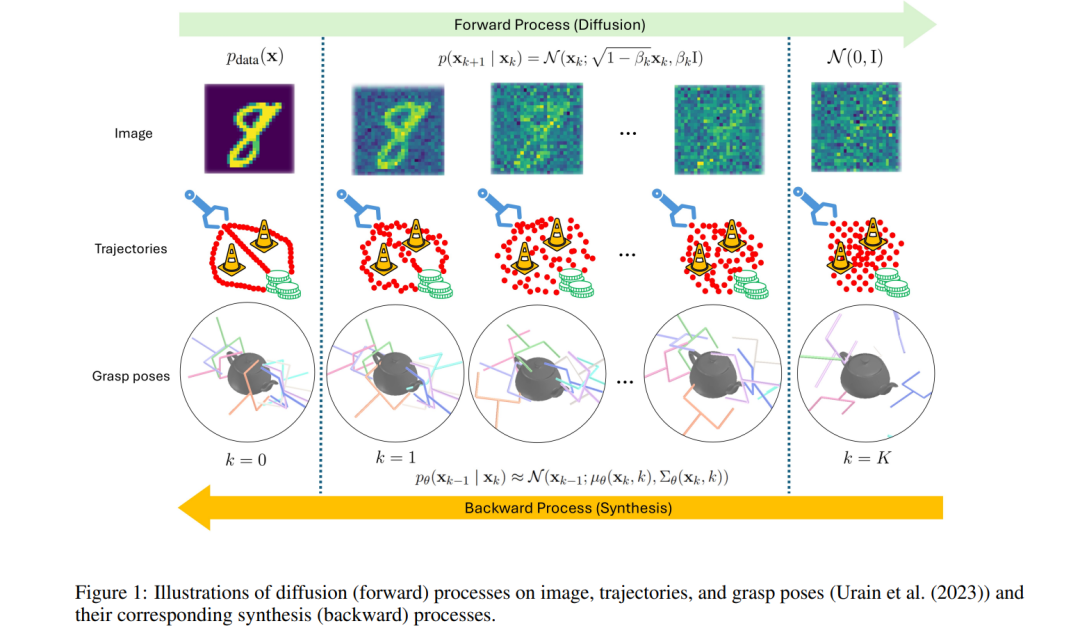

扩散模型(Diffusion Models, DMs)作为深度生成模型,在多个领域中展现出极大的发展潜力,包括计算机视觉(Ho 等, 2020;Song 等, 2021a;Nichol 和 Dhariwal, 2021;Ramesh 等, 2022;Rombach 等, 2022a)、自然语言处理(Li 等, 2022;Zhang 等, 2023;Yu 等, 2022)以及机器人学(Chi 等, 2023;Urain 等, 2023)。DMs 天生具备建模任意分布的能力,特别是在处理来自高维和视觉数据的复杂多模态分布时,其性能和稳定性已超越传统的高斯混合模型(GMMs)和基于能量的模型(EBMs),如隐式行为克隆(Implicit Behavior Cloning, IBC)(Chi 等, 2023)。虽然 GMM 和 IBC 都能建模多模态分布,且 IBC 甚至能学习复杂的不连续分布(Florence 等, 2022),但实验结果(Chi 等, 2023)显示,这些方法在实际中往往偏向特定模式。 总体来看,DMs 的性能也已超过过去被认为是生成模型主流方法的生成对抗网络(GANs)(Krichen, 2023)。相比之下,GANs 通常需要对抗训练,容易出现模式崩溃以及训练不稳定等问题(Krichen, 2023),且对超参数较为敏感(Lucic 等, 2018)。 自 2022 年以来,扩散概率模型在机器人操作领域中的应用显著增长,涵盖了轨迹规划(如 Chi 等, 2023)和抓取预测(如 Urain 等, 2023)等多项任务。DMs 能够有效建模多模态分布,这在诸如轨迹规划与抓取等机器人操作任务中具有巨大优势,因为这些任务往往存在多个同样合理的冗余解。捕捉这些多种可行解不仅提升了模型的泛化能力,也增强了机器人在不同物体摆放或推理约束下的适应性。 尽管在轨迹规划任务中,DMs 主要结合模仿学习进行应用,但也已有方法将其与强化学习(Reinforcement Learning, RL)相结合,例如 Geng 等(2023)。当前的研究工作正集中于根据具体任务需求调整扩散过程中的各个组成部分。 一些研究架构整合了不同甚至多种输入模态,例如点云(Ze 等, 2024;Ke 等, 2024),通过深度信息提升模型对复杂任务中的三维场景理解能力。另一个输入模态的例子是自然语言(Ke 等, 2024;Du 等, 2023;Li 等, 2025),这也使得基础模型(如大型语言模型)能够融入机器人操作流程。在 Ze 等(2024)中,同时使用了点云与语言任务指令作为多模态输入。 还有研究将 DMs 融入分层规划(Ma 等, 2024b;Du 等, 2023)或技能学习(Liang 等, 2024;Mishra 等, 2023),以充分发挥其在建模高维数据和多模态分布方面的最前沿能力,适用于长时序与多任务的设置。许多方法(如 Kasahara 等, 2024;Chen 等, 2023b)也在基于视觉的操作任务中,利用扩散模型进行数据增强,以扩展数据集并重建场景。 值得注意的是,DMs 的一个主要挑战是其采样速度较慢。对此,已有多种方法进行改进(Song 等, 2021a;Chen 等, 2024;Zhou 等, 2024a),部分方法已实现了实时预测能力。 据我们所知,这是首篇聚焦于机器人操作领域的扩散模型综述文章。本文系统地对该领域中与 DMs 相关的多种方法进行了分类,涵盖了网络架构、学习框架、应用场景与评估方法等方面。除全面的描述外,我们还提供了直观的分类图谱。 为帮助读者理解 DMs 的基本原理,本文首先在第2节介绍其数学基础(非特指机器人应用)。第3节将讨论 DMs 在机器人操作中常见的网络架构。随后,第4节介绍 DMs 在机器人操作中的三大核心应用方向:轨迹生成(4.1节)、抓取合成(4.2节)以及视觉数据增强(4.3节)。第5节对常用基准测试与对比方法进行总结,最后第6节给出结论、指出当前局限,并展望未来的研究方向。

**

**