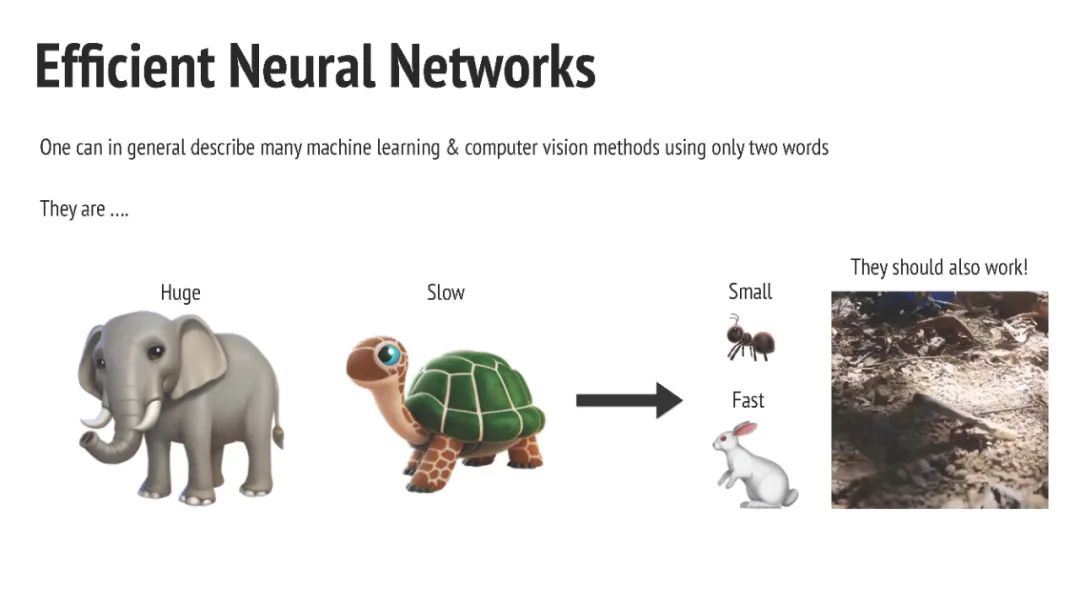

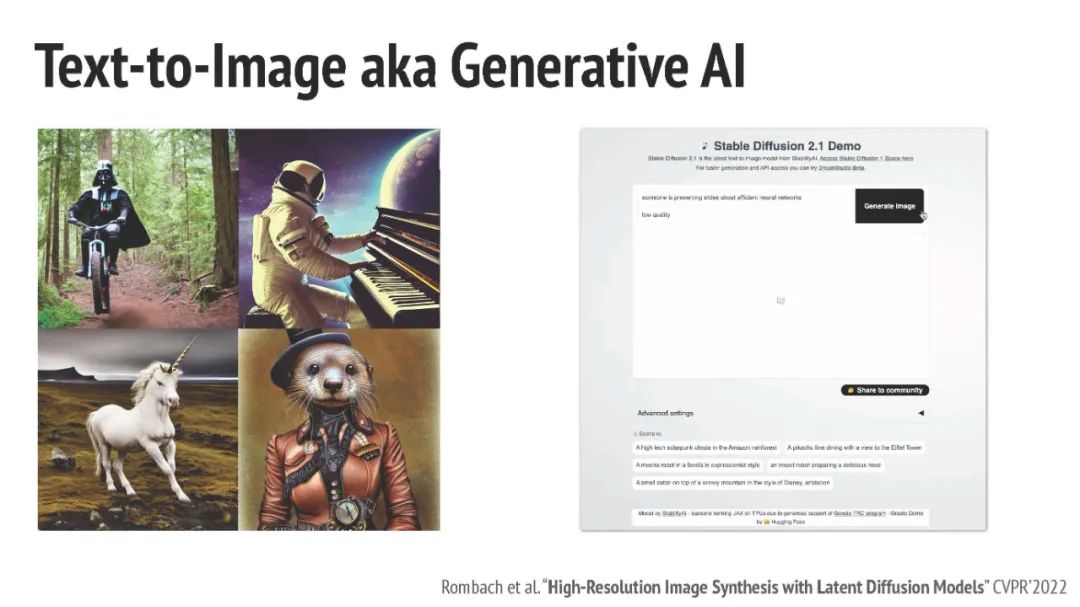

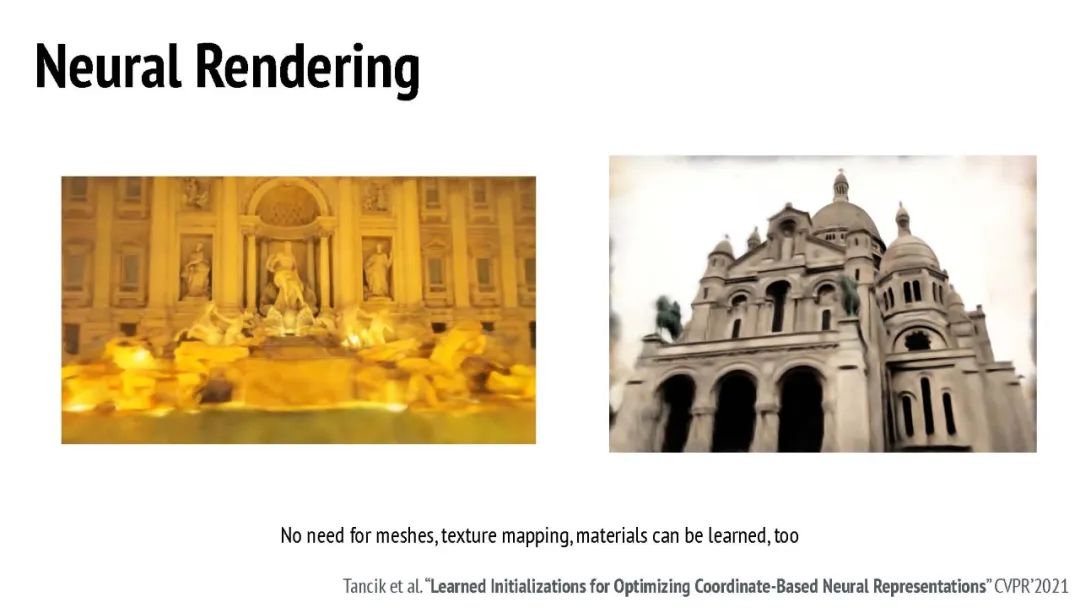

最近在计算机视觉领域的突破为用户解锁了许多以前无法使用的应用程序。诸如检测、分割、姿态和深度估计等区分性任务取得了令人难以置信的准确性。对抗网络、自编码器、扩散模型、图像到图像转换、视频合成和动画方法的生成应用展示了其输入的高保真度,使其难以被人类观察者与真实区分。神经辐射场 (Neural Radiance Fields) 承诺为各种应用提供民主化的对象重建和渲染。

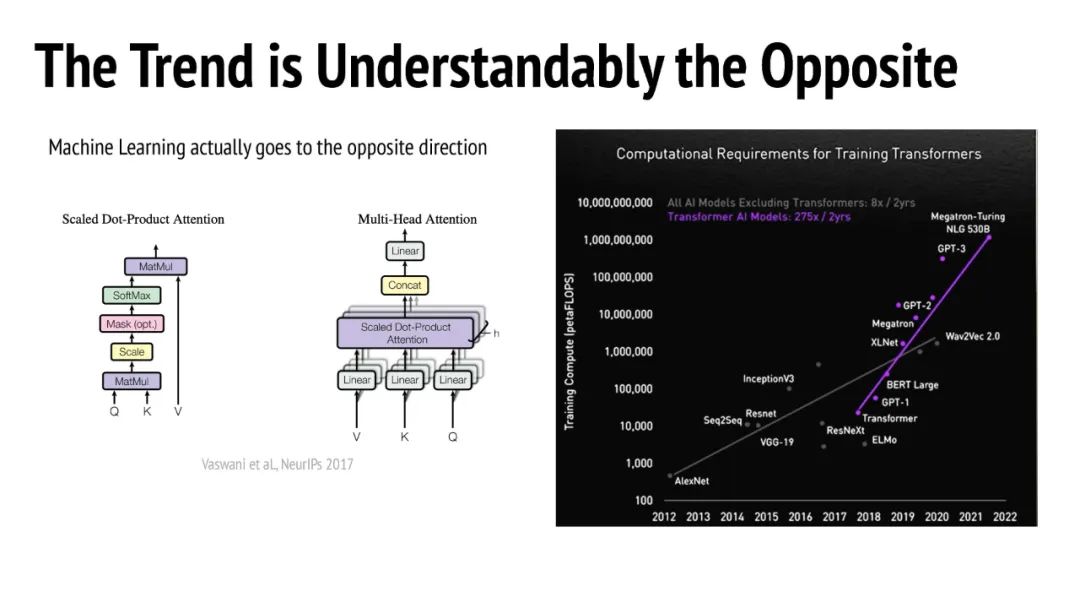

然而,这些突破以这些模型的高计算需求为代价。例如,根据Token长度,具有二次复杂性的变换模型,图像到图像转换需要大量的FLOPs,而神经渲染方法需要复杂的渲染管道。这转化为在服务器端运行这些模型的需求,提高服务成本,并且由于传输数据和接收结果所产生的延迟,用户体验不是最佳。 将这些方法带到边缘设备上是出了名的困难。现有的工作目标是压缩大型模型,但这不一定会导致设备上的加速,因为它不仅需要神经网络压缩的背景知识,还需要特定领域的背景知识。例如,要在设备上运行神经渲染,就需要在图形方面有经验;要运行生成模型,就需要知道如何在不牺牲输出质量的情况下减小大小。加速服务器端推理的神经网络不一定会提高边缘推理的效率,因为在边缘设备上部署它们需要大幅度减小模型的大小,有时达到几个数量级。

另一方面,边缘推断的好处是显而易见的:1. 服务成本大大降低。2. 通过设计提高用户隐私,因为所有处理都在设备上运行,而不需要在服务器和设备之间传输数据。3. 它便于用户交互,因为没有传输可以减少延迟。4. 减少构建许多新的基于计算机视觉的应用程序的周期时间,因为不需要昂贵的基础设施。

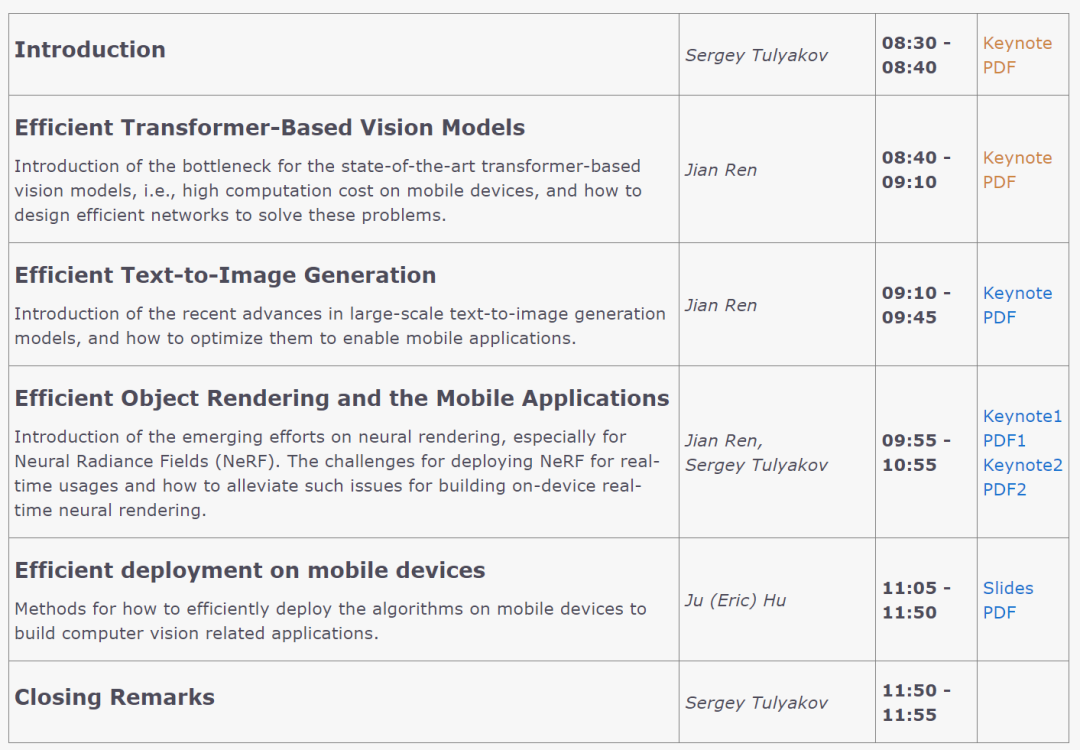

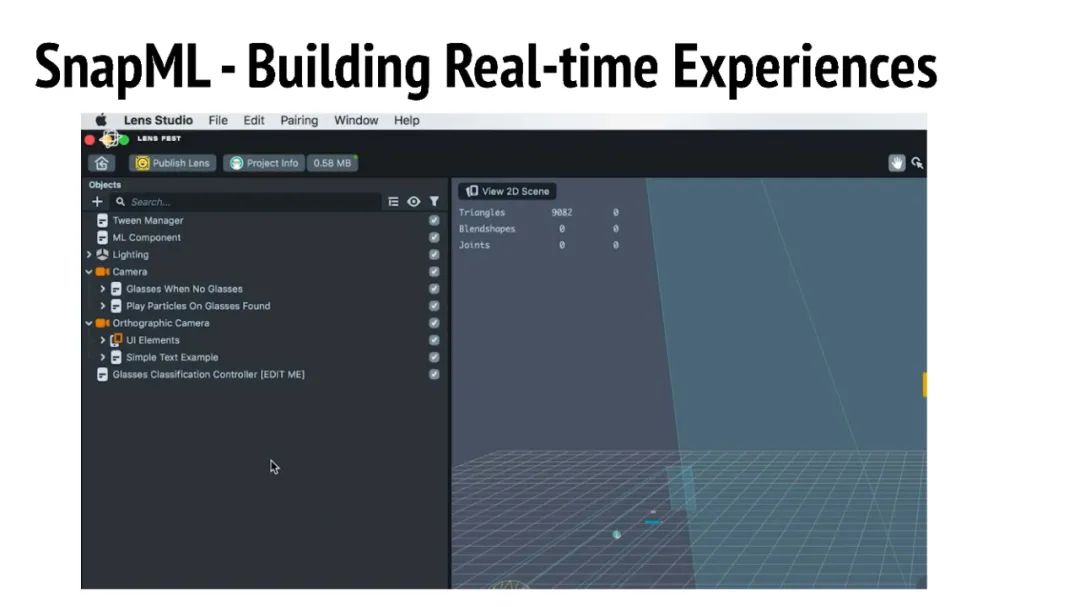

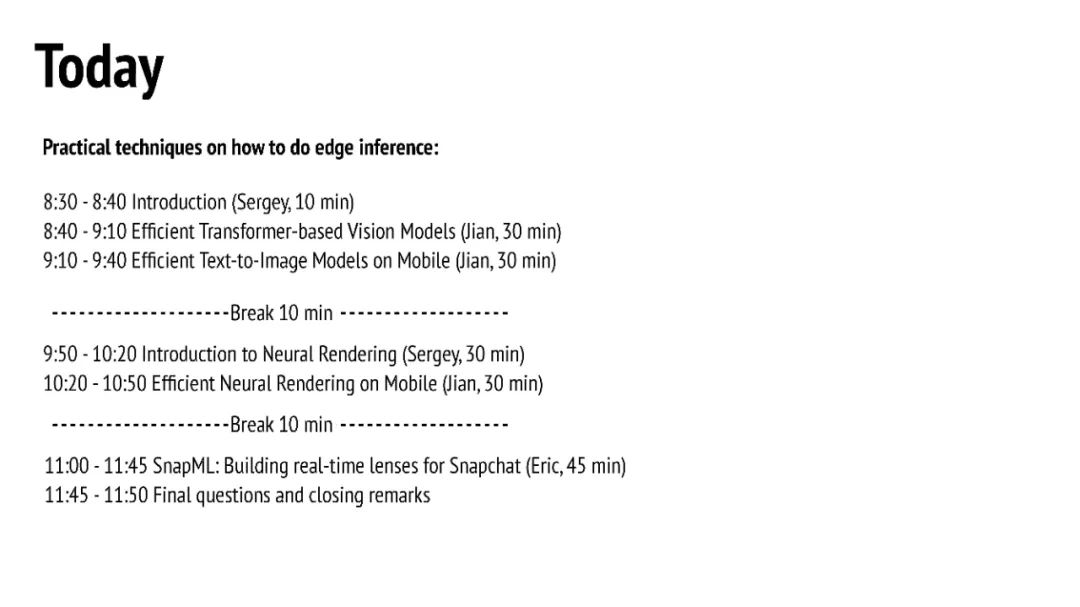

这个教程将介绍重新设计算法的有效方法,以实现高效的内容理解、图像生成和神经渲染。最重要的是,我们将展示如何将算法有效地部署在移动设备上,最终实现用户与移动设备之间的实时互动。

https://snap-research.github.io/efficient-nn-tutorial/

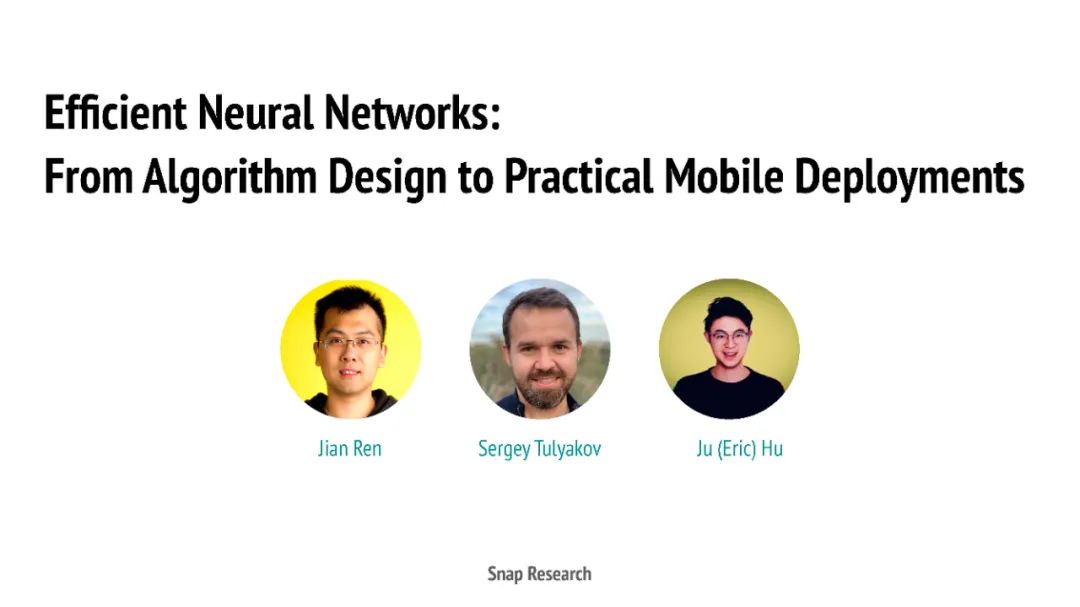

讲者:

Jian Ren是Snap Research的创意愿景团队的首席研究科学家。他的研究重点是内容理解,图像和视频的生成和操作,以及为前两个领域设计高效神经网络的方法。他的工作成果包括20多篇在顶级会议(CVPR, ICCV, ECCV, ICLR, NeurIPs, ICML)上发表的论文,以及为多个产品贡献的专利。2019年,他从美国罗格斯大学获得计算机工程博士学位;2014年,他从中国科学技术大学获得学士学位。在加入Snap Inc之前,Jian曾在Adobe,Snap和字节跳动公司实习。

Sergey Tulyakov是Snap Inc的首席研究科学家,领导创意愿景团队。他的工作专注于通过计算机视觉和机器学习创建操纵世界的方法。这包括对人类和物体的理解,逼真的操作和动画,视频合成,预测和重定向。他开创了无监督图像动画领域,并通过MonkeyNet和一阶运动模型激发了该领域的许多初创公司。他在交互式视频风格化方面的工作在SIGGRAPH Real-Time Live! 2020上获得了最佳展示奖。他发表了30多篇顶级会议论文、期刊和专利,并开发了多个创新产品,包括Snapchat宠物跟踪、OurBaby、实时神经镜头(性别互换、婴儿脸、老化镜头、脸部动画)等。在加入Snap Inc.之前,Sergey曾在卡内基梅隆大学、微软和英伟达工作。他拥有意大利特伦托大学的博士学位。

Ju (Eric) Hu是Snap Inc.的机器学习工程师。他的工作主要集中在支持和优化Snap内部的机器学习框架SnapML。SnapML旨在通过利用不同的硬件在移动设备上实现实时性能,提供快速有效的推理。在加入Snap之前,他在一家医疗成像初创公司工作,专注于皮肤病变检测和分类。他毕业于加州大学洛杉矶分校,获得数学学士学位。