ACL会议开始于1963年,在自然语言处理和计算语言学领域中是世界上影响力最大、最具活力的国际学术会议。通过ACL评奖委员会的评审,哈尔滨工业大学社会计算与信息检索研究中心(HIT-SCIR)发表于ACL 2024的论文Causal-Guided Active Learning for Debiasing Large Language Models荣获ACL 2024杰出论文奖,作者有孙洲浩博士生,杜理博士,丁效教授(通讯作者),马翊轩博士生,赵阳博士生,邱凯涛本科生,刘挺教授,秦兵教授。

图1 ACL Outstanding Paper Award 证书

论文介绍

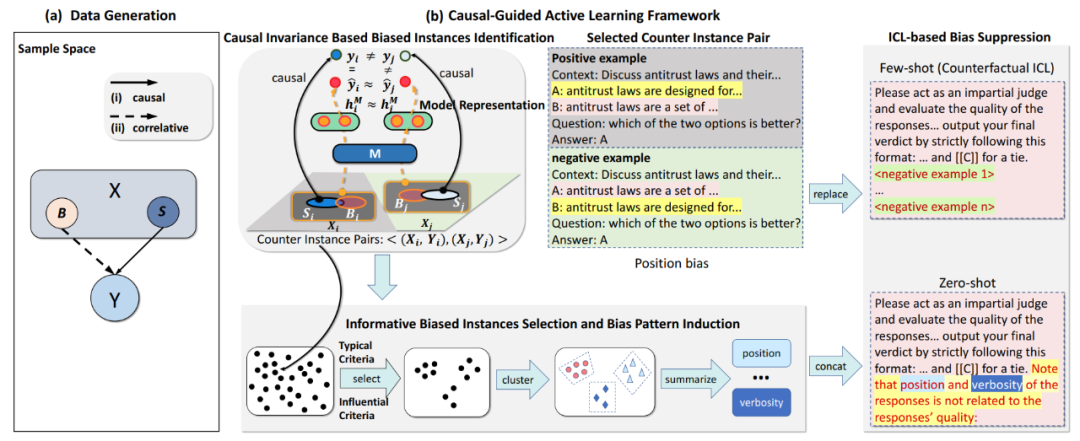

图2 因果指导的主动学习方法

方法动机前人的模型去偏方法要么依赖于人类的先验知识,要么是针对判别式模型设计,当应用于生成式LLM时会损伤LLM的通用性。因此,本文旨在设计一种不损失生成式LLM通用性且不依赖于人类先验知识的模型自动去偏方法。具体地,首先基于因果不变性理论从数据集中自动识别出具有偏见信息的有偏数据(真正决定问题答案的语义信息与答案之间具有因果关系,这种关系在所有数据上都成立;然而偏见信息与问题的答案之间只具有表面的统计意义上的相关关系,这种关系在不同数据上并不一定都成立);然后利用LLM对这些有偏数据进行归纳从而归纳出可解释的偏见模式比如位置偏见,性别偏见等;最后通过情境学习方法利用之前识别出的有偏数据和归纳出的偏见模式对LLM进行去偏。该工作一方面表明通过利用因果不变性理论,可以有效地识别出有偏数据并从有偏数据中归纳出可解释的偏见模式。另一方面表明通过利用情境学习方法结合识别出的有偏数据和归纳出的偏见模式,可以有效地对LLM进行去偏。与此同时,这篇工作也证明在大模型时代下因果依然十分重要,事理图谱作为一种描述事件间因果关系的图谱依然可以弥补大模型在因果方面的缺陷。数据和代码已开源:https://github.com/spirit-moon-fly/CAL