基于基础模型的医学图像分割增强框架:高效提示与偏好优化

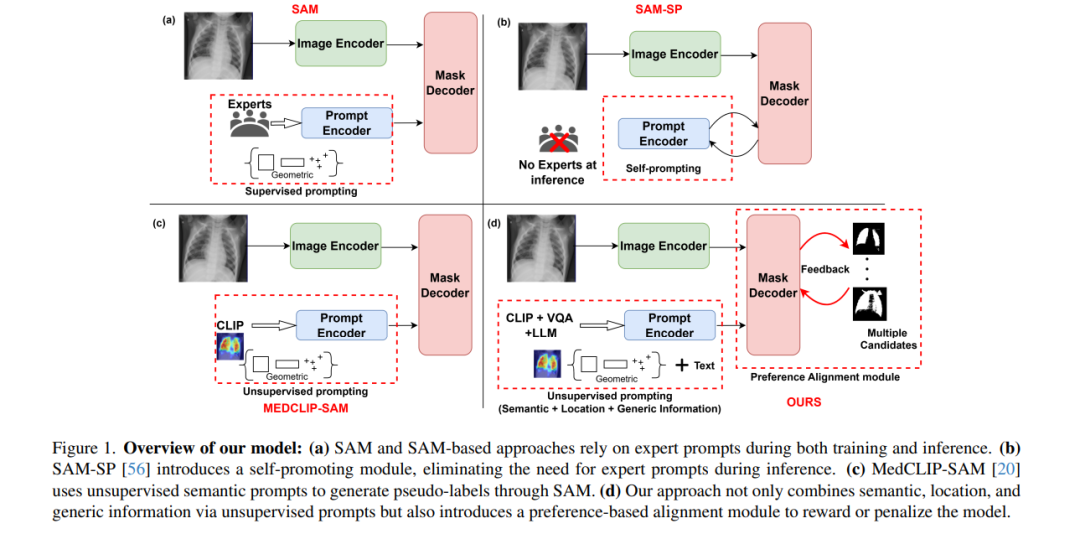

诸如Segment Anything Model(SAM)之类的基础模型在医学图像分割领域正逐渐受到关注,能够支持多种下游任务。然而,这些模型本质上是监督学习的,仍然依赖于大规模标注数据集或专家提供的提示。传统的技术(如主动学习)虽然旨在缓解这些限制,但其应用范围有限,且仍需持续的人工参与和复杂的领域知识来进行标签优化或建立奖励基准。为了应对这些挑战,我们提出了一种增强的Segment Anything Model(SAM)框架,该框架利用完全无监督方式生成的标注高效提示,同时通过对比语言-图像预训练和视觉问答捕捉关键的语义、位置和形状信息。我们采用直接偏好优化技术,设计了一种最优策略,使模型能够通过虚拟标注器模拟人类标注过程,仅需简单的评分或排名即可生成高保真度的分割结果。我们的框架在肺部分割、乳腺肿瘤分割以及器官分割等任务中,在X射线、超声和腹部CT等多种模态上均达到了最先进的性能,证明了其在低标注数据场景中的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

38+阅读 · 2023年4月19日

Arxiv

205+阅读 · 2023年4月7日