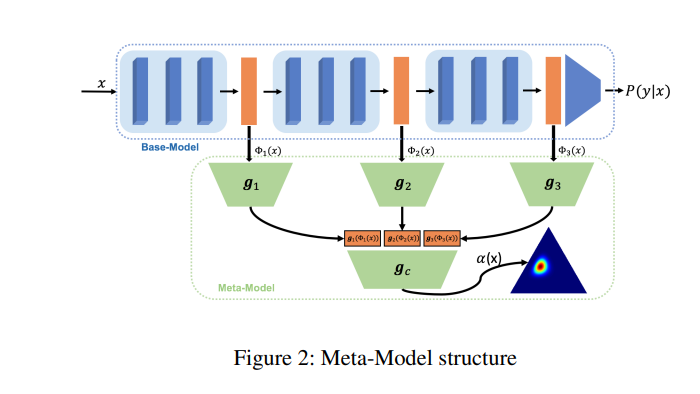

众所周知,神经网络在直接使用输出标签分布生成不确定性度量时存在过度自信的问题。现有方法主要通过重新训练整个模型,赋予其不确定性量化能力,使学习到的模型在精度和不确定性预测方面同时达到预期的性能。然而,从头开始训练模型的计算成本很高,在许多情况下可能是不可行的。本文考虑一个更实际的事后不确定性学习设置,给出一个训练良好的基础模型,并专注于训练第二阶段的不确定性量化任务。本文提出一种新的贝叶斯元模型,以增强预训练模型的不确定性量化能力,有效且计算效率高。所提出的方法不需要额外的训练数据,足够灵活,可以量化不同的不确定性,并容易适应不同的应用设置,包括域外数据检测、错误分类检测和可信迁移学习。在多个代表性的图像分类基准上,证明了所提出的元模型方法的灵活性和在这些应用上的优越经验性能。

https://www.zhuanzhi.ai/paper/ce666840fd9361b6f02ab0f425f731c6

成为VIP会员查看完整内容

相关内容

Arxiv

17+阅读 · 2021年6月18日