脉冲神经网络(SNNs)已成为研究热点,因其生物可解释性和能效优势,使其成为人工神经网络(ANNs)的潜在替代方案。然而,SNNs 与 ANNs 之间的性能差距仍然是阻碍 SNNs 广泛应用的一大挑战。

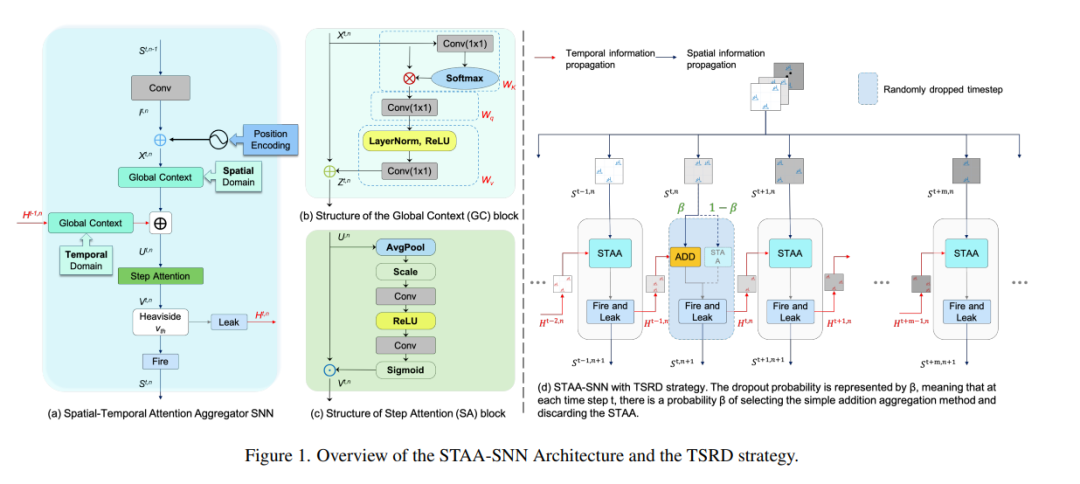

在本文中,我们提出了一种时空注意力聚合 SNN(STAA-SNN, Spatial-Temporal Attention Aggregator SNN)框架,该框架能够动态关注并捕捉空间与时间依赖性。首先,我们引入了一种专为 SNN 设计的脉冲驱动自注意力(spike-driven self-attention)机制,以增强信息表达能力。此外,我们首次在 SNN 中引入位置编码(position encoding),用于整合潜在的时间关系信息至输入特征中。在时空信息聚合方面,我们采用时间步注意力(step attention),以选择性增强不同时间步的关键特征。最后,我们引入时间步随机丢弃(time-step random dropout)策略,以避免模型陷入局部最优解。 得益于这些设计,STAA-SNN 能够有效捕捉空间和时间依赖关系,从而分析复杂模式并进行准确预测。实验结果表明,该框架在多个数据集上表现优异,并展现出强大的泛化能力。值得注意的是,STAA-SNN 在神经形态数据集 CIFAR10-DVS 上取得了最先进(state-of-the-art)的性能,并在静态数据集 CIFAR-10、CIFAR-100 和 ImageNet 上分别达到了 97.14%、82.05% 和 70.40% 的准确率。此外,我们的模型在减少时间步数的情况下,仍然能够提升 0.33% 至 2.80% 的性能。相关代码已在 GitHub 上开源。 https://arxiv.org/pdf/2503.02689