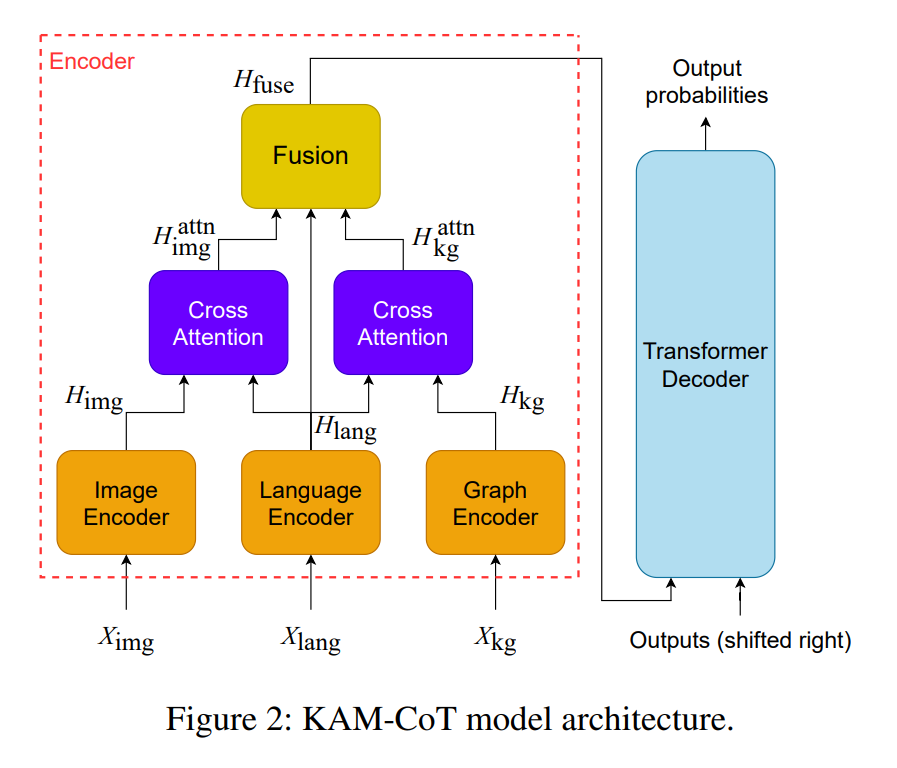

大型语言模型(LLMs)通过利用思维链(CoT)实现了在自然语言处理任务中令人印象深刻的性能,这使得逐步思考成为可能。最近,将LLMs扩展为具有多模态能力成为了研究兴趣,但这会带来计算成本并需要大量的硬件资源。为了解决这些挑战,我们提出了KAM-CoT,这是一个集成了CoT推理、知识图谱(KGs)和多种模态的框架,用于全面理解多模态任务。KAM-CoT采用了一个两阶段的训练过程,通过KG的基础知识来生成有效的解释和答案。通过在推理过程中整合来自KGs的外部知识,模型获得了更深层次的上下文理解,减少了幻觉并提高了答案的质量。这种知识增强的CoT推理使模型能够处理需要外部上下文的问题,提供更具信息性的答案。实验结果表明,KAM-CoT优于最先进的方法。在ScienceQA数据集上,我们实现了平均准确率达到93.87%,超过了GPT-3.5(75.17%)18%和GPT-4(83.99%)10%。值得注意的是,KAM-CoT仅使用了280M可训练参数,显示了其成本效益和有效性。

https://www.zhuanzhi.ai/paper/4bfdc7f194b5a1e2989458170e15ba29

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日