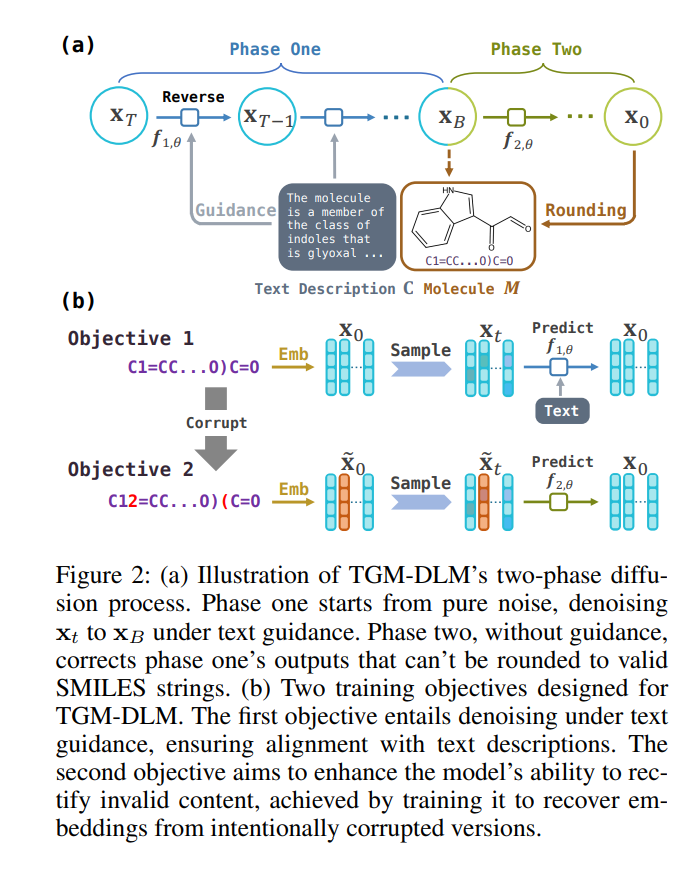

基于文本的分子生成是一项任务,在这项任务中,分子被生成以匹配特定的文本描述。最近,大多数现有的基于SMILES的分子生成方法依赖于自回归架构。在这项工作中,我们提出了一种新颖的方法——文本引导的分子生成与扩散语言模型(TGM-DLM),该方法利用扩散模型来解决自回归方法的局限性。TGM-DLM在SMILES字符串中集体和迭代地更新标记嵌入,使用两阶段扩散生成过程。第一阶段从随机噪声中优化嵌入,由文本描述引导,而第二阶段则纠正无效的SMILES字符串以形成有效的分子表示。我们证明了TGM-DLM在不需要额外数据资源的情况下,就超过了自回归模型MolT5-Base的性能。我们的发现强调了TGM-DLM在生成具有特定属性的连贯和精确分子方面的卓越有效性,为药物发现和相关科学领域开辟了新途径。代码将在以下地址发布:https://github.com/Deno-V/tgm-dlm。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日