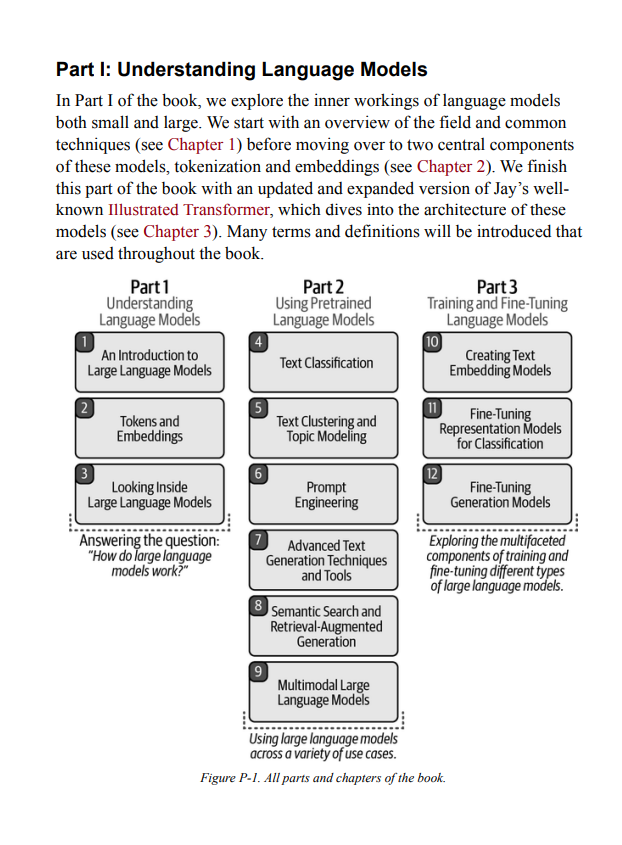

近年来,人工智能在语言能力方面取得了惊人的进步。在深度学习的快速发展推动下,语言 AI 系统的文本生成和理解能力达到了前所未有的高度。这一趋势正推动着新功能、新产品甚至整个行业的发展。通过本书直观的教育性内容,读者将学习如何使用这些能力的实用工具和概念。 您将了解如何使用预训练的大型语言模型处理如文案撰写和摘要生成等应用场景;创建超越关键词匹配的语义搜索系统;并利用现有的库和预训练模型进行文本分类、搜索和聚类。 本书还帮助您:

- 了解擅长文本生成和表示的 Transformer 语言模型架构

- 构建高级 LLM 管道,对文本文档进行聚类并探索它们涵盖的主题

- 构建超越关键词搜索的语义搜索引擎,使用如密集检索和重排序器等方法

- 探索生成模型的使用,从提示工程到检索增强生成的全过程

- 深入理解如何训练大型语言模型 (LLM) 并通过生成模型微调、对比微调和上下文学习为特定应用优化它们

评论“Jay 和 Maarten 在他们的新书中继续提供了精美的图解和对复杂主题的深刻见解。这本书结合了可运行的代码、时间线和关键论文的参考文献,对于任何想了解大型语言模型构建主要技术的人来说,都是一项宝贵的资源。” ——Andrew Ng, DeepLearning AI 创始人 “我想不出还有哪本书比这本更值得阅读。在每一页上,我都学到了一些在语言模型时代取得成功的关键内容。” ——Josh Starmer, StatQuest “这是一本关于语言模型及其在行业中的实际应用的出色指南。书中对生成、表征和检索应用的高度可视化覆盖,使读者能够快速理解、使用并改进 LLM。强烈推荐!” ——Nils Reimers, Cohere 机器学习总监 | sentence-transformers 创作者 “如果您想快速掌握 LLM 相关的一切,不用再找了!在这本精彩的书中,Jay 和 Maarten 将带您从零基础到掌握大型语言模型的历史和最新进展。书中有直观的解释、真实的案例、清晰的图解和全面的代码实验室,这本书揭开了 Transformer 模型、分词器、语义搜索、RAG 以及许多其他前沿技术的复杂面纱。任何对最新 AI 技术感兴趣的人都必须读这本书!” ——Luis Serrano, PhD, Serrano Academy 创始人兼首席执行官 “这本书是任何对生成式 AI 快速演变领域感兴趣的人必读之作。它聚焦于文本和视觉嵌入,是算法进化、理论严谨性和实用指导的完美结合。无论您是学生、研究人员还是行业专家,这本书都将为您提供提升生成式 AI 知识所需的应用场景和解决方案。非常出色!” ——Chris Fregly, AWS 生成式 AI 解决方案首席架构师 关于作者

Jay Alammar 是 Cohere 的总监和工程研究员(Cohere 是提供大型语言模型 API 的先驱公司)。在这个角色中,他为企业和开发者社区提供使用语言模型的实践指导和教育。通过他流行的 AI/ML 博客,Jay 帮助数百万研究人员和工程师直观地理解从基础(出现在 NumPy 和 pandas 等软件包的文档中)到前沿(如 Transformers、BERT、GPT-3、Stable Diffusion)的机器学习工具和概念。Jay 还共同创建了 Deeplearning.ai 和 Udacity 上的流行机器学习和自然语言处理课程。 Maarten Grootendorst 是荷兰癌症研究中心 (IKNL) 的高级临床数据科学家。他拥有组织心理学、临床心理学和数据科学的硕士学位,利用这些知识向广泛的受众传达复杂的机器学习概念。通过他流行的博客,Maarten 向数百万读者解释了人工智能的基本原理,常常从心理学的角度进行阐述。他是多个依赖大型语言模型的开源包的作者和维护者,如 BERTopic、PolyFuzz 和 KeyBERT。这些包被全球的数据专业人士和组织下载和使用数百万次。