人工智能(AI)系统因其海量数据处理能力日益成为决策工具。尽管效率提升与决策成本降低使AI系统成为增强人类决策能力的有力工具,但其内在偏见与不可解释性可能对决策主体造成伤害的竞争持续存在。可竞争性(即允许人类在AI全生命周期进行干预的特性)被视为抵消算法危害的关键机制。通过赋能决策主体影响算法输出,可竞争AI系统旨在维护决策主体的自主权与人格尊严。尽管人机交互(HCI)领域高度关注可竞争性,但关于其如何增强决策主体在算法决策中的权能仍缺乏实证研究。

本论文旨在实证探究决策主体对可竞争AI系统的需求及其公平感知。聚焦决策主体视角,研究结果为机构构建算法决策流程提出系列建议,倡导在系统设计初期即考量受算法决策影响者的权益。研究采用混合方法,选取公共部门(非法假日租赁识别场景)与私营部门(贷款审批场景)两类高风险决策情境展开分析,依托欧盟"解码"玛丽·斯克沃多夫斯卡-居里创新培训网络(ITN)框架实施。

第二章梳理可信AI原则体系,定位可竞争性在可信AI话语中的坐标。通过构建框架整合主流可信AI原则,并将这些原则操作化为具体标准与表现形式。研究主张在AI设计与评估过程中构建多方利益相关者协商机制,相关发现为后续聚焦可竞争性研究提供理论支撑。

第三章聚焦可竞争性本质,探究决策主体实现有效竞争所需的信息与程序保障。研究突破"一对一申诉"的传统竞争框架,基于访谈定性分析揭示竞争背后的协作机制。决策主体的竞争能力并非孤立个体行为,而是通过与决策参与者(如基层行政人员、第三方机构)的互动形成,挑战了将自主权等同于个体自决的传统认知。

第四章将可竞争性限缩至欧盟《通用数据保护条例》(GDPR)第22条第3款界定的"对自动化决策提出异议的权利",从解释说明、人为干预与申诉机制三要素切入,通过众包定量研究检验其对决策主体程序公平与信息公平感知的影响。研究发现解释说明与申诉机制显著提升公平感知,但需重构传统申诉机制以适应AI决策特性。人为干预对公平感知的作用未获实证支持,需进一步探究。

第五章延续第四章发现,结合GDPR第22条第3款的人为干预要求,通过混合方法研究揭示决策者背景、模型类型与数据来源三要素对人为干预公平感知的影响。研究验证"能力-善意-诚信"模型在评估含多级人为干预的决策配置中的有效性,证实人为干预对公平感知的积极作用,但强调其内涵应超越"人类决策者终审"的狭义解读。

第六章总结全文,讨论研究对AI系统开发机构、政策制定者及HCI领域的启示,提出具体建议清单。同时反思研究方法的局限,指出人为干预机制设计、跨文化差异考察等未来研究方向,为构建更具包容性的可竞争AI系统提供理论与实践指引。

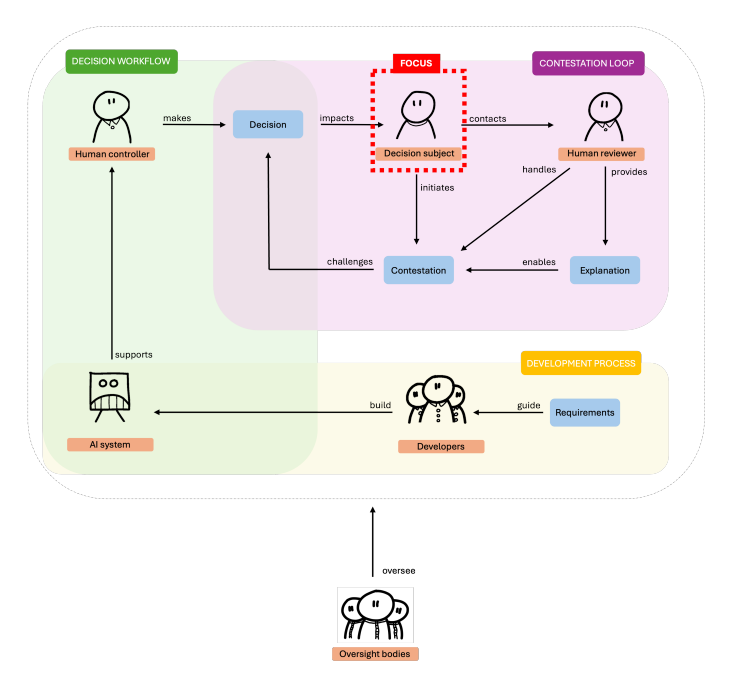

图1.2:可竞争AI系统参与者与流程概览。可争议AI系统具有开放性,能在全生命周期(涵盖开发流程、决策工作流与争议闭环)响应人为干预。本论文聚焦于解析决策主体对可争议性的需求特征与认知模式。