导语

目前的人工智能系统虽然强大,却常常缺乏人类和动物的常识和灵活推理能力。人工智能研究的最终目标,是让机器能够像人类一样思考、学习并解决各种任务,实现通用具身智能。本文作者沈马成博士是集智俱乐部「AGI读书会」发起人之一,目前致力于通用具身智能的研究,他认为,实现通用具身智能的关键问题在于,如何使机器学习系统从自然模态中学习到关于世界的结构化层级化抽象,即世界模型(world model)。本文介绍了基于目前深度学习技术的具身智能研究近年来的进展、面临的挑战,并探讨了未来可能的改进方向,使得具身智能体能够在不需要人类帮助的条件下自主学习世界模型并涌现出通用学习能力。******************************

**********研究领域:通用具身智能,强化学习,世界模型,层级化抽象,涌现

沈马成 | 作者************

目录****

1. 主流的具身智能训练方法面临的挑战****

2. 近期突破:语言任务预训练带来组合/系统性泛化能力

3. 目前的具身智能系统距离通用具身智能的根本性差异

4. 任务指定问题,常识,自然抽象和世界模型

5. 在机器/统计学习框架下如何学习世界模型

6. 总结****

具身智能,通俗来说,是指研究在环境中具有实体的智能体(如现实或仿真环境下的机器人,能够直接与环境进行物理交互)如何通过与环境的交互来取得认知能力,学习并掌握新技能新知识的一个人工智能的子领域。

1. 主流的具身智能训练方法面临的挑战

在深度学习范式下,具身智能的研究主要集中在模仿学习(Imitation Learning)和强化学习 (Reinforcement Learning, RL) 两大块。模仿学习通过采集特定任务的轨迹数据集并用深度神经网络来拟合状态(state)或观测(observation,如第一视角的图像) 的时间序列到动作 (action) 的映射来实现技能的学习,一般来说数据采集成本较高。强化学习则是通过让智能体与环境直接交互,在交互的过程中优化预先定义好的与特定任务相关的奖励函数 (reward function) 来学习新技能,一般来说设计奖励函数需要反复迭代,且强化学习的样本效率 (sample-efficiency) 相比于模仿学习来说会低得多。

早期的具身智能研究发现要使得智能体学到的策略 (policy) 泛化到即便与训练数据非常相似的任务也是一件异常困难的事情,比如在“把物体从桌子中间推到右上角”这个训练集上得到的策略竟然没有办法直接用于解决“把物体从桌子中间推到右下角”这个任务,直觉上来说其背后的原因是桌子的右上角和右下角在图像层面上并不相同,而神经网络并没有数据来学习到这两者在“更加抽象的层面上是相类似的”。因此一个巨大的挑战是任务数量的组合爆炸:可以想象如果需要学习以100种方式操作100类物体使其达到100种特定状态,那么需要定义100x100x100=一百万种不同的任务,需要收集相应的数据来训练一个多任务 (multi-task) 策略,这就非常不现实。

2. 近期突破:

语言任务预训练带来组合/系统性泛化能力

这个组合爆炸的困难直到2021年左右,学术界一些早期工作中找到了潜在的解决方案。直觉上来说其原理就是认识到这些任务并非是互相独立的,而是以一种组合(compositional)的形式互为相关,并且这种组合相关的形式与其自然语言描述存在一定的“同构性”。

Lu et al 21 [1]发现在语言任务上预训练过的Transformer竟然在一系列看似完全不相关的任务(视觉,蛋白质折叠,数值计算)上微调后,取得比直接训练显著提高的效果。这一结果暗示了语言任务中存在某种结构对于许多其他类别的任务也能通用。Eric Jang et al [2]在多任务学习 (multi-task learning) 的框架下利用语言嵌入 (language embedding) 作为任务嵌入 (task embedding) 来学习机器人多任务策略,展示了零样本泛化的可能性:机器人训练集中的任意一条数据从未同时包含“瓶子”和“托盘”,也没有被训练过“将瓶子放入托盘”这个任务,却可以在测试集中零样本泛化解决这个任务。这个结果表明利用这种训练方式,模型学到了“将A放入B”这样一个抽象的概念,这与语言的组合性其实是相同的:我们仅需要有限的词汇和语法结构就可以进行无限种可能的表达,正是因为每种词汇和语法结构不同方式的组合都可以被定义成一个新的概念,而这种组合方式是无穷的。

近期的具身智能大模型 (foundation model) 其实也是沿着这个方向进一步地规模化 (scale up)。 比如Google Deepmind的RT-X[3],采用的就是在大规模语音数据集上预训练过的Transformer以及在视觉任务上预训练过的ViT作为backbone,在多形态(multiple morphology) 的具身任务数据集上微调,从而解锁了零样本,系统性泛化 [4] 到新任务的能力,在一定程度上缓解了具身智能数据采集成本高昂的问题。

3. 目前的具身智能系统

距离通用具身智能的根本性差异

值得注意的是,虽然RT-X展示了在多种机器人形态上工作的结果,但这是通过较为工程化的手段来实现的,具体来说模型仅输出机器人末端执行器 (end effector)的轨迹,而中间连接轴的运动则通过逆向运动学 (inverse kinematics) 以闭合解的形式得到。本质上来说这种方法意味着机器人的具体形态已经被人为地抽象掉了,模型并不需要关心具体形态,其导致的局限性是模型没有办法像人和动物一样灵活地运用机器人的身体组成部分来完成任务,比如考虑一个“拿起瓶子”的任务,人可以用手指抓起,或者用手掌握住,甚至用手掌和手臂弯成角度夹起瓶子。这种对于本体的认知和灵活运用能力是目前的具身智能体做不到的。

另一方面,目前具身智能体解决的绝大多数任务都是在视觉背景为桌面的环境下(tabletop scenario),这种简单的背景实际上大大简化了对于视觉认知能力的要求,实际学习到的策略没有办法直接用到复杂的非结构化背景的环境下,原因是目前的视觉自监督学习 (vision self-supervised learning) 还没能学习到对于世界的结构化表征,不具备足够视觉认知能力,而这也是实现具身通用智能的关键因素之一。同时,与人和动物能够自主学习新的技能相比,没有任何证据表明目前基于模仿学习的方法能够通过大规模的预训练涌现出训练集中从未出现过的技能(与前述的零样本泛化到新任务不同,此处强调的是新技能,比如“举起瓶子”和“举起杯子”是两个不同的任务,但是用到相同的技能)。

相对地,模仿学习对精选数据 (curated data) 的要求,强化学习方法则不需要人为构造复杂数据集来学习策略,而是只需要与环境交互,并通过优化奖励函数在线地学习策略 (online policy learning)。强化学习 (尤其是无模型强化学习,model-free RL) 由于无法直接获取环境动力学的梯度信息,在样本效率方面往往比模仿学习低几个量级,对于学习在物理环境中运行的策略,这样低效的学习方式是不现实的。一般来说有两种解决方案:

一种是通过构建一个与真实环境类似的模拟器,在模拟器中使用大量数据学习到一个策略,然后在真实环境中零样本泛化或在线微调 (如[5, 6]); * 另一种方案是学习一个关于环境的模型,并利用学到的模型来生成学习数据 (如[7, 8, 9]),从而极大得减少对真实环境数据的需求,基于这一想法,Philipp Wu et.al. [9] 展示了仅仅通过与真实物理世界进行1小时的交互就能让机械狗学会走路并抵抗外界的干扰。

然而,目前没有证据表明基于强化学习的方法训练出的智能体能涌现出对其所解决的任务和环境的认知能力,比如基于[9]的方法训练需要频繁地人为重置机械狗的位置,因为机械狗的奖励函数只鼓励它向前走,即使碰到墙也会反复向前冲撞。

这些结果都暗示了基于目前的深度学习范式来实现通用具身智能所面临的一些根本性挑战:

1)目前的学习系统本质上仍是一个开环系统,需要人类智能的介入(如根据学习结果,有针对性地采集更多更好的数据,调整数据的概率分布,反复迭代优化奖励函数等)来实现闭环,用Yann Lecun的话来说就是,目前的机器学习系统是Assisted Intelligence,而实现通用具身智能需要的是Autonomous Intelligence [10];

- 目前的方法还不具备从自然模态中学习到关于世界的结构化表征与抽象(或者说世界模型)的能力,相对地,人类和动物在婴儿时期就能从自然模态(如视觉,听觉等直接来源于外部世界的信号)中学习并基于直觉理解物理世界的结构和运作规律(intuitive physics [11]),这种自然习得的认知能力是实现通用具身智能的关键。

4. 任务指定问题、

常识、自然抽象和世界模型

由于缺乏了学习关于世界的层级化抽象的能力,以目前的方法构建学习系统面临一个非常困难的实际问题:任务指定问题 [12](其本质也是某种对齐问题),通俗来讲就是说想要训练一个模型来精确地完成一项人类工程师心里希望其完成的任务,是一件极其困难的事。

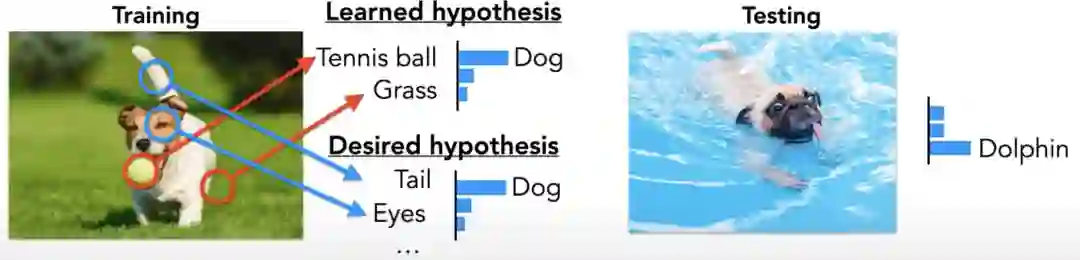

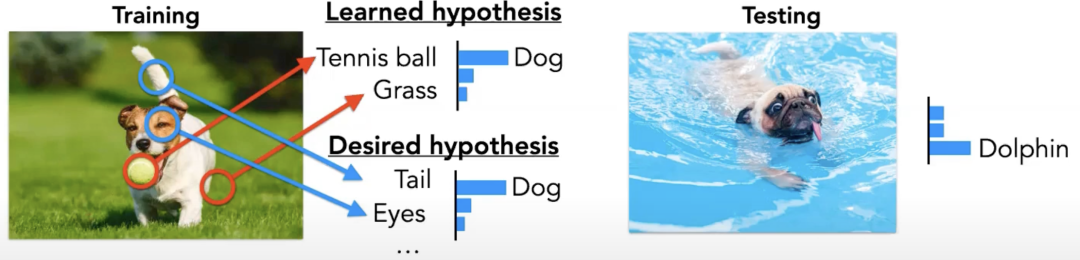

比如说,要想训练一个模型做图像识别,模型被训练优化其输出与图像标签在一个确定数据集上的交叉熵,因此这一任务实际上隐式地是由数据集来定义的,这就产生了一个巨大的挑战:为了指定一个任务,我们需要提供海量的信息。问题还不止于此,比如图1所示,在训练集上模型使用了错误的方法(通过检测到网球和草地)得到了正确的分类(小狗),于是其在测试集上(由于检测到背景水池)错误地将小狗分类为海豚。

那么这里的根本问题是什么呢?为什么人能够很轻易地(通过仅仅几个比特信息量的自然语言)让另外一个人做一件事,而告诉机器做一件事却异常费力?我认为是因为我们希望机器解决的任务和我们对任务的数学描述之间存在差异性:拿图像分类举例,我们实际希望机器解决的任务可能是“以人认为最自然的方式对这些图像进行分类”,而不是“找到能最好地拟合这些图像标签的方法”。那么什么是“人认为最自然的方式”呢?这可能就是我们所说的常识(common sense),比如我们对图像分类时只会考虑图像的主体(看小狗而不是看其背后的背景),我们会通过寻找具有因果关系的特征来分辨不同的物体(因为有尾巴和眼睛所以是小狗),我们知道物体与物体之间的关系(比如狗尾巴是小狗的一部分)等等。

进一步地,到底什么是常识,人类的常识到底是怎么来的,为什么不同的人(甚至分别来自从未有过接触的文明)也能产生类似的常识(因而人和人之间能够使用语言交流),甚至人和动物之间也能用(包括肢体)语言进行一定程度的交流。我认为其原因在于人类和动物都有一套相类似的学习关于世界的自然抽象(natural abstraction [13],自然抽象假说认为我们的世界存在某些稳定的低维结构)的方式,从而他们能学到相似的层级化抽象。这一套层级化抽象的低层级端通常是相对高维度的,难以直接用语言表述出来的分布式连续表征;而其高层级端通常是更加低维度的,经过了抽象压缩后具有一定语义信息的表征;其顶端是离散的具有清晰语义的符号化表征。在计算方面,从低层级到高层级分别对应于认知科学中系统1和系统2之间连续渐变的信息处理模式,而常识则对应于这套层级化抽象体系中层级之间与层内不同部分之间的连接结构,正是由于不同的人和动物都能学习到相类似的抽象和连接结构,仅需要通过最高层的离散符号表征作为信息传递的载体来指定任务,所有的低层级的任务信息不需要直接指定,而是由信息的接受者根据高层级信息和自己的抽象体系用类似于贝叶斯推断(bayesian inference)的方式进行补全。

因此,我认为实现通用具身智能的一个关键问题,是如何使机器学习系统从自然模态中(如视觉,听觉)学习到关于世界的层级化抽象(或者说是世界模型,认知地图;以下我们将其简称为世界模型)。为什么这么说呢?我认为至少有以下几点原因:

(1)世界模型能很好地将感知和认知统一在同一个框架下。

在目前的具身智能系统中,从感知到认知似乎是通过相对独立的模块来完成的,比如通过基于SLAM或者深度学习的方法获得关于周围环境的三维几何信息如深度图;通过基于深度学习的方法获得含有语义信息的结果如目标检测,分类,分割等;再通过手写的规则或者较为传统的人工智能技术对结果进行处理来获取一定的认知能力,如对场景的理解等等。这种模块化的方法在模块与模块之间的衔接上面临着很大的挑战,这也是高级别的自动驾驶技术迟迟难以落地的原因之一。

究其本质,我认识根本问题在于感知和认知是同一个连续光谱的两端,是一个难以分割的整体,要完美解决感知问题必然涉及到认知,反之亦然,并且认知能力并不是凭空产生的,因此合理的做法并不是通过将认知模块直接设计进智能系统,而是在同一个框架下通过对更低层级的感知任务进行优化,使得认知能力自然地涌现出来,这看起来也是人类和动物学习认知世界的方式。

(2)世界模型让智能体以计算可行的**(computationally-tractable)**方式对未来进行长期预测和规划。

我们在预测和规划时空上遥远的事件时往往会做层级化的抽象,并使用相对粗粒化概念化的表征,比如规划去国外旅行,我们会先考虑途径哪些城市,而不是细分到从某座大楼怎么到另一座城市的某座大楼。这种在合适粗粒度上进行规划的能力使得我们可以利用有限的计算资源有效地寻找到一个高度优化的方案,这对时间和空间上的长远期规划是至关重要的。

Tufts大学的发育生物学家(developmental biologist)Michael Levin提出了认知光锥(cognitive light-cone)的概念来衡量智能体的认知能力,认为智能体能够测量,模拟,并影响的事件在时间和空间上的边界决定了智能体的认知极限。比如,人类会关心并研究早至宇宙起源时期,而遥远至目前宇宙视界边界的事件,包括时间空间尺度远小于/大于其自身生理过程的事件(如基本粒子的相互作用,星系的演化等),因而人类具有很强的认知并改造世界的能力。相比之下,更加低级的智能体,如一个草履虫,一个细胞,可能仅仅关心其身边的溶液浓度梯度等小尺度事件,就不需要很高的认知能力。

(3)世界模型包含了事件间的因果关系**(一种特殊的对时序的抽象),使得智能体能够进行反事实推理(counterfactual reasoning)****,并据此高效且自动地学习新知识和新技能。**

人类和动物学习技能相比于目前的人工智能系统具有高得多的样本效率,其中一个很重要的原因应该是我们能够通过世界模型构想出行为和结果之间的对应关系(即因果关系)。因而当我们希望达到某种结果(完成某个任务)的时候,即使事先从来没有做过,我们也可以很容易地规划出一个大致的行为轨迹。当我们重复一个任务,我们会不断做反事实推理来反思中间的哪些步骤可以做得更好,这个循环往复的过程就是我们学习新技能的过程。

5. 在机器/统计学习框架下如何学习世界模型

那么核心问题就变成了:如何构建一个机器学习系统使其能从自然模态学习到世界模型?并且需要注意的是,这样的学习系统应当是autonomous intelligence,而不是目前这样需要由人类频繁干预来帮助的assisted intelligence [10] (如需要人类采集curated dataset,并且反复调整数据的分布来确保其多样性);另一方面,提出的学习方式应当是实际可行的,其中一个重要指标就是计算可行性(computational tractability),因为其实很容易就能提出一些没有任何实际操作可行性的方法来实现具身通用智能,比如根据物理定律精确模拟宇宙的演化并等待其中出现像人类一样的智慧生物,又比如试图以不可计算(uncomputable)的量作为优化目标(比如Kolmogorov complexity)。

要回答这个问题,从机器学习/统计学习的角度,可以从四个方面来考虑:

(1)神经网络架构

大脑是一个具有记忆和反馈连接的动力系统,且时刻都在预测感官信号并纠正其预测,这种层级化的预测编码架构(predictive-coding)连接了感知与认知。我们第一视角能感知到的关于世界的一切信息都是存在于大脑状态中的信息流。相比之下,当今主流的人工神经网络架构是前馈的(feedforward),没有状态或信息反馈流,这种架构似乎不太可能编码表征世界的状态信息。近期的一项研究[14]表明,transformer的上下文学习能力与其前向展开(forward pass)过程中的记忆容量(或等效于中间状态的大小)存在因果关系,而不是与模型参数的数量。这一发现表明,记忆容量对于通用学习能力的涌现起着至关重要的作用,而如何有效地带有记忆和反馈链接的神经网络架构是目前还未解决的问题,其本质是一个极具挑战性的temporal credit assignment问题[15] (即如何衡量当前时刻的某一变化对未来某一时刻结果的影响,在神经网络训练的语境下对应于根据未来某个目标函数的值如何反推以调整神经网络的参数;目前深度学习中最主流的反向传播算法就是一种credit assignment机制)。

在学习新技能时,大脑会动态生成促进专门(task-specific)神经回路形成和加强的奖励信号。相比之下,当前的机器学习系统依赖于数据集或工程师设计的奖励函数中包含的信息,还无法通过自我迭代产生远超数据分布的能力,我认为这从某种意义上来说反映了目前的系统还没有能够实现类似于生命体通过摄取能量来降低其热力学熵,智能体通过整合处理信息实现信息熵降的能力。

从复杂动力学系统的角度来看,大脑表现出的这种下行因果关系(即相对高层级的认知过程会反过来影响到相对低层级的神经活动)是某些复杂动力系统的普遍特征,这些系统在多个尺度上运作,例如细胞、人体、公司和人类社会等等。这些系统通常包含多个层级的反馈循环,其中每个尺度上都有具有代理能力(agency)的组件参与解决对应的问题,同时受到更低和更高层级的影响和约束。比如在一个公司里,基层的员工负责处理基层的事务,同时受到管理层员工的管理,管理层员工同样受到高级管理层的管理,每个层级都只需要关心自己层级的问题,而他们组合起来形成了一个具有自主决策和应变能力的整体。Michael Levin将这种架构称为multi-scale competency [16],并指出这种架构有效避免了上层组件对下层组件进行微管理(micro-management),使得整个系统从计算角度来说更加高效,也更具有弹性和鲁棒性。因此我认为在多个尺度上的信息反馈循环(feedback loop)可能对autonomous intelligence的涌现至关重要,而这在当前系统中是不具备的。

(2)学习法则

上面的讨论中也提到,目前的神经网络普遍采用前馈架构,并不是因为不想用带有多层级反馈回路和状态的神经网络架构,而是我们不知道如何有效地训练这种架构。甚至在1986年Hinton等学者提出反向传播(backpropagation)之前,没有人知道如何有效地训练多层的前馈神经网络,当时主流的方法还是逐层训练,但这种局部的训练方法的有效性远不及反向传播。

那么很自然的一个问题是:大脑到底使用了怎样的学习法则?从神经科学和生物学方面的证据来看,大脑不太可能在做反向传播,Zador Anthony et. Al. [15]认为大脑利用灵活的递归结构和机制在线(online)且高效地解决temporal credit assignment问题,但具体的机制和原理还没有被很好地理解。但是很多证据表明,大脑的学习机制很有可能是局部(local)的,局部学习机制的好处在于不需要同步全局的信息,并且对噪声(大脑作为一个物理系统)有更好的鲁棒性。Najarro,E.和Risi,S.展示了可以学习一种局部的赫布规则(hebbian rule)来使得随机初始化的网络在其生命周期内不断自组织其权重,使具有不同形态的智能体能够学习行走,同时对训练过程中未遇到的形态损伤(如在测试中去掉多足机器人的一条腿)具有鲁棒性。

这似乎表明局部学习规则有望解决当前AI系统与自然智能在学习方面的一些显著差别:

1)训练和推理阶段互相分离,在训练过程中,权重通过随机梯度下降(SGD)的反向传播进行更新,而在推理阶段通常保持不变;

2)基于统计学习的方法通常假设环境的分布是静态的(stationarity)(比如训练是在randomly shuffle过的封闭数据集上进行的),这一假定对于自然数据流几乎不可能得到满足;

3)目前的学习方法对于非静态的环境/任务分布无法实现持续终身学习(continual lifelong learning),而会碰到灾难性遗忘(catastrophic forgetting)的问题。而对于通用具身智能来说,具备持续学习能力至关重要,因为世界是不断演化的,通用智能体只有通过不断改变自己内部的状态来适应变化的环境,才能确保其能力的通用性。试想我们如果想让一个通用智能解决5年之后人类将遇到的问题,很显然我们没有办法在现在采集到与该任务相关的数据,只有让其具有学习的元能力才能确保其有可能解决在未来才会出现的新任务,因此探索受生物启发的可塑性(plasticity)和temporal credit assignment是值得研究的,这些机制可能在实现具身智能适应不断变化的世界所需的在线持续学习方面更加有效。

(3)目标函数

假设世界模型的学习可以归结为优化一个目标函数,那么这个目标函数可能是什么呢?Deepmind的创始CTO Shane Legg和其导师Marcus Hutter提出,在被动环境中(指智能体不能直接采取行动来干预环境),一个普适的智能衡量标准是预测未来的能力 [17]。Yi Ma, Doris Tsao和Heung-Yeung Shum提出,学习的目的是找到数据中的模式和规律,这可以形式化为优化一个叫做rate distortion的信息度量,优化这一目标的本质是在做信息压缩和表征的稀疏化(sparsification),尤其令人印象深刻的是,以梯度下降推导优化rate distortion的方法可以自然而然地得到类似于ResNet/Transformer的架构 [18]。从某种程度上说,整个人类的科学史也可以被认为是压缩(找到规律)和(基于找到的规律来)预测。实际上,预测和压缩之间是具有等价性的,详细的可以参考 [19]。

然而,仅凭预测/压缩并不能确保能学到世界模型,因为通过与环境交互主动获取关于世界的信息对于学习世界模型来说是必不可少的过程。此外,一个具有普适性的类人的智能体应该能够自主地习得新技能和知识,如行走、说话、操作物体、进行思维实验,甚至发明数学和物理理论。是否存在一个普遍的目标,使得这些行为得以涌现呢?Karl Friston提出的自由能原理(FEP)似乎是实现这一目标的一个很有希望的候选项 [20]。自由能原理在主动感知(active perception)的框架下统一了行动和感知,通过最小化变分(variational)自由能,鼓励智能体主动获取信息来学习世界模型,以减少其对未来观测的意外程度(surprise)。与强化学习不同的是,在主动感知的框架下智能体并不需要外部提供的与任务相关的奖励,这就避免了人为设计奖励函数会碰到的困难。然而,在实践中应用FEP会面临与变分推断(variational inference)类似的挑战:很难找到合适的参数化函数族(既能够表达复杂的概率分布,又是计算上量上可控的)。

在解决高维数据分布的计算可行性方面,Yann Lecun,Yoshua Bengio等学者做过不少尝试。比如,Yann在 [10]中指出,对于高维数据来说,超过二阶的统计量几乎都是在计算上没有实际可操作性的,数学上来说学习概率分布的一大挑战是如何高效地计算出归一化系数(partition function),大脑也不太可能去学习整个高维数据的分布,据此他提出基于能量的模型(energy-based models),即不直接参数化概率分布,而是参数化一个不需要归一化的函数来表达数据间的兼容性(直观上来说就是描述哪些情况可能发生,哪些情况不太可能发生,哪些情况几乎不可能发生)。

相比于FEP,一个更可行的方法是通过对抗训练的方式来学习世界模型,如Herrmann V、Kirsch L和Schmidhuber J设计了一种算法,让一个名为世界模型的神经网络和一个名为控制器的神经网络之间进行对抗性博弈,其中控制器的内在奖励可以是世界模型的信息增益、算法压缩进度或在具有可计算答案的更抽象问题上的正确性等等,他们展示了通过神经网络权重编码的自我发明思维实验进行学习的可能 [21]。此外,Ma、Tsao和Shum的研究表明 [18],以信息压缩作为目标函数,并通过一个传感器(编码器)网络和一个控制器(解码器)网络之间的闭环零和博弈可以有效地避免神经崩溃 [22],这是传统的(自)监督学习面临的一个很大的挑战。这些发现都表明,压缩、信息增益和非合作博弈可能是非常普适的目标/机制,并且有助于通用智能的涌现,值得进一步研究可扩展的计算方法来建模和优化这些目标函数。

(4)数据/环境

训练智能体的数据和环境也对通用智能的产生起到关键的作用。目前的主流的做法在采集数据和训练模型上是分离的,而我们也看到这对于复杂的实际问题是有局限性的,比如自动驾驶车需要在各种不同的路况和道路布置上实现人类水平的驾驶技术,就很容易发现在固定数据集上训练是行不通的,而需要不断用当前学到的驾驶策略去采集新数据,并用新数据进一步更新驾驶策略,实现反馈闭环。其实人类驾驶也是类似的,在驾校中学习完以后,上了大马路还需要一段时间的学习适应,在一个城市习惯了以后,到了另一个路况差别很大的城市,又需要一段时间的学习适应,在这个过程中大脑依靠认知能力不断产生新的解决专用任务的神经回路,因此我们能感觉到在路况发生变化时我们会更加全神贯注(系统二的注意力介入),一段时间之后便不再需要注意力介入慢慢变轻松了(专用神经回路已经形成)。

进一步地,我认为在固定的数据集上训练模型/(强化学习)在封闭的环境下训练智能体存在的一个根本性问题,是智能体往往不需要掌握学习的元能力(即对应于上述人类适应新状况的能力)就能够解决任务,那么很自然地,智能体就不会习得这种元能力。与之相关地,Evan Hubinger等人 [23]提出了mesa-optimizer的概念,并认为机器学习系统存在mesa-optimization的现象(此处值得注意的是mesa-optimization与meta-optimization是两个相似但不同的概念,后者是指在更高的层级上对优化算法本身进行优化),即一个基优化器(base optimizer),这里往往指的是基于梯度下降和反向传播的优化算法,可以用来优化一个神经网络,并且优化出来的神经网络本身也会变成一个优化器(learned optimizer/mesa-optimizer)。

比如在大规模数据上训练过的transformer会涌现出in-context learning的能力 [24],并且发现这种能力的涌现与数据集中任务的多样性呈现因果关系,这种能力本身就等价于在做某种学习优化 [25]。那么如何理解这种涌现现象呢?Evan Hubinger等人 [23]提供了一种看法:当任务环境特征包含多样性、多分枝,涉及新颖情境或任务实例时,更加容易涌现出mesa-optimizer。这是什么原因呢?可以这样理解:当任务环境缺乏上述特征时,绝大多数的策略优化(policy optimization)可以完全由基优化器来完成就能达到很好的效果,学到的策略本质上是一种调整地特别好的启发式方法,有点像老师傅不假思索纯凭经验手感完成一项重复性很强的技能;相反,如果任务环境变化多端极为复杂时,纯凭经验拍脑袋就会失效,比如要训练一个会做数学奥赛题的智能体,题目千变万化,不可能仅凭过去的经验就做对每一道新出现的题,那么只有当meta-optimizer本身也具有优化能力才能够解决这种情况。

再举两个例子:1)如果我们想训练一个会走迷宫的智能体,迷宫的形状千变万化,要想通过学习状态变量到行动的映射(类似于根据直觉来蒙)几乎不可能解决,但其实解决任意迷宫问题的算法只需要几行代码的逻辑(比如广度优先搜索),因此更好的解决方法是学到这样一种在线优化的算法来解决这个走迷宫的任务;2)我们所在的地球上环境千变万化,自然演化作为一种基优化器没有办法直接优化出一种能解决任何问题的生物体,因为解决任何问题也包含了解决未来可能需要解决的问题,这个问题空间是无穷大的,因此自然演化最终优化出了像人类和动物这样的通用智能/mesa-optimizer,他们可以通过不断地学习来适应变化的环境。类似的观点同样可以用来解释GPT的通用任务解决能力,GPT模型在互联网级别的语言数据集上进行训练,要能够在如此多样化的训练集上降低损失函数,很可能必须涌现出类似于in-context learning这样在线学习优化的能力。

更近一步地,我认为一个适合通用智能涌现的环境应当至少具有开放式(opened-endness)非平稳性(non-stationary)的特点,比如说我们所生存的这个世界,不断地会有新的复杂性的出现。相对地,目前的绝大多数强化学习的环境都是有限的,类似于单机游戏总有通关的时候,在通关以后没有任何进一步学习适应新环境的动机和必要性了,那么自然不需要涌现出适应性和通用学习能力。

6. 总结

本文介绍了基于目前深度学习技术的具身智能研究涉及到的方法(模仿学习和强化学习)及其面临的挑战,分析了近期基于基础模型的工作在通往通用具身智能道路上取得的进展及其局限性。在此基础上讨论了以目前的方法训练具身智能系统将面临的一个根本性挑战(任务指定问题)以及其本质原因(缺乏结构化层级化抽象,世界模型),并论证了世界模型对于实现具身通用智能的关键性。最后,从1)神经网络架构,2)学习法则,3)目标函数,4)训练数据/环境,这四个方面讨论了目前的深度学习范式在未来的可能改进方向,以便使得具身智能体能够学习到世界模型并涌现出通用的学习能力。

致谢

作者在此感谢岳玉涛博士,徐博文,冯睿洋对本文提出的修改意见。

学者简介

参考文献

[1] Lu, Kevin, et al. "Pretrained transformers as universal computation engines." arXiv preprint arXiv:2103.05247 1 (2021). [2] Jang, Eric, et al. "Bc-z: Zero-shot task generalization with robotic imitation learning." Conference on Robot Learning. PMLR, 2022. [3] Padalkar, Abhishek, et al. "Open x-embodiment: Robotic learning datasets and rt-x models." arXiv preprint arXiv:2310.08864 (2023). [4] Bahdanau, Dzmitry, et al. "Systematic generalization: what is required and can it be learned?." arXiv preprint arXiv:1811.12889 (2018). [5] Akkaya, Ilge, et al. "Solving rubik's cube with a robot hand." arXiv preprint arXiv:1910.07113 (2019). [6] Zhuang, Ziwen, et al. "Robot parkour learning." arXiv preprint arXiv:2309.05665 (2023). [7] Ha, David, and Jürgen Schmidhuber. "World models." arXiv preprint arXiv:1803.10122 (2018). [8] Hafner, Danijar, et al. "Dream to control: Learning behaviors by latent imagination." arXiv preprint arXiv:1912.01603 (2019). [9] Wu, Philipp, et al. "Daydreamer: World models for physical robot learning." Conference on Robot Learning. PMLR, 2023. [10] LeCun, Yann. "A path towards autonomous machine intelligence version 0.9. 2, 2022-06-27." Open Review 62.1 (2022). [11] Piloto, Luis S., et al. "Intuitive physics learning in a deep-learning model inspired by developmental psychology." Nature human behaviour 6.9 (2022): 1257-1267. [12] Agrawal, Pulkit. "The task specification problem." Conference on Robot Learning. PMLR, 2022. [13] https://www.lesswrong.com/posts/gvzW46Z3BsaZsLc25/natural-abstractions-key-claims-theorems-and-critiques-1 [14] Kirsch, Louis, et al. "General-purpose in-context learning by meta-learning transformers." arXiv preprint arXiv:2212.04458 (2022). [15] Zador, Anthony, et al. "Catalyzing next-generation artificial intelligence through neuroai." Nature communications 14.1 (2023): 1597. [16] Bongard, Joshua, and Michael Levin. "There’s plenty of room right here: Biological systems as evolved, overloaded, multi-scale machines." Biomimetics 8.1 (2023): 110. [17] Legg, Shane, and Marcus Hutter. "Universal intelligence: A definition of machine intelligence." Minds and machines 17 (2007): 391-444. [18] Ma, Yi, Doris Tsao, and Heung-Yeung Shum. "On the principles of parsimony and self-consistency for the emergence of intelligence." Frontiers of Information Technology & Electronic Engineering 23.9 (2022): 1298-1323. [19] Grünwald, Peter. "Minimum description length tutorial." Advances in minimum description length: Theory and applications 5 (2005): 1-80. [20] Friston, Karl. "The free-energy principle: a unified brain theory?." Nature reviews neuroscience 11.2 (2010): 127-138. [21] Herrmann, Vincent, Louis Kirsch, and Jürgen Schmidhuber. "Learning One Abstract Bit at a Time Through Self-Invented Experiments Encoded as Neural Networks." International Workshop on Active Inference. Cham: Springer Nature Switzerland, 2023. [22] Kothapalli, Vignesh, Ebrahim Rasromani, and Vasudev Awatramani. "Neural collapse: A review on modelling principles and generalization." arXiv preprint arXiv:2206.04041 (2022). [23] Hubinger, Evan, et al. "Risks from learned optimization in advanced machine learning systems." arXiv preprint arXiv:1906.01820 (2019). [24] Kirsch, Louis, et al. "General-purpose in-context learning by meta-learning transformers." arXiv preprint arXiv:2212.04458 (2022). [25] Akyürek, Ekin, et al. "What learning algorithm is in-context learning? investigations with linear models." arXiv preprint arXiv:2211.15661 (2022).

(参考文献可上下滑动查看)