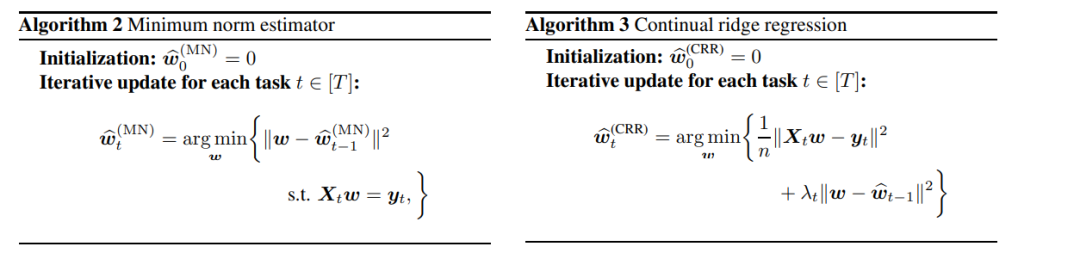

我们对基于正则化的持续学习在一系列线性回归任务上的统计分析进行了研究,重点关注不同正则化项如何影响模型性能。我们首先推导了在所有数据同时可用的假设下获得的oracle估计器的收敛速度。接下来,我们考虑了由矩阵值超参数索引的一类广义ℓ2正则化算法,其中包括最小范数估计和持续岭回归作为特例。随着更多任务的引入,我们推导出了广义ℓ2正则化估计器估计误差的迭代更新公式,从中我们确定了导致最优算法的超参数。有趣的是,超参数的选择可以有效地平衡前向和后向知识转移之间的权衡,并调整数据异质性。此外,我们明确推导出了最优算法的估计误差,其阶数与oracle估计器相同。相比之下,我们对最小范数估计和持续岭回归的下界分析显示了它们的次优性。我们的理论分析的一个副产物是持续学习中的早停和广义ℓ2正则化之间的等价性,这可能具有独立的意义。最后,我们进行了实验来补充我们的理论。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日