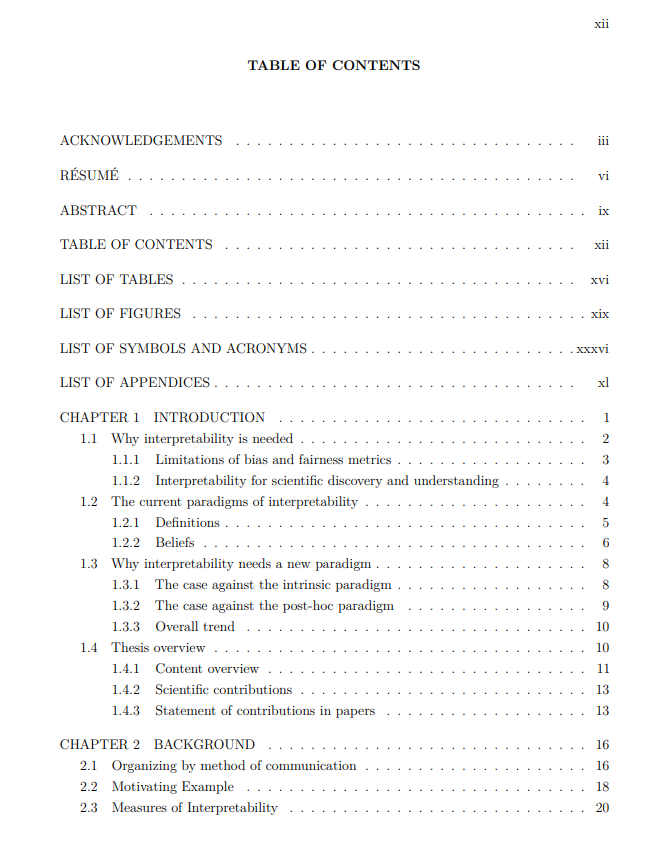

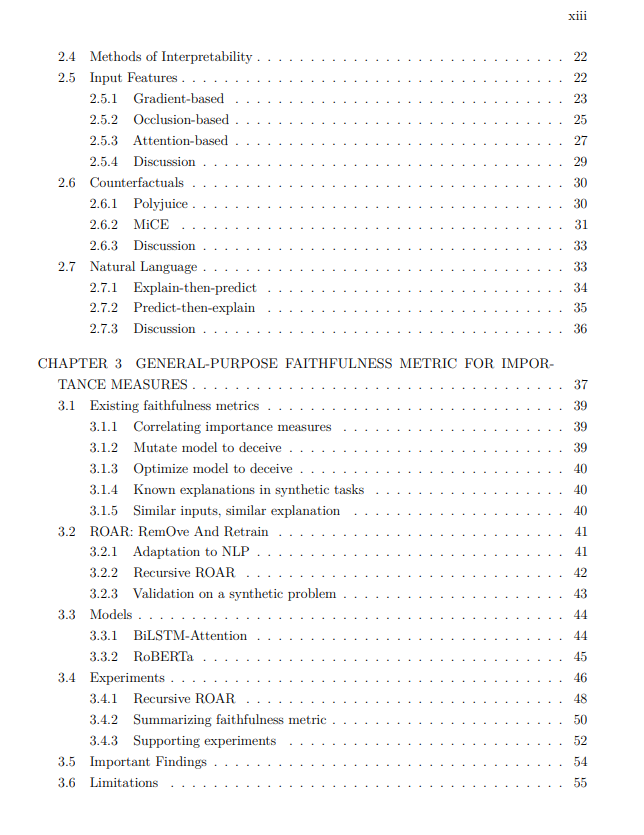

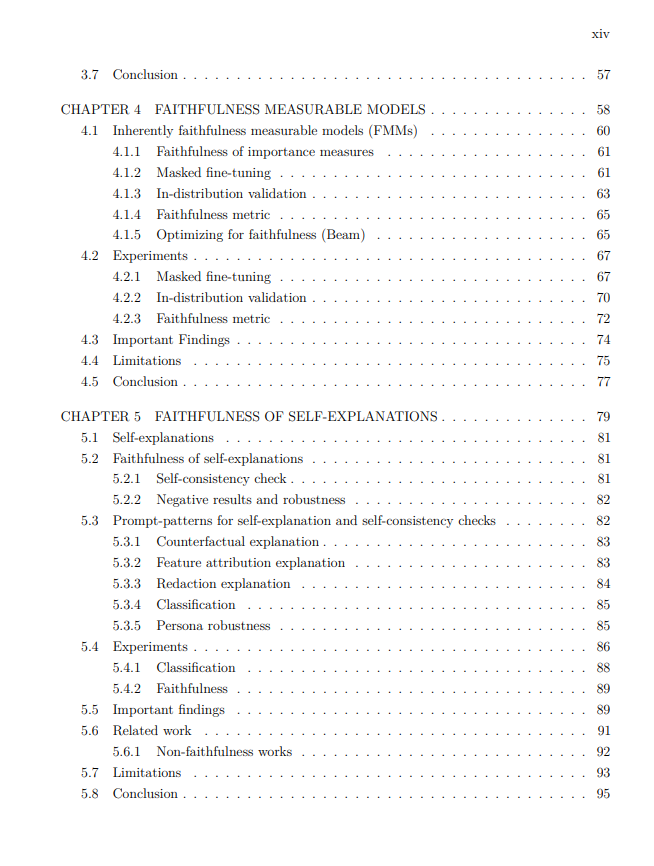

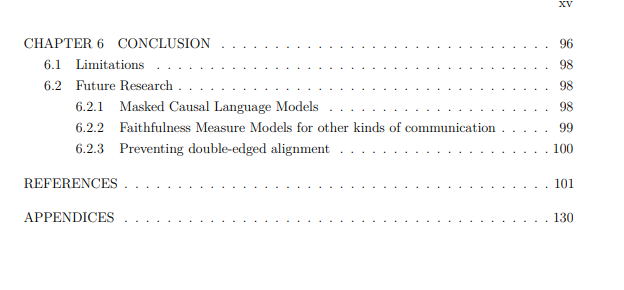

https://arxiv.org/pdf/2411.17992

机器学习,特别是神经网络,现如今广泛应用于许多领域,如贷款评估、搜索结果和招聘推荐。这些系统通常提供自动化决策,影响着大多数人的生活。近年来,自然语言处理(NLP)应用特别受到关注,尤其是非常高效的通用模型的出现,特别是聊天系统,这些系统现在被广泛使用,甚至普通公众也能直接使用它们。

不幸的是,这些系统并非没有缺陷。仅在招聘系统中,就有性别歧视的案例,比如简历中“国际象棋俱乐部成员”受到青睐,而“女性国际象棋俱乐部成员”则被忽视,或者某些系统认为计算机科学学位是医院打字员的必要资格。虽然前者可能通过分析模型的性别偏差并加以修正来缓解,但后者过于具体,可能只能通过解释模型的预测来揭示。 可解释性 是一个研究领域,致力于用人类可以理解的术语解释模型和数据集。其目标通常是防止不良行为,正如上述例子所示。不幸的是,这个领域经常面临提供错误解释的问题,即解释并未反映模型的真实情况。例如,解释表明哪些输入词语很重要,可能并不比随便指出随机词语更有价值。当解释真实反映模型时,这种解释被称为“忠实解释”。 不幸的是,衡量一个解释是否忠实(忠实度指标)非常具有挑战性,因为我们无法得到真实的标准答案。一个重要的原因是,模型通常太复杂,人类难以理解,因此无法判断解释是否忠实于模型。更糟糕的是,设计不当的忠实度指标可能会给出错误的信心,而错误的解释则可能会给出对模型行为的虚假信心。因此,本论文的核心研究问题是:“如何为复杂的通用神经网络自然语言处理模型提供并确保忠实的解释?” 在可解释性领域,目前有两种主要的范式来回答这个问题:内在范式和后验范式。 内在范式认为“只有在架构上设计为可以解释的模型才能被解释”,而后验范式认为“可以且应该在模型训练完成后生成解释,以避免任何性能影响”。 通过分析现有文献并提出新的忠实度指标,本论文认为这两种范式都未能取得有效的进展。后验解释的忠实度经常受到批评,而内在模型要么实际上并非内在的,要么由于过于受限,无法成为高性能的通用模型。 因此,本论文假设该领域应通过结合两种现有范式的优点,发展出新的范式来回答核心研究问题。具体来说,本论文设计了无需架构约束的可解释模型,这样这些模型仍然是通用且高性能的。特别地,本文提出了两种潜在的范式,即“忠实度可度量模型”(FMMs)和“自解释”。FMMs直接回答核心研究问题,而自解释目前尚未完全解答该问题,但可能在未来解决。 忠实度可度量模型(FMMs) 是本论文提出的新范式,它将内在范式的“设计可解释的模型”重新表述为“设计能够便捷且可靠地测量忠实度的模型”。如本论文所示,这比内在范式提出的目标要容易得多,因为它不要求架构约束。该范式的具体展示应用于重要性度量——即指出每个输入特征在做出预测时的重要性。对于这类解释,FMMs只需对训练过程进行小幅修改,即在训练时随机屏蔽输入标记。 这种训练过程使得我们可以使用忠实度擦除指标:“如果一个特征确实重要,那么如果去掉该特征,模型的预测应该会发生显著变化。” 这个指标不能应用于任何模型,因为去除特征(例如词语或标记)会导致分布外问题。然而,这种FMM支持去除特征,因此使得该指标得以应用。由于现在忠实度测量变得既便宜又可靠,因此可以优化解释,以达到最大的忠实度。因此,FMMs变得间接地内在可解释,但无需架构约束,并且还回答了如何衡量忠实度,从而回答了核心研究问题。 自解释 是另一种新兴范式,这些解释直接作为模型的输出生成。这类解释因聊天系统的兴起而变得流行,这些系统通常会以自然语言的形式阐明它们发出的解释。然而,由于自解释的自由形式,评估其忠实度极为困难。此外,由于这些模型也存在幻觉问题,因此有充分的理由对此保持怀疑。尽管如此,这些解释仍然非常普遍,并且常常被当作真理接受,包括研究人员在内。为了评估这一新范式的可行性,本文还提出并评估了自解释的忠实度指标。研究结果表明,类似于后验解释,它们是模型和任务相关的。 本文还研究了后验和内在解释的忠实度,发现结论与模型和任务的依赖性相同。然而,当使用忠实度可度量模型时,即便使用相同的后验解释方法,且在相同的数据集和基础模型上,也得出了不同的结论。 这得出一个总体结论:忠实度默认是依赖于模型和任务的。然而,即便是对模型进行简单修改,如随机屏蔽训练数据集(如在忠实度可度量模型中所做的),也能极大地改变局面,从而得到一致忠实的解释。我们提供了一些建议,说明如何也可以通过自解释来实现这一点。此外,利用忠实度可度量模型,本文证明了有可能确定新的可解释性范式,克服过去的局限,并回答如何为复杂的通用神经网络自然语言处理模型提供并确保忠实的解释这一核心研究问题。