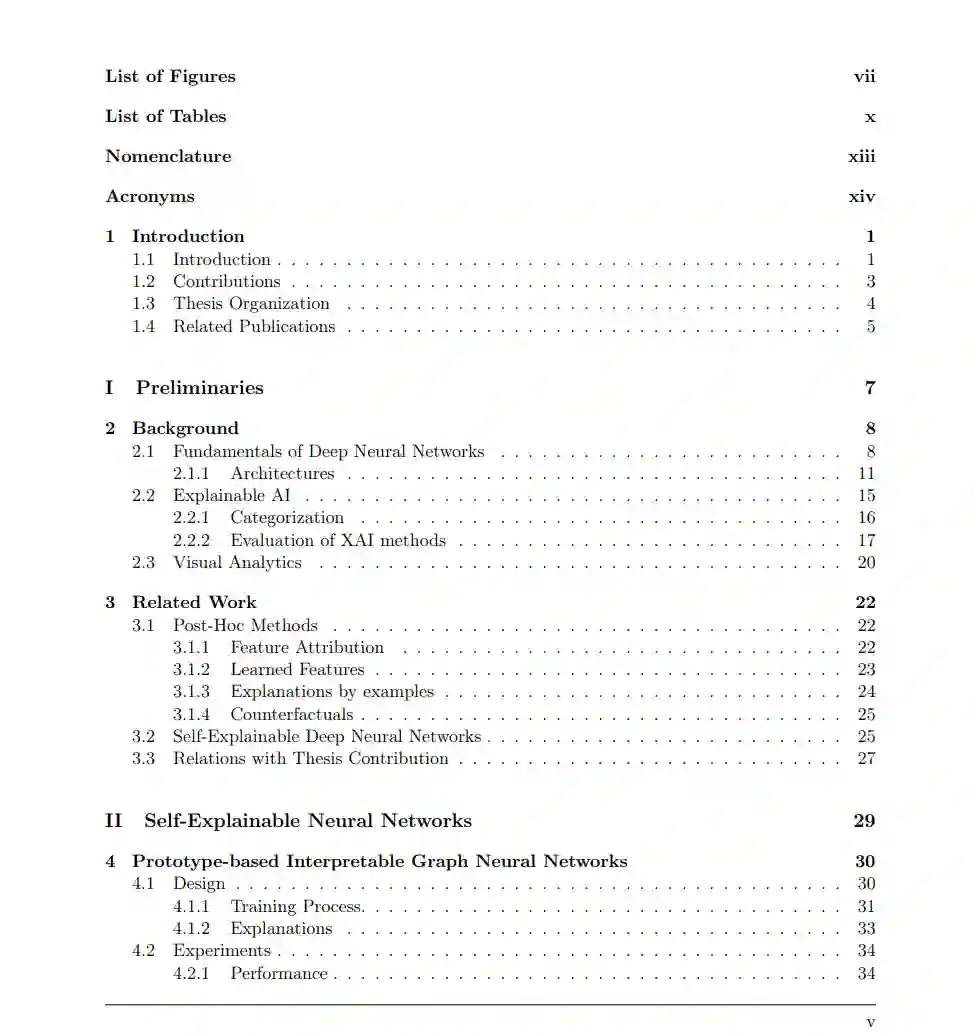

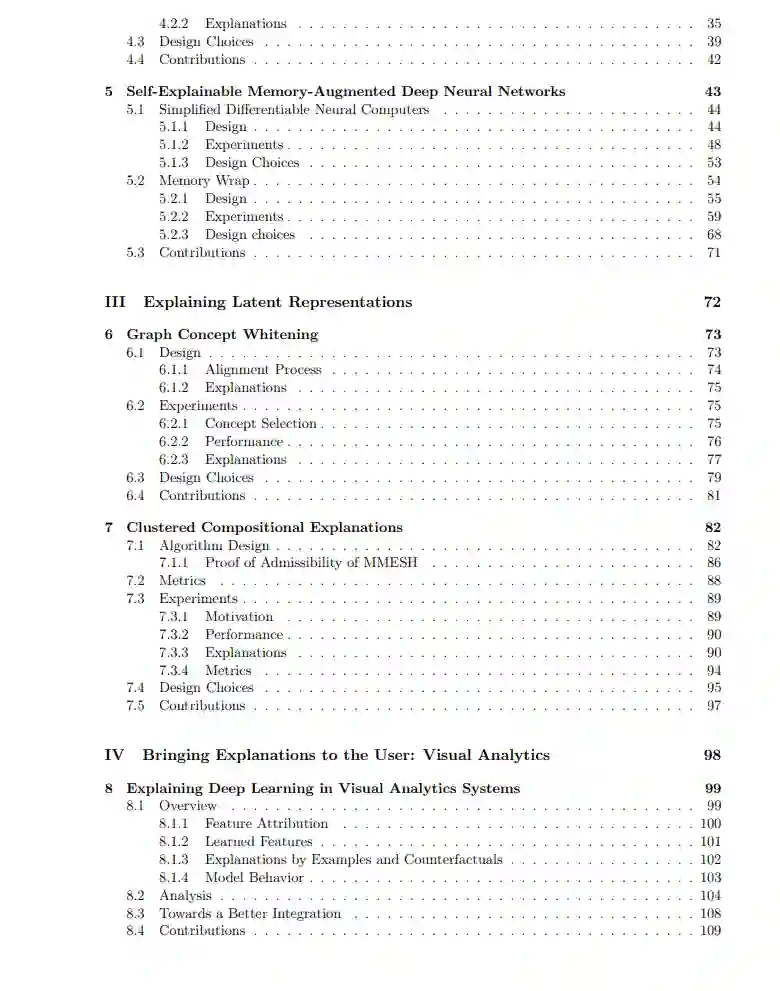

深度神经网络在过去十年里推动了人工智能的发展,彻底改变了游戏、生物学、自动系统以及语音和文本助手等领域。尽管其影响深远,但由于其复杂的结构和缺乏对决策过程的解释,这些网络往往被视为黑箱模型。这种不透明性对人工智能系统的广泛应用和可信度构成了重大挑战。本论文通过贡献于可解释人工智能(eXplainable AI)领域,致力于提高深度神经网络的可解释性,从而解决这一问题。 论文的核心贡献在于引入新的技术,通过分析深度神经网络的内部工作原理,使其更加可解释。具体而言,贡献有三方面。首先,论文介绍了自解释深度神经网络的设计,例如集成外部存储器以实现可解释性,以及在多个领域中使用基于原型和约束的层。这些提出的架构旨在保留大部分黑箱网络,从而保持或提高其性能。其次,研究深入探讨了训练好的深度神经网络中的神经元,揭示了与其激活值相关的被忽视的现象。最后,论文分析了解释性技术在可视化分析领域的应用,探讨了其采用的成熟度以及这些系统向用户传达解释的潜力。 总之,本论文通过提出内在技术来提高深度神经网络的可解释性,为日益发展的可解释人工智能领域做出了贡献。通过缓解深度神经网络的不透明性问题,并将其应用于多个不同的领域,该研究旨在增强对人工智能系统的信任,并促进其在各个应用中的广泛应用。

人工智能(AI)是计算机科学的一个领域,旨在开发能够解决通常需要人类智能的任务的机器。最初成功的AI方法植根于依赖规则和符号推理的专家系统。然而,尽管早期充满乐观情绪,符号AI在适应能力上显示出局限性。这些系统通常假定对任务有完美的知识,而忽视数据中的不确定性或模糊性。因此,纯符号AI难以处理人类无法描述现象规则的复杂任务。例如,翻译文本、识别图像和探索未知环境等任务被认为是不可能解决的。 机器学习(ML)作为AI研究中的一个范式转变,旨在缓解这些问题。ML提供了能够从数据中学习并随着时间推移提高性能的算法,而无需明确了解特定现象的规则。经典的ML算法使用统计理论在一组数据上进行模式识别。这一类别的例子包括决策树、逻辑回归和支持向量机,这些曾是处理复杂任务的最先进工具,直到最近为止。 近年来,互联网的扩展和廉价硬件、开源平台以及大数据的可用性使得能够收集大量原始数据集。然而,经典的ML由于数据集的规模、复杂性以及缺乏显式语义而难以充分利用这些数据集。相反,深度神经网络(DNN)被专门设计用于处理原始数据,并在网络层之间的互连中记住大量信息。因此,利用DNN的深度学习(DL)领域已成为ML的主要子领域。 一个DNN由数千或数百万个互连的神经元组成。自Rosenblatt的工作以来,神经元和DNN的设计变得越来越复杂,涉及非线性运算、卷积、记忆、注意力和跳跃连接等功能。这些设计的复杂性使得DNN在各种任务中实现了令人印象深刻的性能,往往超越人类的表现。游戏、视觉、机器人技术和自然语言处理等领域都经历了革命性的变化。如今,主流的语音识别、机器翻译和文本生成应用程序都由DL系统驱动。然而,性能的提高以透明度为代价。虽然符号系统在编码知识和决策过程方面容易理解,但经典的ML在这两个方面往往更加不透明。实际上,跟踪学习过程具有挑战性,并且这些系统的可解释性通常仅限于提取学习到的决策过程。但即使在这些情况下,复杂性和透明度之间也存在权衡。例如,使用大型ML模型(例如,宽而深的决策树)时,提取易于理解的行为解释可能具有挑战性,因为解释可能非常冗长。对于DNN来说,这一挑战更加严重,因为数据没有语义关联,跟踪输入如何转化为输出由于互连的复杂性而变得极其困难。因此,DNN通常被称为黑箱,人们只能输入和输出结果而不理解背后的动机。 可解释人工智能(XAI)领域旨在解决机器学习和AI系统中的透明性和可解释性需求。XAI旨在提供对AI模型内部工作原理的见解,使用户能够有效地理解和解释其输出。XAI包含广泛的技术,从突出输入中最重要部分的方法到提取机器学习模型所学知识的方法。 在经典ML中,XAI方法主要集中于提供简明的解释,总结已经知道的决策背后的原理。这些方法的例子包括特征重要性分析,它识别对模型预测最相关的特征,以及决策树可视化,它提供了决策过程的图形表示。在DL的背景下,XAI方法处理未知的决策过程和未知的学习知识,旨在近似、猜测或探测真实模型的行为。该领域中最早也是最流行的方法是所谓的外在方法,这些方法通过利用外部手段近似DL模型的行为并生成解释。例如,几种技术采用代理模型、生成模型或基于扰动的分析来近似网络在给定点周围的决策过程。尽管这些方法灵活且与现有模型高度兼容,最近的研究表明单靠外在方法并不可靠。实际上,外在方法往往难以捕捉DNN模型行为的复杂性,受外部手段选择的偏见影响,并且由于DNN处理任务的复杂性,需要花费过多时间来返回可靠的近似结果。 为了解决这个问题,研究人员开始探索内在方法,这些方法旨在通过利用模型的内部工作原理来增强深度模型的可解释性。可以通过修改DNN的设计使其更具解释性,调整其训练过程以生成可解释的表示,或者分析和连接其组件的工作机制来实现这一目标。这些方法包括注意力机制,它们突出相关输入特征,激活分析和自解释DNN。内在方法的优势在于直接将可解释性与模型设计联系起来。它们通常比外在方法更快,并且更忠实于模型行为。然而,它们通常针对特定设置(架构、训练过程等)进行定制,并且在自解释DNN的情况下,可能会出现性能权衡,从而限制了普通用户的采用。 本论文通过提出利用DNN内部工作原理解释DL的方法,为XAI内在方法的持续研究努力做出了贡献。在这一背景下,论文提出了多种自解释DNN的设计和一种后训练方法来调查神经元的识别能力。所提出的自解释DNN的目标是减少性能权衡并扩大这些方法的适用性。为了实现第一个目标,提出的层可以插入到黑箱模型中而不破坏其结构,并保持其大部分表示能力。第二个目标是通过扩展方法到新的领域,将前面的层视为黑箱(即不利用特定的形状或结构)并在几种架构中评估提出的技术来实现的。作为副产品,论文还增加了自解释DNN方法的多样性,因为它引入了一种新的架构家族:基于记忆的自解释DNN。 同样,所提出的后训练方法共享兼容性和依赖DNN内部工作原理(即激活)的基本原则,并推进了我们对神经元编码语义的认识。具体来说,它使得能够研究比文献中探讨的更广泛的设置,揭示与神经元激活谱相关的新现象。 最后,论文探讨了如何使解释对用户有用和有益的持续讨论。最近,出现了几种交互系统,通过利用交互界面和由大型语言模型驱动的对话系统来连接用户、DL系统和解释。本文通过调查XAI技术和可视化分析(VA)系统的结合,为这一研究做出了贡献。通过调查现有方法并提倡将XAI技术整合到VA系统中,论文旨在增加XAI和VA社区彼此的意识,并为交互解释开辟一种新的替代方向。