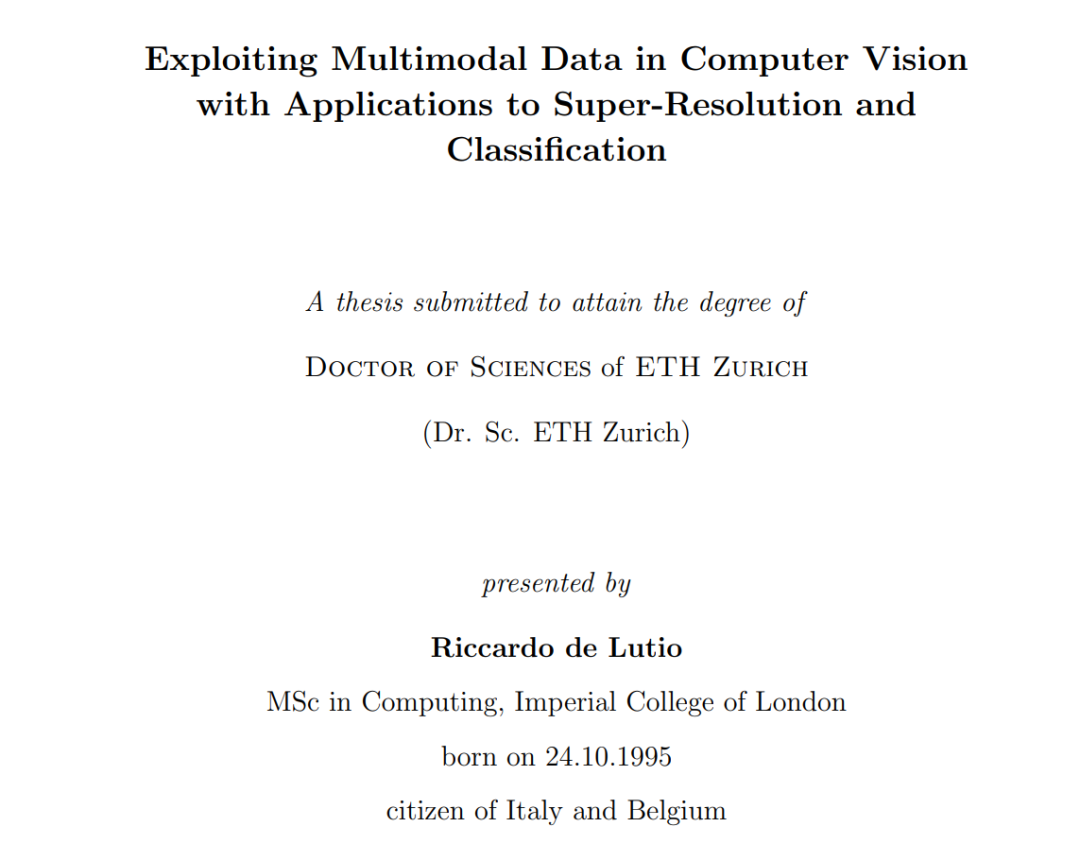

计算机视觉系统自从分类手写数字的时代以来取得了巨大的进步。特别是,监督学习已经成为解决科研之外任务的普遍方法。这些系统被部署在从自动驾驶汽车到自动医疗诊断和天气预报等多个行业的众多产品中。这些进步可以归因于深度学习算法、专业库和专用硬件的进步,以及用于模型训练的大型标注数据集的增加。然而,仍然存在一些任务,其中仅仅捕获和标注更多数据的标准范式并不是一个可行的解决方案。 在这篇论文中,我们调查如何最好地利用多模态数据来解决获取足够质量或完整性数据困难的计算机视觉任务。我们专注于两个特定任务:引导式超分辨率和细粒度分类。引导式超分辨率涉及通过将低分辨率数据与辅助模态结合来进行放大,而细粒度分类需要利用边际信息,使分类算法能够捕捉到细粒度类别之间细微的外观差异。最初,我们在缺乏地面真实数据的情况下为引导式超分辨率提供解决方案。首先,我们提出了一种将引导式超分辨率视为学习从引导到源域的像素到像素映射的新颖无监督公式。我们使用多层感知器参数化来保留高频细节。其次,我们提出了一种新颖的混合模型,以在保持解决测试时优化问题的严谨性的同时,最好地利用深度学习方法。关键是一个可微分优化层,它作用于一个学习的亲和图,确保目标对源的高保真度,因此对未见域具有高泛化性。随后,我们提出了一种自动识别社区科学家照片中细粒度植物标本的统一方法。该方法旨在利用社区科学家观察中通常可用的各种先验知识,包括地理和时间背景以及植物分类学,以学习跨类似物种的可转移表示。最后,我们提出了2021年半地球植物标本馆数据集,这是我们作为机器学习竞赛的一部分创建的一个大型策划和开放获取的植物标本数据集,以鼓励进一步研究从照片中自动识别细粒度植物物种。 近年来,计算机视觉领域取得了显著进步。当然,这些进步可以归因于深度学习研究、专业库和专用硬件的进展,但最重要的是,这些进步得益于大量数据的可用性,例如像ChatGPT(OpenAI,2022年)和Stable Diffusion(Rombach等,2021年)这样的生成模型分别在互联网上爬取了数十亿的文本和图像进行训练。 然而,并非所有任务都能使用现成的互联网规模数据集来解决。许多重要问题,如自动检测恶性肿瘤、评估自然灾害造成的损害或绘制濒危物种的地理分布,仍然是放大数据收集不是解决方案的挑战。这些挑战可以大致分为两类。首先,由于传感器捕获它们的固有技术限制,感知特定模态存在困难,例如遥感器如航空或卫星成像或主动传感器如激光扫描仪、ToF相机或MRI扫描仪。其次,观察罕见事件或特定数据类型的多样性困难,因为在现实世界的数据收集工作中不经常遇到某些场景或类别。例如,捕捉所有容易发生事故的驾驶场景,或收集所有生物物种的足够数据就是这种情况。

为了解决数据收集质量挑战性应用中传感器可用性的限制,一个可行的解决方案是利用更常见的传感器捕获的数据来增强传感器的输出。这种设置在许多计算机视觉任务中都很常见,特别是在低分辨率传感器与捕获不同模态图像的高分辨率传感器配对时。这项任务,被称为引导式超分辨率,涉及在高分辨率引导图像的帮助下增加低分辨率源图像的分辨率。一个常见的实际应用是在RGB图像的指导下对深度图进行超分辨率。这种配置在配备有深度传感器和常规摄像机的各种设备上都能找到,如增强/虚拟现实头戴式显示器(AR,VR),现代手持设备,机器人和自动驾驶汽车。事实上,消费级深度摄像头捕获的深度图分辨率较低;类似地,激光扫描仪获得的稀疏深度测量可以在相对较大的印记上进行平均。相反,即使是入门级相机现在也能以非常高的分辨率捕获图像。这种设置也经常用于环境监测,例如树高、生物量或物种分布概率等关键指标的地图通常可用的分辨率远低于现代遥感器的地面采样距离(Keil和Jetz,2014年,Metzger等,2022年)。因此,一个自然的问题是如何利用这些系统捕获的成对图像来提高低分辨率传感器的质量,从高分辨率传感器传输细节。 获取大量高质量注释的挑战甚至可能比数据收集过程本身更加困难。这是至关重要的,因为监督学习在计算机视觉的成功中发挥了核心作用,可以追溯到深度学习早期的开创性工作,如AlexNet(Krizhevsky等,2012年)赢得ImageNet ILSVRC-2012挑战赛(Deng等,2009a)。事实上,全球数据标注市场预计到2028年将达到82.2亿美元(Grand View Research),凸显了其重要性。例如ImageNet这样的基准通常为每个类提供大量的训练图像,在这种设置下,分类算法取得了令人印象深刻的结果。然而,一旦我们减少每个训练类的图像数量,它们的性能就会迅速下降。然而,由于各种原因,简单地收集更多数据和注释并不总是可行的。例如,自然界展示了物种的长尾分布,导致大量类别不平衡,某些物种罕见或难以观察。此外,某些地区数据的可用性变化和观察者偏见可能会进一步加剧获取全面注释的难度,如图1.1所示。此外,标注这些数据集需要专业的分类学专业知识,因此许多这些观察结果仍未标注。这是大多数描述生物多样性的大型图像集合的现实,例如那些从相机陷阱、社区科学家观察、无人机调查或植物标本馆(Tuia等,2022年,Bebber等,2010年)中获得的。因此,我们认为自动物种识别工具的需求迫切。这项任务,通常被称为细粒度分类,涉及将图像分类为更广泛类别内的子类别,例如物种,并且以区分基于微妙视觉线索的标本为特征。我们认为,仅凭外观信息不足以区分细粒度类别,因为学习这种微妙模式的数据有限。幸运的是,物种观察通常伴随着侧面信息,例如捕获图像的时空背景,这些信息可以与环境先验结合使用。这个问题再次强调了开发利用多模态数据来增强自动识别标本的方法的需要。