引言

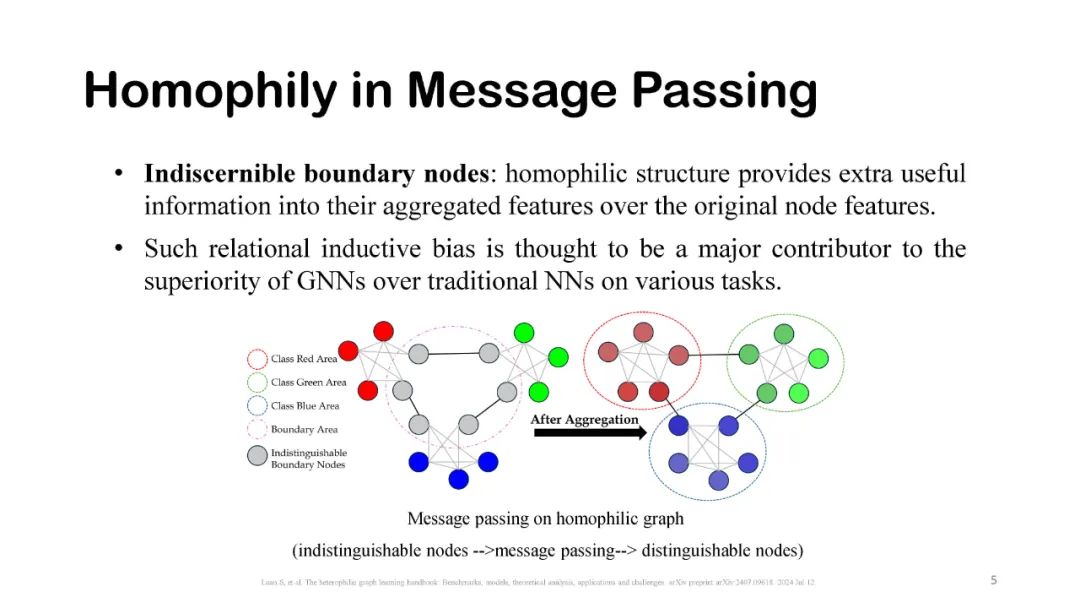

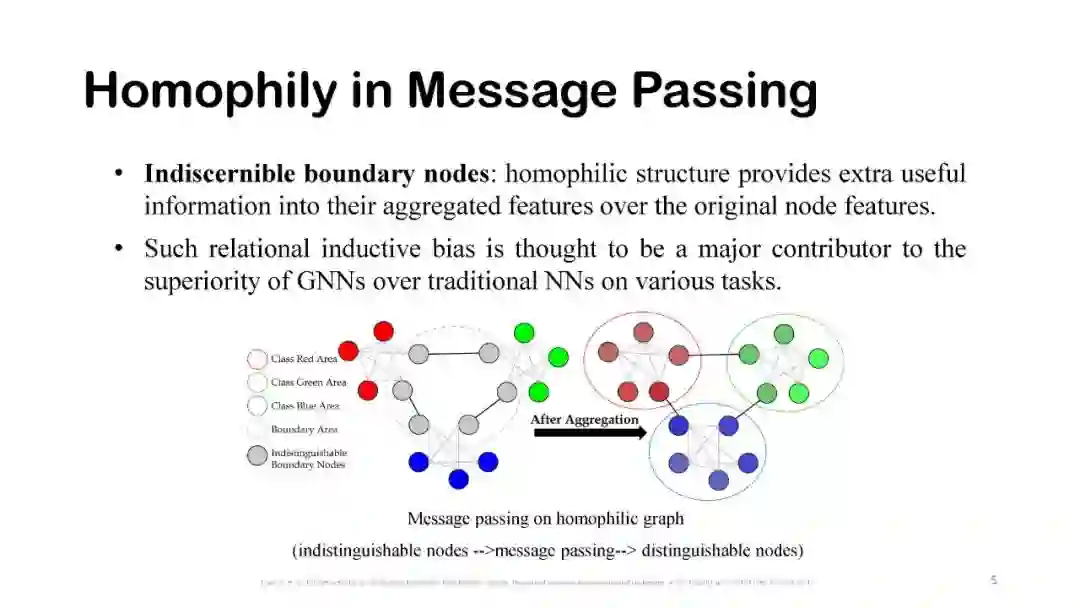

图模型,特别是在节点级任务中的成功,通常被认为源于同质性原则。同质性(Homophily)是社会学和进化生物学中的一个概念,指的是具有相似特征的个体更容易进行交流和建立联系。在图表示学习中,它描述了节点具有相同标签或相似属性的网络,这些节点更可能相互连接。这样的关系归纳偏差被认为是图神经网络(GNNs)在各类任务中优于传统神经网络(NNs)的主要原因之一。

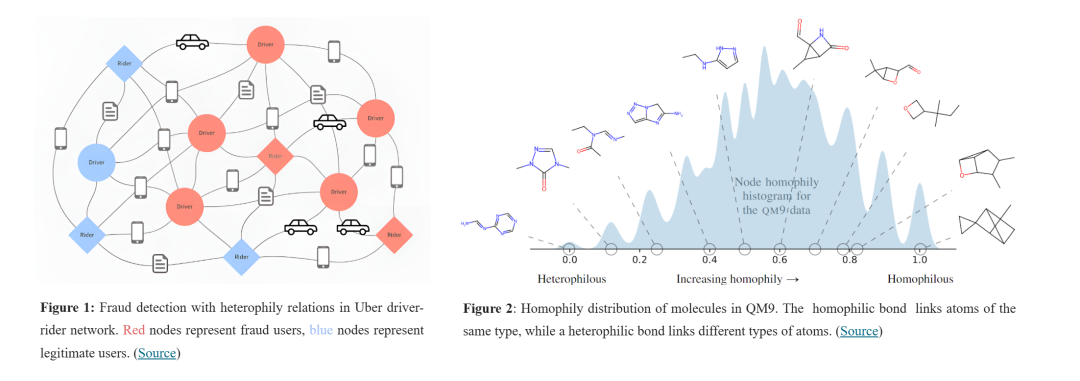

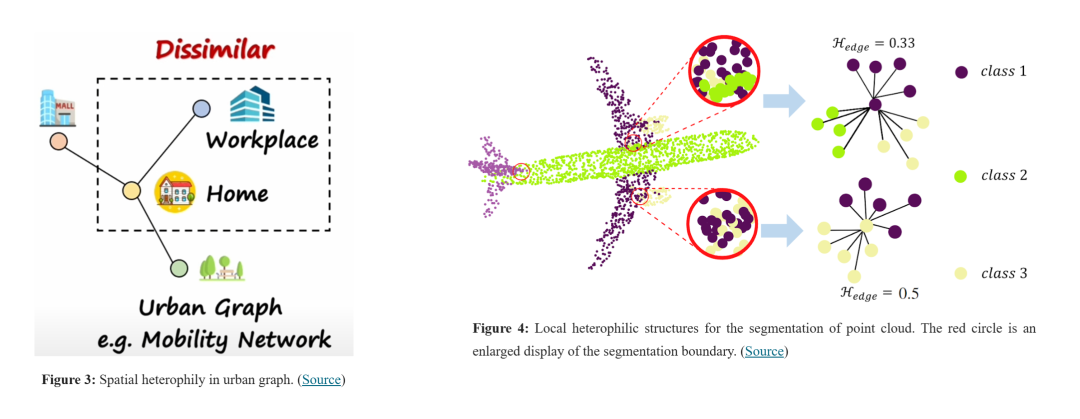

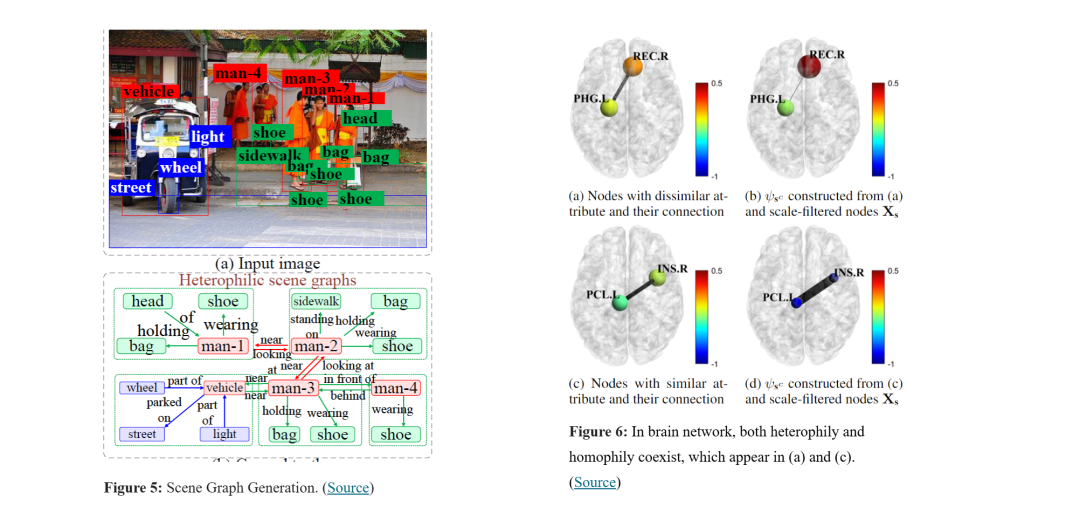

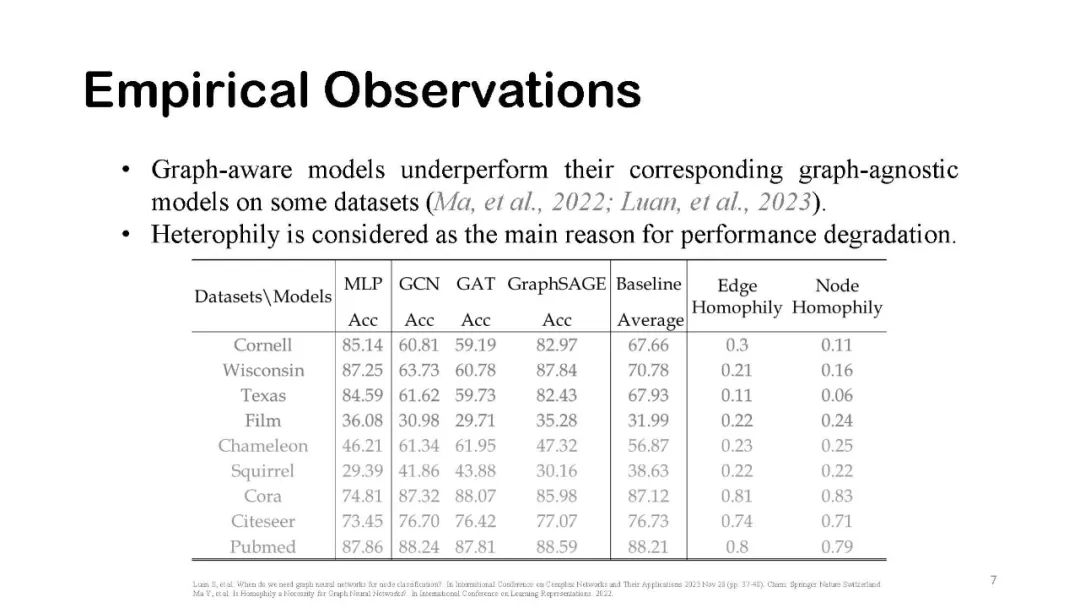

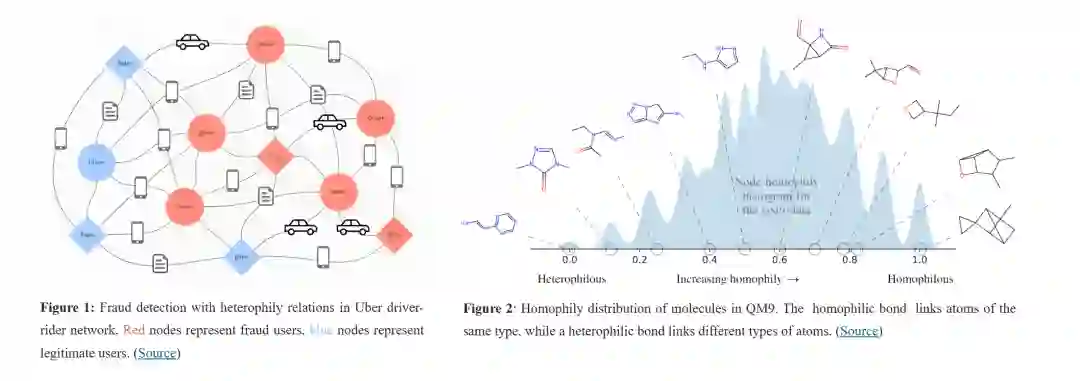

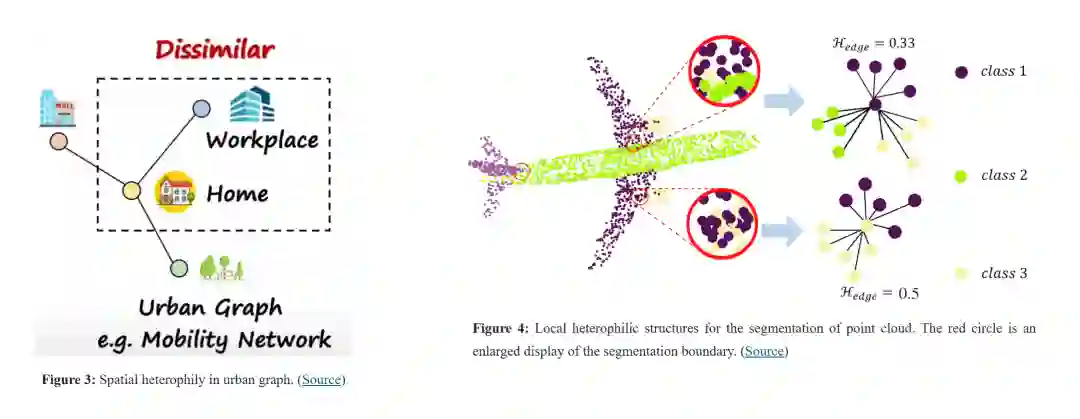

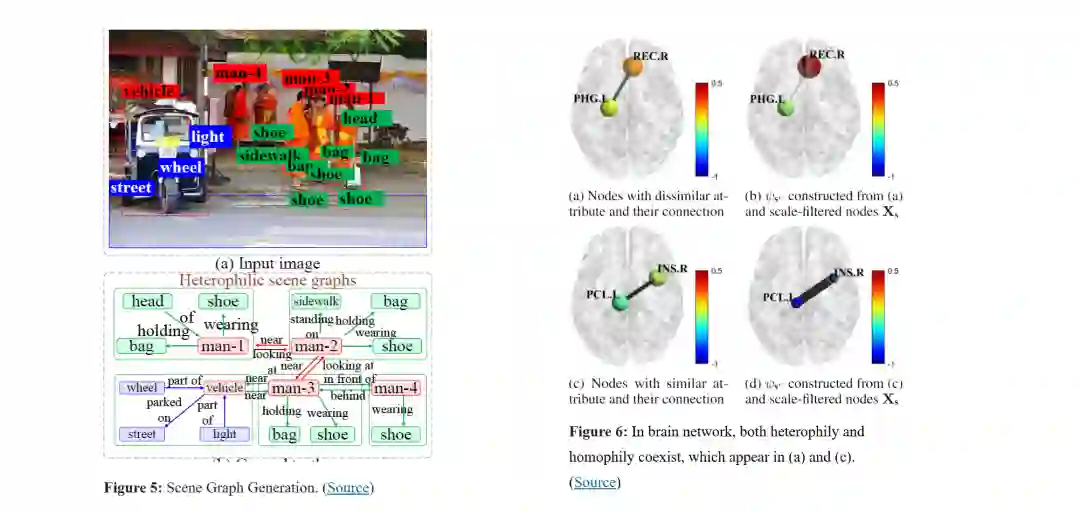

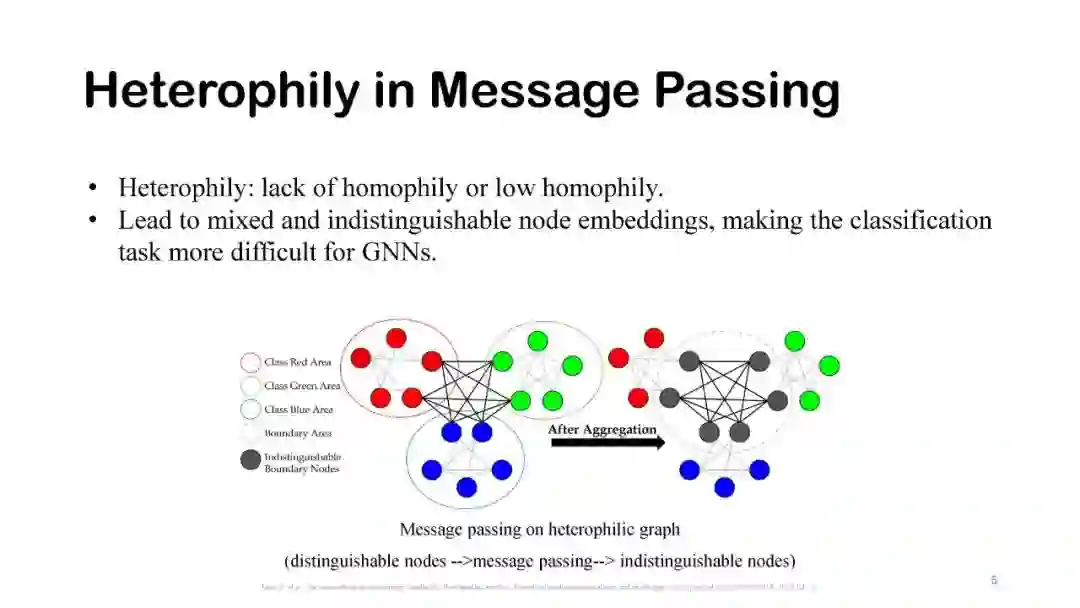

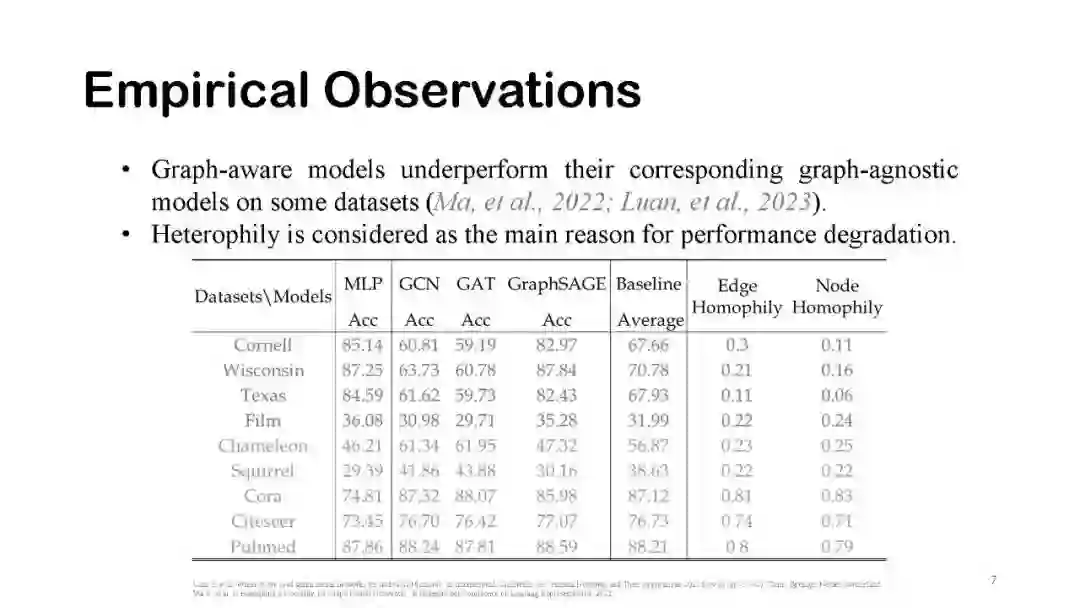

另一方面,缺乏同质性,即异质性(Heterophily),被认为是GNN在异质图(heterophilic graphs)上表现较差的主要原因,这种性能退化现象在广泛的应用场景中都有出现。人们重新审视并评估了许多现有的图模型,包括图转换器(graph transformer)及其变种,特别是在各种异质图场景中的表现,例如异构图、时序图和超图等。此外,异质性问题广泛涉及许多与图相关的应用(如图1-6所示),例如图欺诈/异常检测、点云分割、城市计算、推荐系统、场景图生成、药物发现、大脑网络分析、链路预测、隐私保护、图对抗攻击与鲁棒性等。近年来,针对异质性问题,已经投入了大量的研究和努力。

在本教程中,我们将系统地总结最新的异质性图学习进展,并以易于理解的方式呈现给读者。内容包括:(1)基准数据集的分类及在合成图上的同质性度量评估;(2)最新监督与无监督学习方法的细致分类;(3)同质性/异质性的理论分析;(4)与异质性相关的应用;(5)异质性图学习的挑战与未来方向。

https://sites.google.com/mila.quebec/heterophilic-graph-learning/home

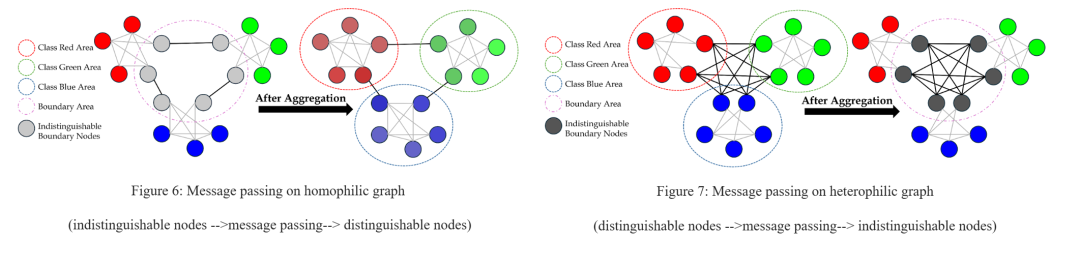

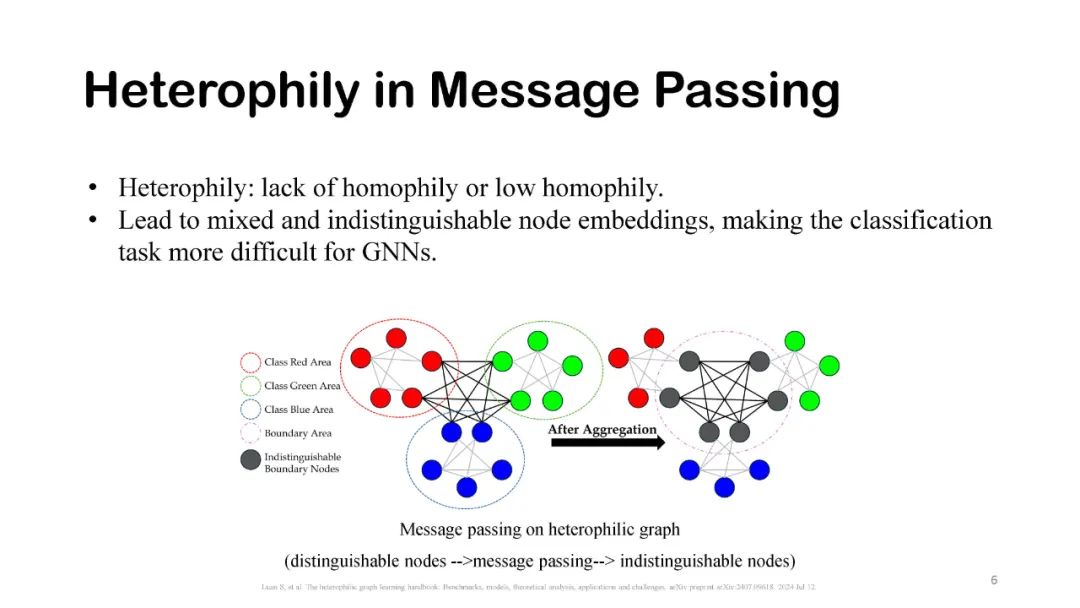

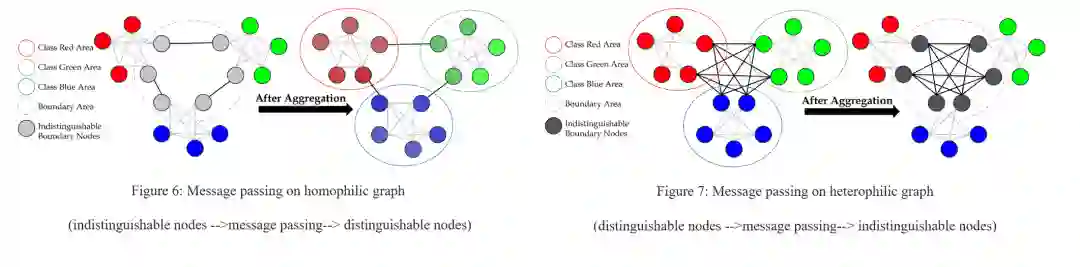

示例 如图6所示,对于不可区分的边界节点,同质性结构通过对原始节点特征进行聚合,提供了额外的有用信息。这种关系归纳偏差被认为是图神经网络(GNNs)在各类任务中优于传统神经网络(NNs)的主要原因之一。另一方面,如图7所示,边界节点拥有更多的异质性邻居,而非同质性邻居。由于异质性边缘连接的是不同类别的节点,它们可能导致节点嵌入的混合和不可区分,从而使得图神经网络的分类任务变得更加困难。

目标

本教程的目标是:(1)让大家意识到异质性问题,并理解并非所有图结构对于学习都是有用的或有益的;(2)帮助读者快速全面地回顾最新的异质性特定图模型;(3)总结实际应用,帮助读者开展与相关主题的未来研究。

课程安排(90分钟)

引言与背景知识(Sitao Luan,5分钟)

- 同质性/异质性定义

- 小心你的图:为什么在图学习中必须考虑异质性

- 同质性度量

同质性度量(Sitao Luan,Qincheng Lu 和 Jiaqi Zhu 演示代码,10分钟)

- 图-标签一致性

- 基于相似性的度量

- 邻域可辨识性/信息量

- 基于假设检验的性能度量

基准数据集(Qincheng Lu,Qincheng Lu 和 Jiaqi Zhu 演示代码,15分钟)

- 良性、恶性和模糊的异质性数据集

- 在合成图上评估同质性度量

异质性模型(Sitao Luan,15分钟)

- 在同质性图上的监督学习

- 在同质性图上的无监督学习

理论研究(Sitao Luan,15分钟)

- 中等同质性陷阱

- 同质性与分布偏移

与同质性/异质性相关的应用(Sitao Luan,15分钟)

- 欺诈/异常检测

- 链路预测

- 图学习任务

- 计算机视觉

- 场景图生成

- 点云分割

挑战与未来方向(Chenqing Hua 和 Sitao Luan,15分钟)

- 异质性在异构GNN中的表现

- 异质性在时序GNN中的表现

- 异质性在超图中的表现

- 公平性问题

- 大型语言模型和基础模型

- 分子设计