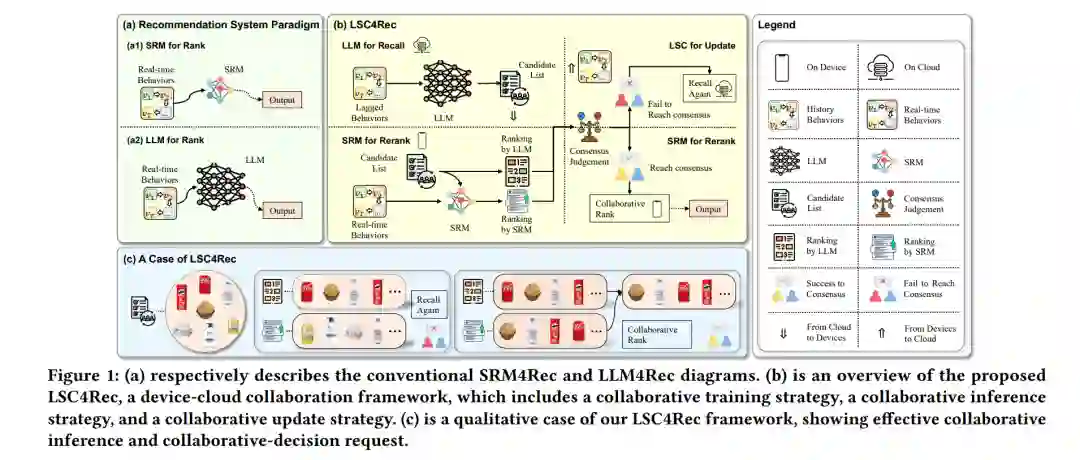

大语言模型(LLMs)在推荐系统中的应用(LLM4Rec) 是一个前景广阔的研究方向,已在该领域展现出卓越的性能。然而,LLM4Rec在实际应用中的局限性主要来自其无法捕捉实时用户偏好,原因有以下几点:(i)LLM训练和推理的成本高,频繁进行训练和推理会导致较大的开销;(ii)LLM难以访问实时数据(其庞大的参数量使得部署在设备上变得困难)。幸运的是,小型推荐模型(SRM)能够有效地补充LLM4Rec的不足,借助较少的资源进行频繁的训练和推理,并能够便捷地访问设备上的实时数据。 基于此,我们设计了设备-云协同LLM-SRM推荐框架(LSC4Rec),该框架在设备-云协作环境下运行。LSC4Rec旨在整合LLM和SRM的优势,以及云计算和边缘计算的好处,从而实现互补的协同效应。为了增强LSC4Rec的实用性,我们设计了三种策略:协同训练、协同推理和智能请求。

在训练阶段,LLM生成候选列表以增强SRM在协同场景中的排名能力,并使SRM能够自适应地更新,以捕捉实时的用户兴趣。在推理阶段,LLM和SRM分别部署在云端和设备上。LLM根据用户行为生成候选列表和初始排序结果,SRM则基于候选列表进行重新排序,并通过结合LLM和SRM的得分得出最终结果。设备通过比较LLM和SRM的排序列表一致性来决定是否需要更新候选列表。 我们的综合性和广泛的实验分析验证了LSC4Rec中每个策略的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日