近年来,随着提示学习方法在自然语言处理领域被提出,其日益受到研究人员广泛关注.它通过将各类下游任务重 构成预训练任务的形式,以参数高效和数据高效的方式将大规模预训练模型应用在各类自然语言相关下游任务中.其中以 GPT 系列为代表的模型通过提示学习在对话生成和多模态图文理解等任务上取得了巨大的成功.然而,这类模型及方法还不 能解决视觉中的稠密任务.受此启发,一些研究人员逐渐将提示学习广泛应用到视觉相关的各类任务当中,如图像识别、目 标检测、图像分割、领域适应、持续学习等.由于目前还没有提示学习应用在视觉相关领域中的综述,本文将对视觉单模态 领域以及视觉语言多模态领域的提示学习方法展开全面论述和分析.作为回顾,我们首先简要介绍自然语言处理领域的预训 练模型,并对提示学习的基本概念、下游应用形式以及提示模版类型进行阐述和分类.其次,我们分别介绍视觉单模态领域 以及视觉语言多模态领域里提示学习方法适配的预训练模型和任务.再次,我们分别介绍视觉单模态领域以及视觉语言多模 态领域的提示学习方法.在自然语言处理领域,提示学习方法以继承预训练形式实现多任务统一为主要目的;与此不同,在 视觉相关领域,提示学习方法侧重于面向特定下游任务进行设计.为此,我们将从方法设计上进行简单分类,然后从应用任 务角度详细介绍视觉单模态提示学习和视觉语言多模态提示学习方法.最后,我们对比分析了自然语言处理领域和视觉相关 领域提示学习研究的进展,并对未来研究路线给出了展望。

近年来,随着如 GPT[1],BERT[2],T5[3]等大规 模预训练语言模型的相继提出,“预训练-微调”范 式极大地推动了自然语言处理领域的发展.在这个 范式中,首先对以 Transformer[4]为主干的模型在广 泛无标注的语料数据集上通过语言建模[1,2,5]等任务 进行自监督预训练,然后在下游应用中针对不同的 任务设计不同的优化目标和添加新的网络模块,通 过对模型和添加网络模块的全部参数进行微调来 实现部署和应用.由于预训练数据体量大、模型参数 多,预训练模型具有极强的文本综合表征和理解能 力,使得“预训练-微调”范式在各类下游任务上都 展现出了卓越的性能.然而,这种范式存在以下几个 问题:(1)在不同任务上都需要优化和调整模型 的全部参数,造成了巨大的计算开销以及部署成本 的增加;(2)需要针对不同任务进行不同的优化 目标设计,不可避免地造成了预训练与下游任务之 间的差异,限制了对预训练知识的充分利用;(3) 收集专属各类下游任务的训练集对模型进行微调 成为此范式必不缺少的一个环节,不适用于数据资 源匮乏的实际应用场景. 为此,LAMA[6]、GPT-3 [7]等大规模语言模型相 继被提出,这些大规模语言模型采用一种“预训练 -提示-预测”的新范式,一定程度地解决了“预训 练-微调”范式中存在的问题,再次推动了自然语言 处理领域的发展,其中的提示学习也成为近几年的 研究热点.不同于“预训练-微调”范式需要将预训 练模型通过不同的目标设计适配应用到各类下游 任务中,“预训练-提示-预测”范式通过将下游任 务重构成预训练任务的形式,使得各类下游任务能 够以预训练预测的方式被解决,这些下游任务包括事实 调查[6,8]、文本分类[9,10]、自然语言推理[11]、命名体 识别[12]、常识推理[13,14]、问答[15]等.例如,在根据影 评“这部电影很好看”对电影情感类别判断的例子 中,不需要专门收集下游数据和额外增加一个需训 练优化的分类层到预训练模型,只需要将影评与提 示模版“这部电影的类型是___”串接起来作为模 型的输入,直接借助于预训练阶段的语言建模任务 就可以在空白处预测出电影的类别.总的来说,“预 训练-提示-预测”范式展现出了以下优势:(1)预 训练模型的全部参数都可以保持不变,极大降低了 下游应用的计算和部署成本;(2)通过任务重构 保证了下游任务与预训练任务的一致性,可以更加 充分地利用预训练模型的知识;(3)额外收集下 游训练集在这种范式下不是必要的,除了可以和微 调的方式一样应用在数据充足的场景下,提示学习 还可以在零样本或者少样本场景下使用.

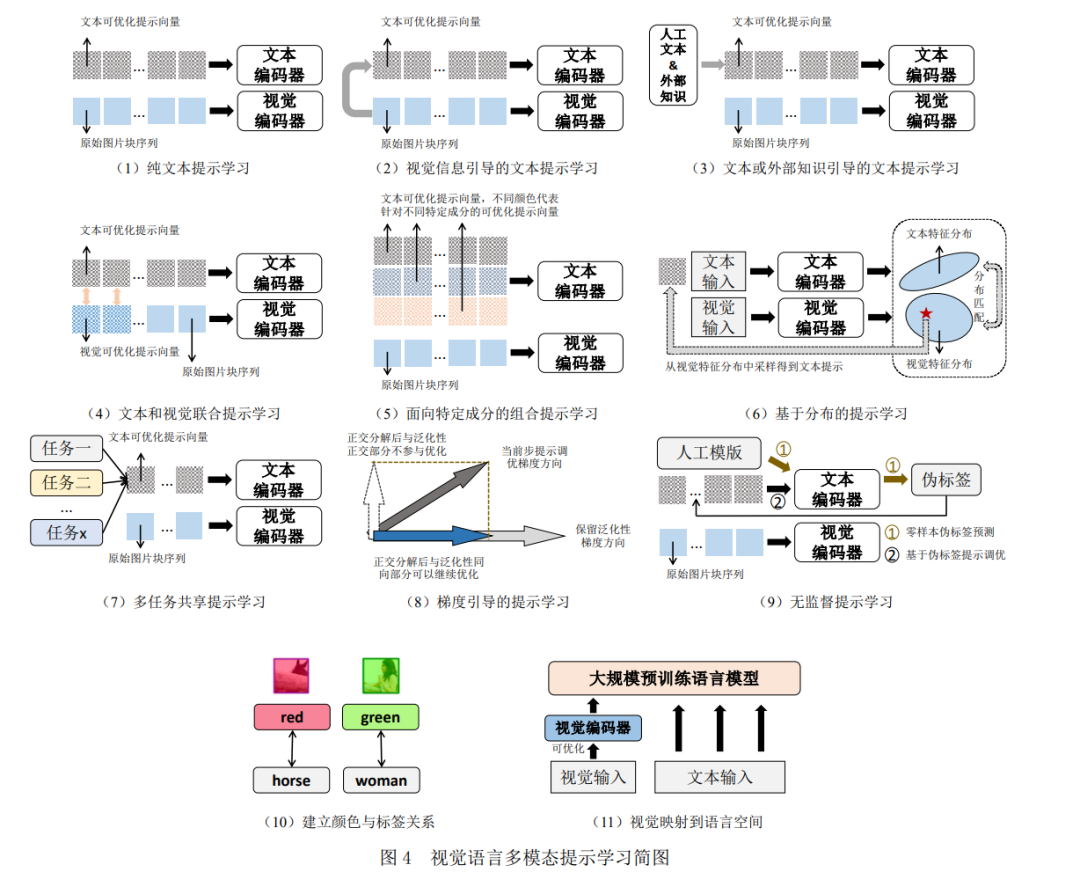

在视觉单模态以及视觉语言多模态领域,“预 训练-微调”范式被广泛采用[16,17],也同样存在计算 成本高、部署复杂等难题.受提示学习高效利用大规 模预训练语言模型的启发,很多学者将提示学习引 入到视觉单模态和视觉语言多模态领域来解决各 类相关下游任务. 目前的视觉单模态提示学习方法包括串接可 优化向量序列[18-20],添加像素级可优化扰动[21-23], 学习提示网络层[24-26],面向特定成分的组合提示学 习[27,28],建立标签映射[29-31],任务重构[31],网络结 构搜索[32]等.这些方法适用的下游任务包括数据均 衡视觉分类[18,21,24,31],持续学习[19,33,34],领域泛化、 适应[20,28,35],细粒度目标检索[36],对抗鲁棒学习[23], 语义分割[37],长尾识别[38],开放集学习[39]等. 在视觉语言多模态领域,提示学习方法包括纯 文本提示学习[40-42],视觉信息引导的文本提示学习 [43,44],文本或外部知识引导的文本提示学习[45,46], 文本和视觉联合提示学习[47,48],面向特定成分的组 合提示学习[49,50],基于分布的提示学习[51,52],多任 务共享的提示学习[53],梯度引导的提示学习[54],无 监督提示学习[55],建立颜色与标签关系[56],视觉映 射到语言空间[57]等.这些视觉语言多模态提示学习 方法被应用于各类下游任务,包括数据均衡视觉分 类[40,43,47,51,53],基础到新类别泛化[45,46,48,52],领域泛 化[40,43,48,58],领域适应[59,60],视觉问答[61,62],图片 描述[63,64],图文检索[65],视觉蕴含[61],视觉推理[66], 多标签分类[67],开放集识别[31,68],去偏差提示学习 [69,70],组合零样本学习[71,72],图像分割[73,74]等. 针对自然语言处理领域中的提示学习方法[6,75] 已经有相关综述[76]展开了全面的介绍.而在视觉相 关领域中,目前只有针对预训练技术的综述[77,78], 而缺少视觉领域提示学习方法的综述.为此,本文对 单模态视觉以及多模态视觉语言领域中的提示学 习方法展开全面介绍.

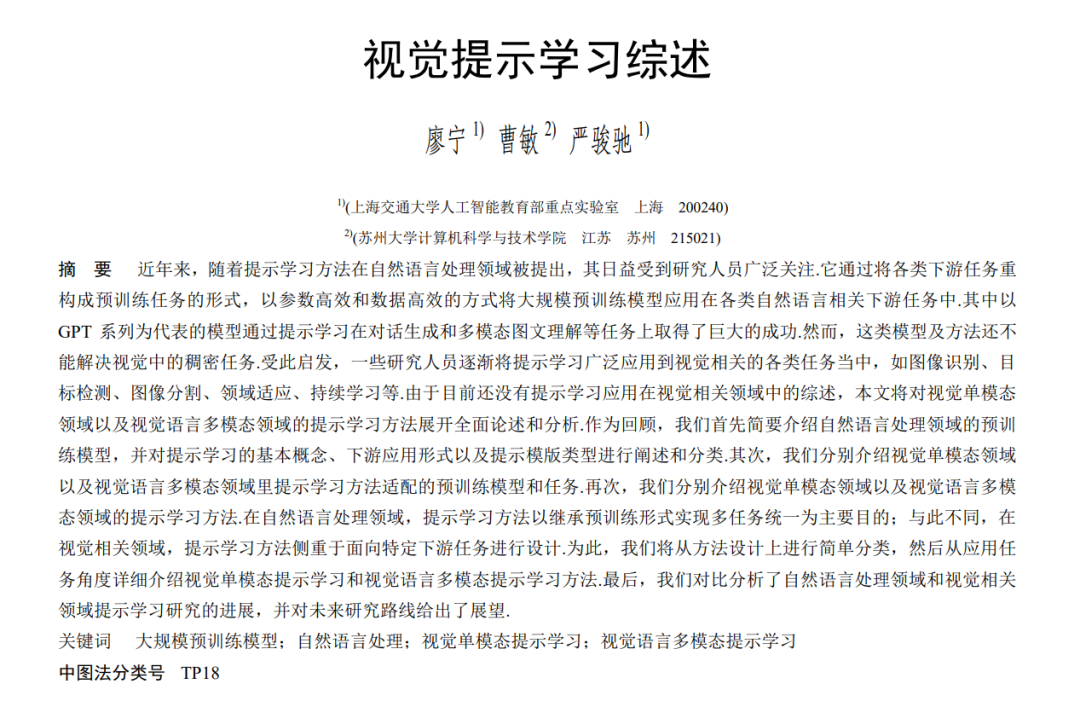

我们将首先介绍自然语言处理领域的预训练 模型和提示学习方法[6,75]的基本概念,并且结合大 规模预训练语言模型的预训练任务简要介绍提示 学习的应用形式和模版类型.其次,我们将分别介绍 视觉单模态与视觉语言多模态领域里的预训练模 型.再次,我们将针对提示学习在各类下游任务上的 广泛应用,分别详细介绍视觉单模态以及视觉语言多模态领域中针对各类应用任务提示学习方法的 设计以及特点的分析.最后,我们给出在未来研究中 视觉和多模态提示学习方法发展的方向,并总结全 文.全文组织结构如图 1 所示.