从理解到改进:序列到序列建模中的编码器特征融合

Understanding and Improving Encoder Layer Fusion in Sequence-to-Sequence Learning

本文由腾讯AI Lab主导,与澳门大学、悉尼大学合作完成。编码器特征融合(EncoderFusion)是提升序列到序列建模中的经典技术之一。尽管其有效性已在各种自然语言处理(NLP)任务上得到的验证,但其原理及规律并没有被深入探究。

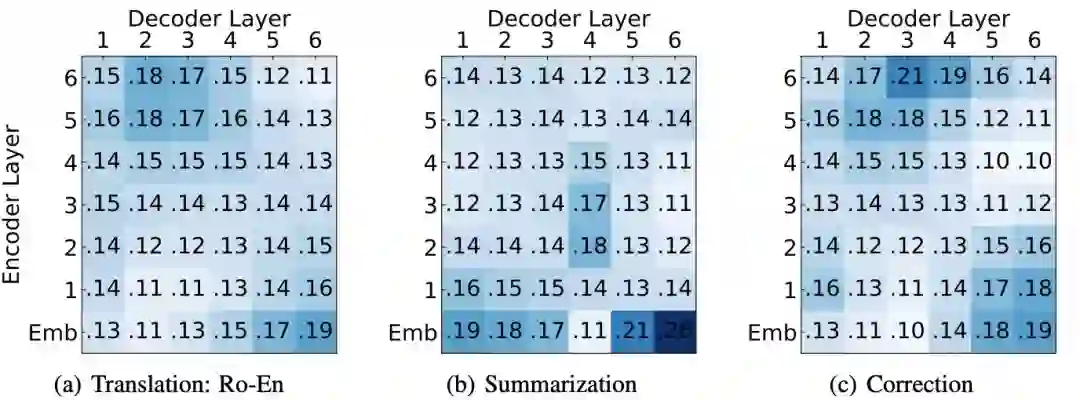

本文首先提出了细粒度层注意力模型来量化编码器每一层特征的贡献度,并在多个NLP任务(机器翻译、语法纠错、文本摘要)上进行分析,从而进一步理解EncoderFusion的本质。前人工作认为EncoderFusion主要利用嵌在编码器底层的词法和语法信息,而我们发现编码器词嵌入层比其他中间层更重要,并且始终受到解码器最上层的关注。基于该发现,我们提出了一种简单直接的融合方法,即只融合编码器词嵌入层到解码器输出层。

实验结果表明,该方法在多种序列建模任务上都优于已有融合方法,并使翻译任务在WMT16罗英和WMT14英法数据集上取得SOTA性能。分析进一步表明,SurfaceFusion能帮助模型学到更具表现力的双语词嵌入。该工作对编码器特征融合的改进和使用有较强启发和指导意义。

成为VIP会员查看完整内容