机器学习(ML)系统的规模正在迅速增长,正在获得新的能力,并越来越多地部署在高风险的环境中。为了满足对安全ML系统日益增长的需求,我首先讨论如何使系统可靠地执行。之后,我将讨论如何使系统的行为符合人类的价值观。最后,我讨论了如何使ML系统更安全的开放问题。

https://www2.eecs.berkeley.edu/Pubs/TechRpts/2022/EECS-2022-133.html

在这篇论文中,我们的目标是帮助塑造将促使强大的人工智能系统的过程,并将过程引导到更安全的方向。我们通过让深度学习系统更安全来做到这一点,因为深度学习的工作可能会转化为未来的系统。我们总结我们的发现并讨论一般的教训。

在第2章中,我们首先展示了上游功能可以提高安全性。特别是,自监督学习和预训练可以改善许多安全指标。我们还表明,在大规模设置的尺度异常检测方法可能存在挑战。然后,我们展示了大规模的NLP模型在许多安全指标上有很高的性能。接下来,我们展示了尽管视觉模型在很多方面都有能力,但它们仍然可以很容易地通过反向策划的例子被打破。在下一节中,我们将展示,即使在稳健性中,我们也可以在不改进一般功能的情况下改进安全度量。最后,PixMix表明,一个方法可以在多个安全指标方面接近帕累托最优。在第三章中,我们展示了模型可以模仿人类对规范性陈述的反应,而不仅仅是描述性陈述。这让我们能够将带有道德知识的模型应用于基于文本的互动游戏中。这些模型过滤了其他主体模型,并阻止主体模型采取道德上不受欢迎的行为。这一切都是在没有提高一般游戏能力的情况下完成的。

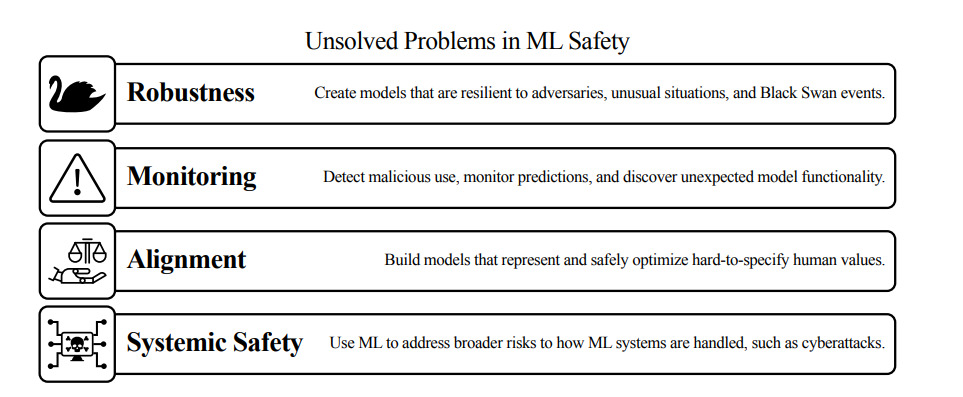

在第4章中,我们整合并完善了在以前的论文中探索的各个方向,为提高安全性提供了一个路线图。本节介绍了“系统安全”,它明确承认社会技术考虑对于提高安全性是必要的。它还将对齐与其他不同的研究目标(如鲁棒性和监控)分离开来。通过提供许多可供研究的问题,希望更多的研究人员能够致力于提高安全性。最后,我们列举了许多使机器学习系统更安全的新方向。这些都是让未来强大的人工智能系统更安全的中间步骤。随着模型的能力越来越强,我们希望研究界能够更直接地研究先进人工智能系统的尾部风险,包括可能永久削弱人类长期潜力的风险。