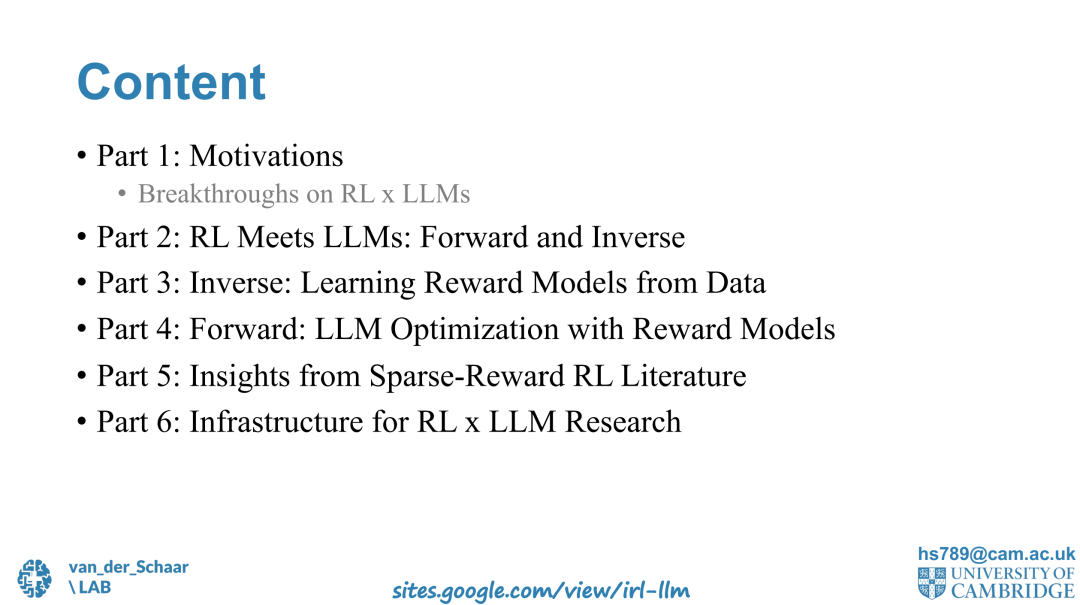

大语言模型(LLM)的对齐问题仍是强化学习领域中最关键的挑战之一。正如 DeepSeek-R1 等模型的成功所展示的那样,提升对齐效果不仅依赖于更优的模型架构,还需对强化学习(RL)和奖励建模有更深入的理解。本教程将探讨逆向强化学习(Inverse Reinforcement Learning, IRL)与大语言模型对齐之间的关联,为研究人员和实践者提供一条结构化的研究路径。 我们将 LLM 对齐建模为一个逆强化学习问题,对比传统强化学习与从人类数据中推断奖励的逆向方法。教程重点聚焦于奖励模型,探讨其如何从不同类型的数据中构建,包括数学推理、二元反馈、偏好数据以及示范行为等。 在理论之外,我们还将探讨基础设施与实践实现,展示如何在几分钟内高效评估基于 IRL 的 LLM 对齐思路。最后,教程将结合稀疏奖励强化学习的相关经验,介绍奖励塑形(reward shaping)、责任归因(credit assignment)以及自对弈(self-play)中获得的启示。 通过本教程,参与者将从理论和实践两个维度深入理解基于 IRL 的大语言模型对齐方法,并掌握高效构建更好对齐模型的核心工具。

成为VIP会员查看完整内容