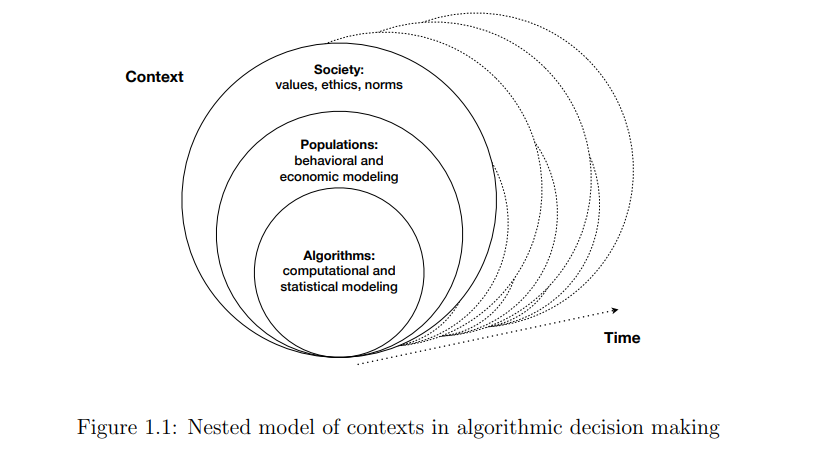

从教育到招聘,社会中的重要决策越来越依赖于数据驱动的算法。然而,算法决策的长期影响在很大程度上没有得到充分理解,在理论和实践中,确保公平利益存在严重挑战。在本文中,我从两个角度考察了机器学习算法的社会动力学:(I)算法决策的长期公平性,以及(ii)匹配市场的长期稳定性。

在计算机科学中,算法公平这个主题受到了广泛的关注,但最近才认识到算法可以通过各种动态机制对种群产生不同的影响。我们通过提出机器学习算法和感兴趣群体的动态交互的两种不同模型来促进这一不断发展的理解。首先,我们引入了延迟影响的概念——决策结果被观察后,决策算法对人口的福利影响,其动机是,例如,在应用新的贷款批准算法后,平均信用分数的变化。我们证明了研究界提出的公平机器学习的几个统计标准,如果应用于决策约束,可能会对弱势群体的福利造成损害。t,我们考虑一个动态的环境,在这个环境中,个人投资于一个基于算法决策规则的预期回报的积极结果。我们表明,不良的长期结果是由于群体间的异质性和缺乏可实现性而产生的,并研究了干预措施的有效性,如按群体“脱钩”决策规则和提供补贴。

除了长期公平的问题,利用机器学习为社会造福面临的另一个挑战是社会选择。在市场中,个人学习目标(通常是构想出来的)可能与实现有效市场结果的长期社会目标相冲突。受在线市场和平台中重复匹配问题的激励,我们研究了双边匹配市场,参与者重复匹配,并通过匹配获得关于其偏好的不完全信息。由于竞争,一个参与者试图了解自己的偏好可能会影响其他参与者的效用。我们为市场平台设计了一种机器学习算法,使市场作为一个整体能够足够有效地学习他们的偏好,从而快速获得称为稳定的市场公平概念。此外,我们研究了上述问题的分散化版本,并设计了参与者的学习算法,以在给定过去数据的情况下战略性地避免竞争,从而消除了对中央平台的需要。我们还研究了具有独立行动诱惑的策略参与者是否仍应遵循算法的建议,结果显示了算法的激励兼容性方面的几个积极结果。

https://www2.eecs.berkeley.edu/Pubs/TechRpts/2022/EECS-2022-41.pdf