摘要

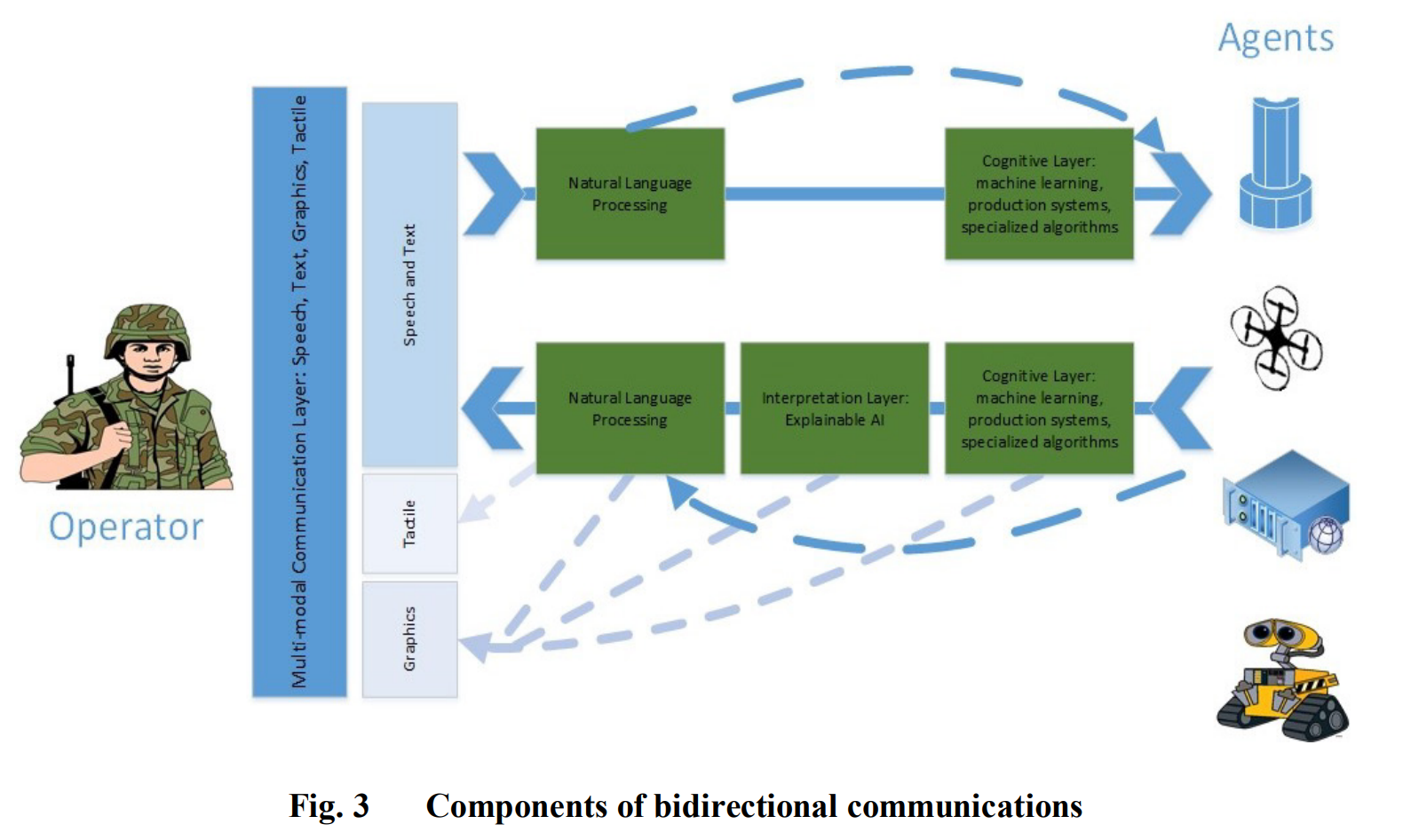

本报告涵盖了与设计评估人类和智能软件Agent之间通信有关的问题,这些通信是实现协作关系所必需的。为了使人与Agent之间的互动在动态的现实世界中保持稳定,软件Agent和人类都必须能够在任务目标方面沟通他们的整体意图。由于推理过程、能力和知识库的不同,人类和Agent并不是人类团队的模拟。我们讨论了有效通信所涉及的技术问题,包括相互透明的模型、自然语言处理(NLP)、人工智能(AI)和可解释的AI。由于缺乏使人类能够洞察其队友心理过程的心智理论,Agent很难预测人类的信息需求和未来行动。涉及多个Agent的协作计划研究和合成共享心智模型的研究被作为尝试将人类和Agent整合成一个协同单位典范。然而,我们的结论是,在人类和Agent在复杂的、不确定的任务中像人类团队一样通信之前,NLP、可解释人工智能和人类科学的进展将是必要的。

1. 引言

自主系统的前景和问题都将改变未来系统的动态,这不仅体现在自主系统对社会的影响上,也体现在它们与人类的互动上(《经济学人》2016;Schaefer等人,2017)。人类和自主系统之间的伙伴关系涉及到将人工和人类融合成一个有凝聚力的系统,这种结合意味着所有的优势和限制(Bradshaw等人,2009;Chen和Barnes,2014)。自主系统的范围可以从那些独立的、只由人类偶尔监控的系统到由人类指导的、受到密切监督的系统(Barnes等人,2017)。能够自主行动并根据新信息更新行动以实现其目标的软件系统被确定为智能Agent(IA);Russell和Norvig 2009)。在人类与IA的合作关系中,人类和IA共享决策空间的混合倡议能力,但人类拥有最终的权力,在危险的时间有限的情况下,允许灵活性,同时保持人类的责任(Chen和Barnes 2015;Barnes等人2017)。在大多数情况下,不可能先验地将每个人分配到动态环境中的特定角色,因为他们的角色可以随着情况的变化而改变。例如,自适应Agent可以在高工作负荷的任务段中掌握决策主动权,而不需要等待操作者的许可,但在正常的操作中会将决策主动权还给操作者(Chen和Barnes 2014)。一些与任务分配有关的规定性规则可以根据任务的优先级预先设定。其他规则可能会根据情况的紧急程度而改变(例如,在时间期限过后自主击落来袭导弹[Barnes等人,2017;Parasuraman等人,2007])。然而,在动态环境中,沟通、对意图的理解和共同的态势感知(SA)是有效协作的必要条件(Barnes等人,2017;Evans等人,2017;Holder,2018;Chen等人,2018)。

随着IA复杂性的增加,有效通信的必要性也随之增加。Cooke(2015)认为,高效的团队合作关系更多的是取决于有效的互动,而不是拥有广泛的共享知识库。除了有一个共同的语言框架,每个团队成员都必须知道什么时候向他们的伙伴推送信息,什么时候要求提供信息。因此,人类和IA不仅要有任务环境的SA,而且要有彼此角色的SA,以便在没有公开交流的情况下回应伙伴的要求(Scherri等人,2003;Chen等人,2018)。我们讨论三个主要的主题。第一个主题是对人-Agent架构的描述,以及为什么它与人-人团队不同,强调相互透明度的重要性。接下来,我们讨论了人类与人工智能(AI)系统通信所涉及的技术问题,包括多模态交互、语言限制、AI的类型以及可解释AI(XAI)的重要性,以确保相互理解。最后,我们讨论了共享意图的重要性,以促进操作者和人工智能之间信息交互的自然节奏。