美国海军和国防部(DOD)正在优先考虑在各战争领域迅速采用人工智能(AI),以保持对美国有利的技术优势。机器学习(ML)是最近人工智能发展的基础,它存在着一个持续的、没有得到充分解决的关键缺陷:对抗性样本。自2013年发现以来,在深度神经网络(DNN)分类器中出现了许多新形式的对抗性样本攻击,并提出了许多狭义和特殊的防御措施。这些防御措施都没有经受住反测试。一些研究人员提出,这种易受攻击性可能是不可避免的。到目前为止,还没有发现有效的、可计算的、通用的方法,可以加固DNN,使其免受这种和相关的泛化问题的影响。我们的前提是,ML模型对所有对抗性样本的鲁棒性与抵抗力,可以通过将模型分类空间数据密集区之间的数据点稀疏的潜在空间,作为障碍隔离来改进。我们研究了两种不同的方法来实现这种对基于对抗性样本的攻击防御,测试这些防御对最有效的攻击,并将结果与现有的技术状态的防御进行比较。

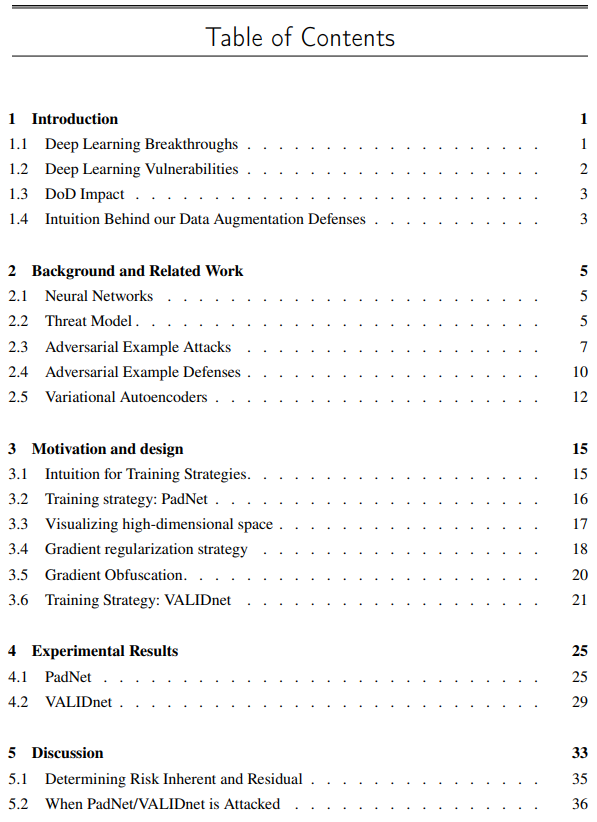

第一章 引言

人工智能(AI)已被提出来作为推进国防部能力的一个关键推动因素。人工智能国家安全委员会在其最终报告中写道:"如果我们的武装部队不加速采用人工智能,他们的军事技术竞争优势可能会在未来十年内丧失",建议 "美国现在必须采取行动,将人工智能系统投入使用,并在人工智能创新方面投入大量资源,以保护其安全,促进其繁荣,并保障民主的未来" [1]。鉴于人工智能或更具体地说,深度神经网络(DNN)中的机器学习(ML)最近在科学和工业领域取得了广泛的突破,这种关注无疑是恰当的。然而,在国防应用中利用ML和其他现代 "深度学习 "方法并非没有其固有的附加风险。

最近的人工智能主张已经近乎夸大其词;当然,在与军事和文职领导层的高层沟通中,也发生了一些夸大其词的情况。作为这种夸张的例子,参考一下《2019年美国总统经济报告》是如何向美国领导人介绍机器视觉方面的人工智能状况的。在第343页题为 "2010-17年人工智能和人类的图像分类错误率 "的图表中,它显示了 "人类分类 "错误率与机器分类错误率将在2015年超过人类图像分类能力。对这一说法仔细考虑并对参考研究甚至是当前最先进研究进行检查,显示这一特殊的发展仍然是一个遥远的、尚未达到的里程碑。

1.1 深度学习的突破

即使ML仍然存在挑战,近年来,机器学习在科学、工业和商业领域的成功应用也在急剧增加。深度神经网络已经在自然语言处理、天文学、癌症诊断、蛋白质折叠、语音识别和机器视觉等不同领域取得了巨大的进步[2]-[8]。因此,这类系统的潜在军事应用同样比比皆是:分析频谱上下的声学和电磁传感器数据、机器视觉、寻找-修复-跟踪和瞄准对手的飞机、地下、水面和陆地战斗人员、人类语言处理、语音识别、自主空中/地面/地下/陆地车辆、信息战、情报、监视和侦察(ISR)整合、机器人技术、网络防御、网络攻击、战术决策辅助,等等。

1.2 深度学习的脆弱性

尽管这项技术带来了巨大进步,但目前的ML分类方法创建的模型在其核心上是有缺陷的,因为它们非常容易受到对抗性样本攻击和相关欺骗技术的影响[9]。广义上讲,文献中定义的这类攻击有三类:探索性攻击、逃避性攻击和中毒性攻击。在本报告中,我们主要关注防御我们认为最关键的需求,即逃避攻击。为了提供背景,我们简要地概述了这三种攻击。探索性攻击,对手并不试图实现错误分类,而是试图通过精心设计输入来获得模型的知识,这些输入的结果将提供关于模型内部状态的信息,其目的是减少模型的不确定性,以支持未来的攻击。中毒攻击试图在训练期间修改模型,以偷偷地完成模型的一些未被发现的行为变化。最后,在逃避攻击中,攻击者不知不觉地修改了人工制定或模型的输入,以产生分类的变化,从良性的或最初设定的类别到一些其他的、欺骗性的不真实的类别[10]。这最后一类是我们防御的重点,从这一点出发,我们把这些简单地称为对抗性样本攻击[11]。

自从2013年最初发现DNN分类器中的对抗性攻击(逃避)以来,已经出现了许多种这样的攻击,并且至少提出了同样多的狭义的特定防御措施作为回应。不幸的是,到目前为止,所提出的防御措施没有一个能经受住反测试和适应性攻击[12]。一些研究人员提出,这种易感性可能是空间中问题表述的一个不可避免的特征[13]。目前,还没有发现一种有效的、计算上可接受的、通用的方法,可以支撑DNN对抗类似的相关的泛化问题[12], [14]。

1.3 国防部(DoD)的影响

在国防部的范围内,大家都承认欺骗在战争中起着核心作用。因此,战争系统必须被设计成对欺骗有高度的适应性[15]。马基雅弗利在“Prince”中写道:"......虽然在任何行动中使用欺骗都是可憎的,但在发动战争时,它是值得称赞的,并能带来名声:用欺骗征服敌人与用武力征服敌人一样受到称赞。" 对孙子来说,这甚至是更重要的因素,"所有的战争都是基于欺骗"。在国防应用中,至关重要的是,不仅系统在战斗开始时就如设计之处那样工作,而且它们应该具备有弹性对狡猾的、有同样资源和动机的对手的潜在计划。

诚然,ML在民用和科学方面已经取得了巨大的成功。尽管民用工业技术领域与军事技术需求有很大的内在交集,但应该注意到,后者并不是前者的完美子集。也就是说,战争的现实要求其技术必须为虚假信息和故意欺骗的行动、展示和通信做好准备。这两个领域之间的这些不同假设意味着,在一个领域已经准备好的东西,在另一个领域可能还没有准备好。在整个国防部,纳入这些技术的系统正在被考虑、开发,在某些情况下已经被采用,目的是增强或取代我们一些最关键的国家安全能力。在军事应用中,特别是武器系统和杀伤链内的系统,必须消除或至少减少对抗样本,并对其进行补偿,使故障呈现最小的风险。其余的风险必须被明确指出、发现并被作战人员充分理解。不仔细和充分地解决这个问题是不可想象的,否则我们就有可能采用脆弱性技术,将灾难性的漏洞引入我们关键战争系统。

1.4 增强防御措施

在防御基于机器学习技术的系统不受欺骗的潜在战略背景下,我们介绍了一种防御措施。我们的前提是,ML模型对所有对抗性样本的鲁棒性与抵抗力,可以在模型分类器的分类空间数据密集区之间的数据点稀疏潜在空间中插入一个 "填充 "或 "屏障 "的方法来提高[13], [16]。我们相信,通过统计学插值或采用变分自动编码器(VAE)[17]或生成对抗网络(GAN)[18]来插值和投射到这个空间的模型可以创建人工填充类样本来增加数据集,所产生的模型将能够成功地区分合法数据点和对抗性样本,同时保持与最先进分类方法相称的准确性。