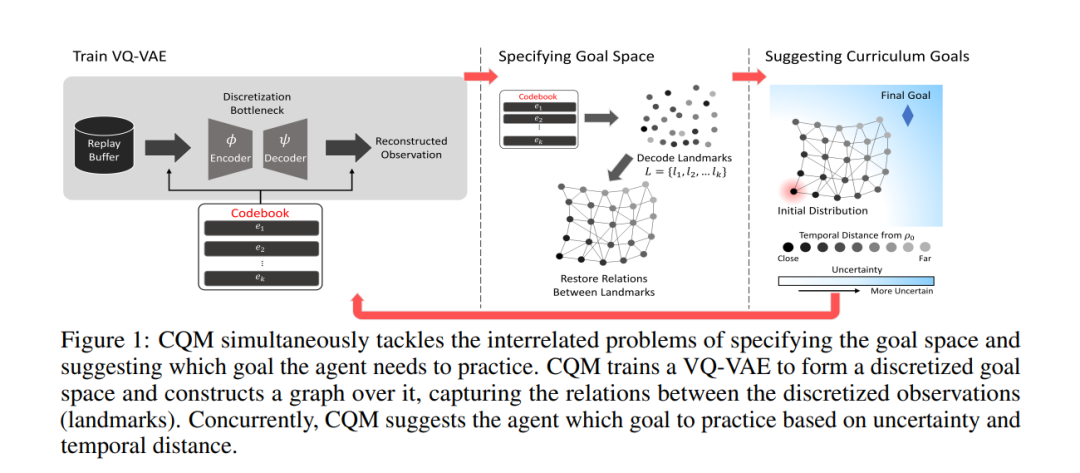

近期的课程强化学习(RL)在通过提出替代任务序列来解决复杂任务方面取得了显著进展。然而,之前的方法在生成高维空间的课程目标时常常面临挑战。因此,它们通常依赖手动指定的目标空间。为了缓解这一限制并提高课程的可扩展性,我们提出了一种新的课程方法,该方法自动定义包含课程过程的关键信息的语义目标空间,并在其上建议课程目标。为了定义语义目标空间,我们的方法通过向量量化变分自动编码器(VQ-VAE)离散化连续观测,并通过图形恢复离散化观测之间的时间关系。同时,我们建议的方法考虑到不确定性和时间距离,使课程目标收敛于自动组合的目标空间上的最终目标。我们证明了所提出的方法允许在只有原始目标示例的无信息环境中进行有效的探索。此外,我们的方法在数据效率和性能方面超越了最先进的课程RL方法,即使在以自我为中心的视觉输入的各种目标达到任务中也是如此。

https://www.zhuanzhi.ai/paper/467e84cf445bb34edb7c3f138a168c58

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日