如何保证深度学习算法的安全性和可靠性?DeepMind的研究科学家David Stutz的博士论文《Understanding and improving robustness and uncertainty estimation in deep learning》系统性阐述了如何提升深度学习鲁棒性和不确定性,非常值得关注!

David Stutz,DeepMind的一名研究科学家,对鲁棒和安全的深度学习感兴趣。在此之前,我是马克斯普朗克信息学研究所的博士生,导师是Bernt Schiele和Matthias Hein。2021年,我在DeepMind实习,与Taylan Cemgil、Krishnamurthy (Dj) Dvijotham和Arnaud Doucet共事。在攻读博士期间,我还与IBM T. J.沃森研究中心的Nandhini Chandramoorthy合作,并在PhdNet调研小组担任志愿者。

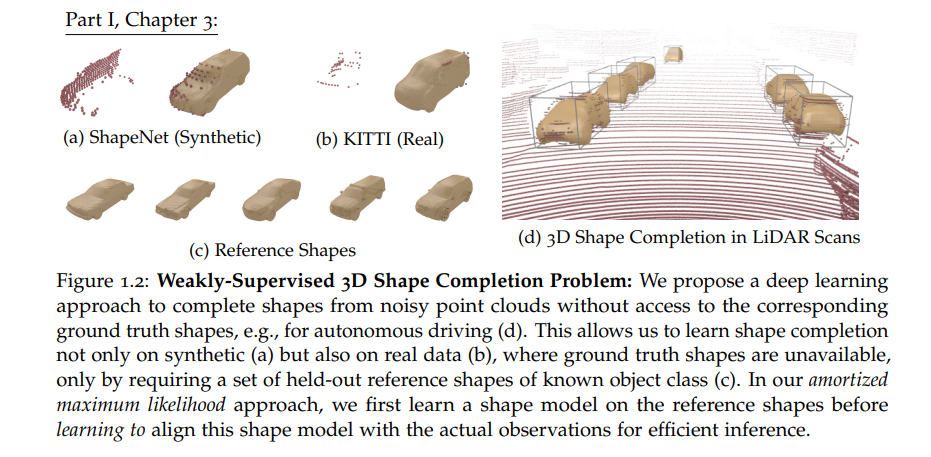

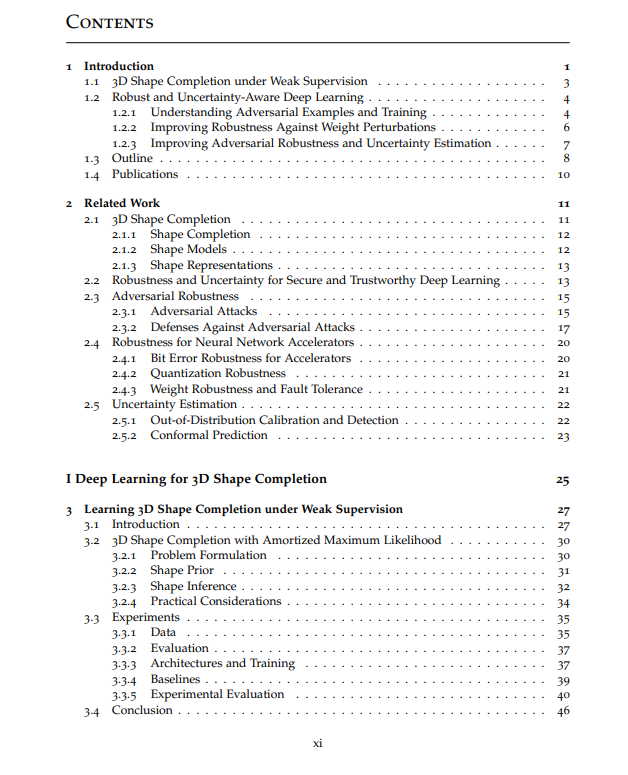

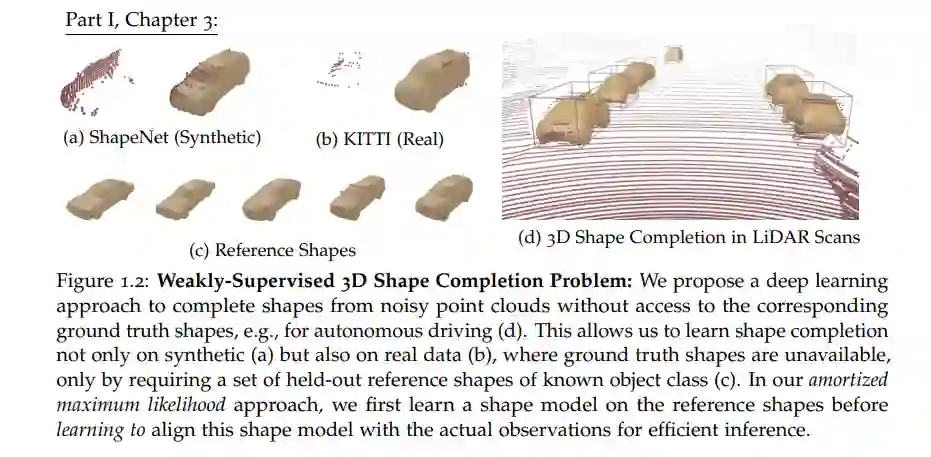

在自动驾驶或医疗诊断等高风险应用领域,深度学习正变得越来越重要。在这些领域,错误的决策可能会对人类生活产生巨大影响。不幸的是,深度神经网络通常仅基于泛化进行评估,例如,在固定测试集上的准确性。然而,对于安全部署来说,这显然是不够的,因为潜在的恶意行为者和分布转移或量化和不可靠硬件的影响被忽略了。因此,最近的工作额外评估了可能被操纵或损坏的输入的性能,以及量化和部署到专门的硬件之后的性能。在这种情况下,获得模型置信度的合理估计及其预测也很重要。本文沿着三个主要方向研究深度学习中的鲁棒性和不确定性估计: 首先,我们考虑所谓的对抗例子,轻微扰动的输入会导致准确度的严重下降。其次,我们研究了权值扰动,特别关注量化权值中的误码率。这与在特殊用途的硬件上部署模型进行高效推断(所谓的加速器)有关。最后,我们解决了不确定性估计,以提高鲁棒性,并为安全部署提供有意义的统计性能保证。详细地,我们研究了关于底层数据流形的对抗例的存在性。在此背景下,我们还研究了对抗性训练,通过使用对抗性例子来增强训练,以降低准确性为代价,从而提高鲁棒性。我们表明,常规对抗例子使数据流形在一个几乎正交的方向上。虽然我们发现鲁棒性和准确性之间没有内在的权衡,但这导致了较高的样本复杂性以及对抗训练的严重过拟合。我们还使用了一种新的针对权重变化的鲁棒损失景观的平整度度量,表明鲁棒过拟合是由收敛到特别尖锐的极小值引起的。事实上,我们发现平坦度与良好的鲁棒泛化之间有明显的相关性。进一步,我们研究了量化权值中的随机和对抗性误码。在加速器中,为了提高能源效率而降低电压时,内存中会发生随机误码。在这里,我们考虑了一种鲁棒量化方案,使用权值裁剪作为正则化,并执行随机误码率训练来提高误码率的鲁棒性,在不需要更改硬件的情况下可以节省大量的能源。相反,通过对内存的基于硬件或软件的攻击,恶意引入对抗性误码,对性能造成严重后果。本文提出一种新的对抗性比特错误攻击来研究这种威胁,并使用对抗性比特错误训练来提高鲁棒性,从而提高加速器的安全性。最后,我们在不确定性估计的背景下看待鲁棒性。通过鼓励对抗性样本的低置信度预测,所提出的置信度校准的对抗性训练在测试时成功地拒绝了对抗性的、损坏的以及分布外的样本。因此,与常规对抗训练相比,我们也能够改善鲁棒性-准确性权衡。然而,即使是健壮的模型也不能为安全部署提供任何保证。为了解决这个问题,共形预测允许模型在用户指定的保证下预测置信集,包括真实标签。不幸的是,由于保形预测通常是在训练后应用的,所以在训练模型时没有考虑到这个校准步骤。为了解决这个限制,我们提出了保角训练,它允许训练端到端与底层模型的保角预测器。这不仅提高了获得的不确定性估计,而且还可以在不失去提供的保证的情况下优化特定于应用的目标。除了鲁棒性或不确定性方面的工作外,我们还解决了部分观测点云的3D形状完成问题。具体来说,我们考虑在自动驾驶或机器人环境中,车辆通常配备激光雷达或深度传感器,获得环境的完整3D表示是至关重要的。然而,对于应用深度学习技术来说至关重要的基本真理形状是极其难以获得的。因此,我们提出了一种弱监督方法,可以在不完全点云上进行训练,同时提供有效的推理。总之,这篇论文有助于我们理解对输入和权重扰动的鲁棒性。为此,我们还开发了一些方法来提高鲁棒性和不确定性估计,以便在高风险应用中安全部署深度学习方法。在自动驾驶的特定背景下,我们还解决了稀疏点云的三维形状补全问题。

引言****深度学习越来越多地应用于高风险应用中。

例如,在自动驾驶中,不仅会检测到其他交通参与者,还会估计他们的大小和位置,以便在复杂的情况下安全导航[JGBG20]。这些组件通常利用深度学习的最新进展,从相机或激光雷达传感器进行3D检测和重建[GLU12]。在医学成像或诊断[GvGS16, GPC+16, LKB+17, KGC+18]中,深度学习被用于提供或帮助诊断和选择适当的治疗方法,从轻微疾病的简单治疗到严重疾病(如癌症)的潜在侵入性治疗。在这种情况下,错误的决定会对人类的生活产生巨大的影响。这激发了最近评估的转变,从单纯看泛化,例如图像分类测试集的准确性,到额外理解潜在的恶意或损坏的输入的性能。例如,模型在有噪声的输入时如何执行,或者在面对意图误导它的恶意参与者时如何执行?此外,在能源消耗、空间和成本受到限制的特殊硬件上部署后,保持性能变得越来越重要。例如,在量化和部署到硬件加速器上之后,准确性是否仍然保持,即使在面临硬件故障时?这些问题导致除了简单的准确性之外,还要评估模型在各种情况下的鲁棒性。此外,这促使在预测本身的同时估计不确定性。例如,该模型是否对错误的预测或之前未见的、可能不合逻辑的输入赋予了高置信度?自动驾驶汽车不能因为街道标志上意外的贴纸或涂鸦而发生故障,需要在适当的不确定性下估计交通参与者的未来轨迹[BFS18]。同样,过度自信在医学诊断中已经是一个严重的问题[BG08],对人口迁移或成像噪声的鲁棒性是必要的。总之,在部署之前研究不可预见和对抗环境下的鲁棒性和不确定性,对于用户和从业者将信任发展为深度学习模型至关重要。本文重点研究深度神经网络对输入及其参数变化的鲁棒性,并提供适当的不确定性估计。首先,我们关注所谓的对抗性例子[BCM+13, SZS+14],即导致错误分类的难以察觉的扰动输入。然而,我们也考虑分布偏移,包括随机破坏(如噪声、模糊等)[HD19]以及与手头问题完全无关的分布外的例子。对这些扰动的鲁棒性通常会导致破坏性的精度下降,这是值得信任的深度学习的关键前提[Var19, HKR+20]。其次,我们考虑误码率对网络权值的影响。这与在特殊用途的硬件(所谓的加速器[SCYE17])上部署量化网络进行低成本推断高度相关。例如,数字加速器的低能量运行会导致其存储器的误码率很高,直接影响存储的网络权值。此外,内存容易受到基于硬件或软件的攻击。最后,我们研究了如何在预测的同时提供有意义的不确定性估计。例如,深度神经网络倾向于对错误决策赋以高置信度,例如,在受扰动或分布失衡的例子上。此外,大多数深度学习技术不能提供任何保证,除了经验测试的准确性。然而,除了鲁棒性,良好校准的不确定性估计和相关保证对安全部署至关重要。总的来说,我们的目标是量化、理解和改进在这些情况下的鲁棒性以及不确定性估计。

在本文的初始阶段,除了主要关注鲁棒性之外,我们还研究了自动驾驶中的三维重建问题。为了对路径规划或测绘定位等关键组件获得对周围环境的完整理解和表示[JGBG20],自动驾驶汽车通常配备360度激光雷达传感器[GLU12]。然而,由于点云观测稀疏且噪声大,检测并完成汽车等相关交通参与者的三维形状非常困难。不幸的是,在这种情况下,深度学习技术难以获得难以获得的基本真理形状。我们的目标是使用弱监督的方法来解决这个问题的3D形状完成。图1.1提供了本文所处理问题的高层概述。具体来说,在第一部分中,我们提出了一种弱监督的、基于学习的方法来处理稀疏点云中的3D形状补全。接下来,在第二部分中,我们转向对抗例子的鲁棒性,旨在理解为什么对抗例子存在,以及如何有效地训练对抗鲁棒性和精确模型。在第三部分中,我们转向研究量化网络中的误码,并展示鲁棒性如何有助于节能和安全的加速器。最后,在第四部分中,研究了适当的不确定性估计如何允许拒绝广泛的对抗性、损坏或分布外的示例,以及如何在这些不确定性估计之外获得保证。本文贡献本文共分为九章,共分四部分:第二章,相关工作: 回顾与本文讨论的主题直接相关的以往工作。这些包括,例如,一般的安全深度学习和对抗鲁棒性,以及具体的不确定性估计。此外,我们还讨论了加速器和量化的鲁棒性相关工作以及保形预测的最新工作。第三章,在弱监督下学习3D形状补全: 我们提出了一种高效、弱监督和基于学习的3D形状补全方法。具体来说,我们使用深度神经网络来学习强大的形状先验,随后用平摊最大似然方法完成。我们的方法可以在真实世界的数据集上进行训练,因为除了目标类别之外,不需要任何监督。

第二部分,理解对抗样本和训练

第四章,解纠缠对抗鲁棒性和泛化:我们研究了基础数据流形中的对抗例子,表明它们离开了流形。我们还得出结论,对抗鲁棒性与准确性并不固有冲突,但对抗训练表现出更高的样本复杂性。此外,在训练过程中可以使用上流形对抗实例来提高准确性。

第五章,将对抗鲁棒泛化与平坦极小值联系起来: 在本章中,我们打算了解不同变体的对抗训练如何提高鲁棒性并避免鲁棒过拟合。为此,我们将鲁棒泛化与鲁棒损失面w.r.t.权重变化中的平坦极小值联系起来。

第三部分,提高权重鲁棒性

第六章,随机和对抗性误码率鲁棒性:本章展示了量化深度神经网络的误码率鲁棒性如何提高硬件加速器的能效和安全性。我们使用鲁棒量化、权值裁剪和随机或对抗性误码训练来提高鲁棒性。为此,我们还提出了一种高效有效的对抗性误码攻击。

第四部分,改进对抗鲁棒性和不确定性估计

第七章,信心校准的对抗训练:我们提出了信心校准的对抗训练,它使模型偏向于对对抗例子的低信心预测。通过拒绝低置信度的例子,对抗鲁棒性可以推广到不可见的威胁模型、损坏的例子和分布外的例子。与标准对抗训练相比,这也提高了准确性。

第八章学习最优保形分类器:本文提出保形训练,一种端到端的训练模型和保形预测器的方法,以最小化不确定性,并优化直接在置信集上定义的任意特定应用的损失。训练后的重新校准保留了保形预测器的统计保证。

第九章,结论:总结了本文的主要研究成果,并对未来的研究方向进行了展望。