近年来,RL的显著成就使其在人工智能研究的前沿占有一席之地。最关键的是,这些结果大多是在模拟环境中获得的,在模拟环境中,不良行为不会产生有害后果。然而,为了释放RL的全部潜力,我们希望在现实世界中部署它。虽然这扩大了RL有益影响的范围,但也放大了其有害行为的后果。因此,我们必须理解和解决可能导致RL智能体在现实世界中做出潜在破坏性决策的原因。

https://www.research-collection.ethz.ch/handle/20.500.11850/540581

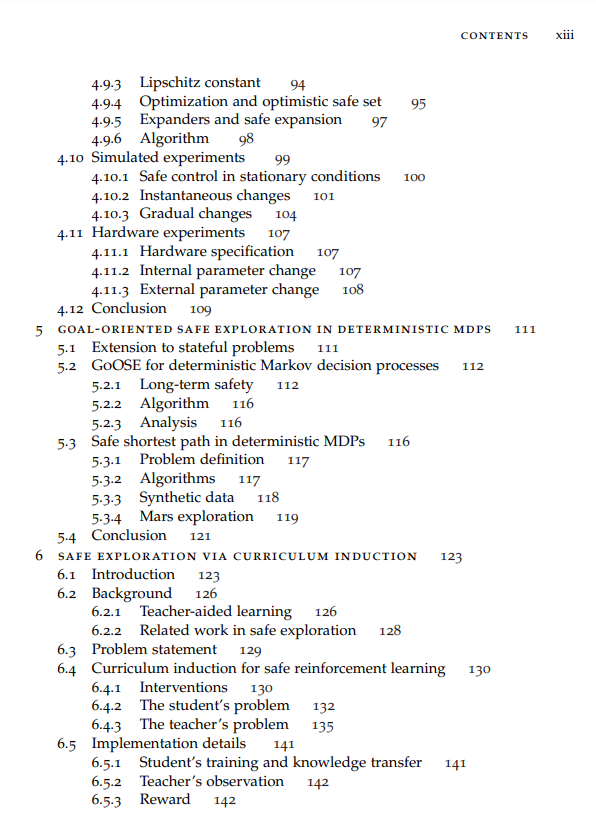

本文研究了小数据环境下由不准确的模型可能导致的RL不安全行为。特别地,它关注的是对分布偏移的鲁棒性问题。不过度拟合训练数据,而泛化到以前未见过的环境条件,以及安全探索,即。,在训练过程中安全获取数据。

我们首先从线性控制理论引入鲁棒性指标的无模型近似。我们利用我们的方法为Furuta摆设计控制策略,并在模拟到现实和硬件实验中演示了它们的鲁棒性,其中包括一个显著的分布位移。

在此基础上,研究了将安全表示为一组未知光滑约束的目标导向安全勘探问题。针对这一问题,我们提出了一种保证安全性和完整性的算法,并在模拟实验中表明,该算法在样本效率方面较现有方法有明显提高。然后,我们将其扩展到自适应控制问题,一类与外生变量引起的分布位移有关的经典控制问题。我们部署我们的算法来控制旋转轴驱动器在不断变化的环境。 最后,我们提出了一个新的框架,将先验知识融入到安全勘探问题中,使我们可以解除以前的方法所做的许多假设,如平滑性。为该框架提供了安全保证,并将其与深度强化学习智能体相结合,以在具有挑战性的环境中安全地训练控制策略。

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

Arxiv

0+阅读 · 2022年12月8日

Arxiv

0+阅读 · 2022年12月7日

Arxiv

0+阅读 · 2022年12月7日