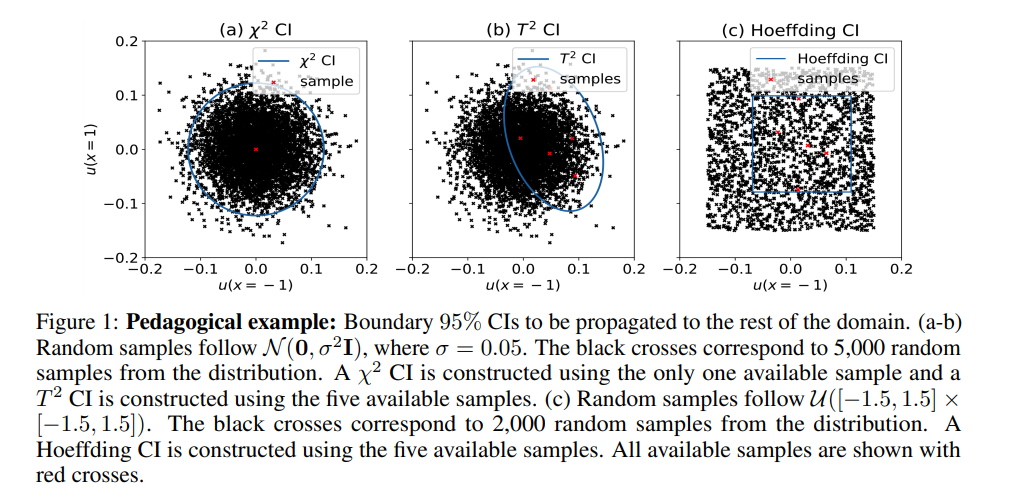

标准的深度学习和物理启示学习的不确定性量化方法持续存在局限性。例如,需要对数据似然性做出强假设,性能高度依赖先验选择,而后验只能近似采样,由于相关的计算成本,导致了差的近似。本文介绍并研究了作为一个新问题的确定性偏微分方程的置信区间(CI)估计。即,以概率保证的形式,从数据位置将置信度传播到整个域。我们提出了一种方法,称为物理启示置信传播(PICProp),基于双层优化来计算有效的CI,无需做出重大假设。我们提供了关于我们方法有效性的定理,以及计算实验,重点是物理启示学习。代码可在 https://github.com/ShenQianli/PICProp 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年11月29日

Arxiv

0+阅读 · 2023年11月28日

Arxiv

0+阅读 · 2023年11月28日