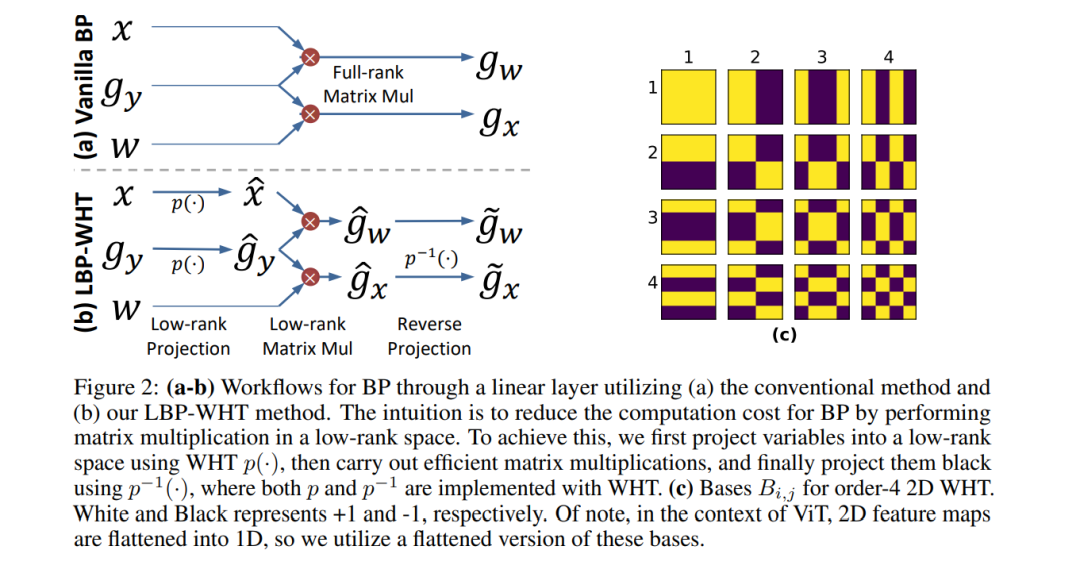

视觉变换器(ViT)的不断扩展使得这些大型模型的高效微调用于满足特定需求在各种应用中变得极为困难。这个问题起源于ViT中线性层的反向传播过程中所需的计算密集的矩阵乘法。在本文中,我们通过提出一种新的低秩反向传播通过沃尔什-哈达玛变换(LBP-WHT)方法来解决这个问题。直观地说,LBP-WHT将梯度投影到一个低秩空间并执行反向传播。这种方法大大减少了适应ViT所需的计算,因为在低秩空间中的矩阵乘法远少资源密集。我们对多个数据集中的不同模型(ViT,混合卷积-ViT模型)进行了广泛的实验,以展示我们方法的有效性。例如,在CIFAR100上调整一个EfficientFormer-L1模型时,我们的LBP-WHT比最先进的基线高出10.4%的准确性,同时需要较少的9 MFLOPs计算。作为第一个使用低秩反向传播加速ViT适应的工作,我们的LBP-WHT方法与许多先前的努力相辅相成,可以与它们结合以获得更好的性能。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日