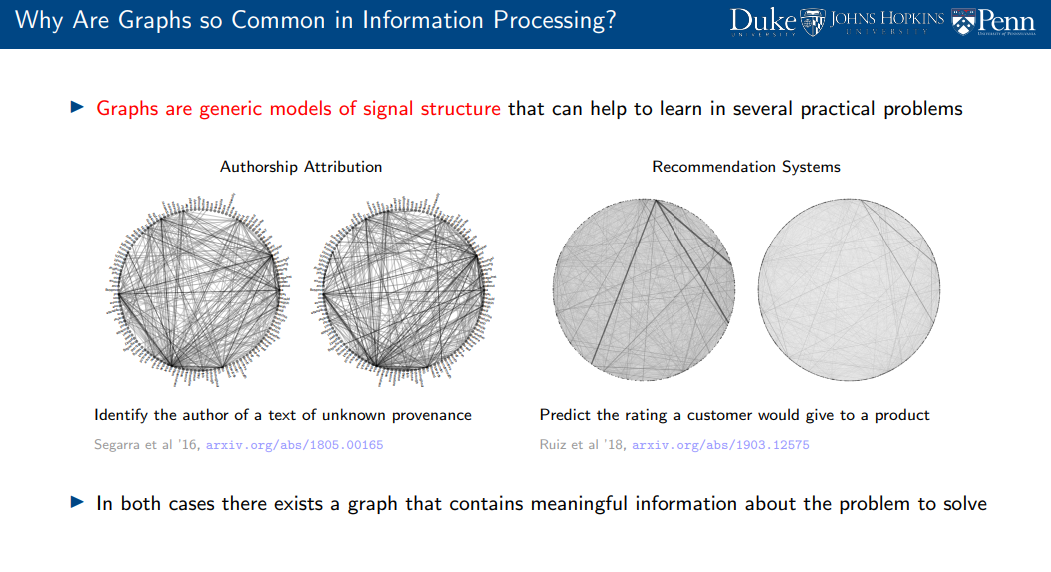

我们首先介绍如何在不同应用场景中使用图(Graph)来表示成对相似性(Pairwise Similarities)。这些场景的共同特征在于,图的节点上携带数据,这些数据可用于信息提取。为了学习从数据到信息的映射,我们可以在**图结构数据(Graph-Structured Data)上构建经验风险最小化(Empirical Risk Minimization, ERM)问题。而图神经网络(Graph Neural Networks, GNNs)**正是这些学习问题(尤其是ERM问题)的一种参数化表示(Parameterization),以此实现目标。

图卷积(Graph Convolution)与图感知机(Graph Perceptron)

接着,我们引入图卷积(Graph Convolution)的定义,即在图的矩阵表示(Matrix Representation)上构造的一个多项式(Polynomial)。基于这一定义,我们通过在图卷积滤波器(Graph Convolutional Filter)的输出上添加逐点非线性函数(Pointwise Nonlinear Function)来构建图感知机(Graph Perceptron)。 图感知机可以进行堆叠(Composition 或 Layering),从而构建多层图神经网络(Multilayer GNN)。此外,为了构建多特征GNN(Multiple-Feature GNN),单层GNN中的单个滤波器(Single Filter)可以扩展为滤波器组(Filter Banks),从而提高其对多维特征的建模能力。

对图置换的不变性(Equivariance)与GNN的稳定性

随后,我们研究GNN对图置换(Graph Permutations)的等变性(Equivariance)。这一性质意味着,在图中,具有相似邻居集(Neighbor Sets)和观测数据的节点将执行相同的运算。正是由于这一特性,图滤波器(Graph Filters)优于传统的线性变换(Linear Transforms),而GNN的表现也优于全连接神经网络(Fully-Connected Neural Networks, FCNNs)。 最后,我们讨论GNN的**稳定性(Stability)**性质,分析其在不同图结构下的鲁棒性表现,以进一步理解GNN的泛化能力和适用范围。