AI巨头Yann LeCun9.29在德国的一个演讲。题目“从机器学习到自主智能”。机器如何能够像人类和动物一样高效地学习?机器如何能够学会推理和规划?机器如何能够学习感知和动作计划的多层次抽象表示,使它们能够在多个时间尺度上进行推理、预测和规划?

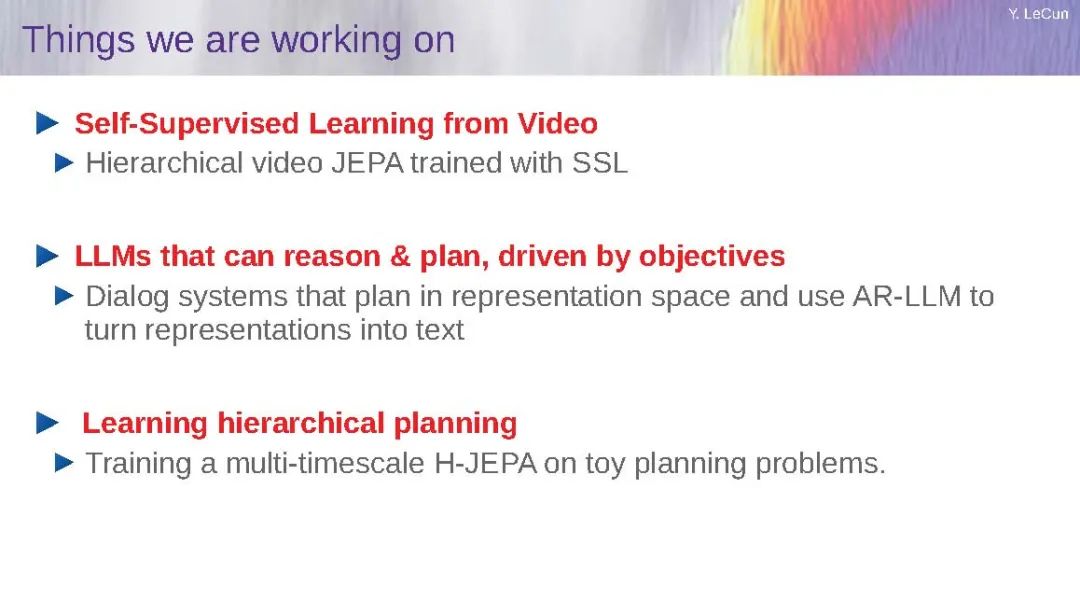

Yann LeCun 教授博士,Meta AI Research首席人工智能科学家以及纽约大学Courant数学科学研究所的Silver教授将提出一种基于新的模块化认知架构和相对新型的自监督训练范式的自主智能代理的可能路径。所提议的架构的核心是一个可配置的预测世界模型,允许代理计划。行为和学习由一组可微分的内在成本函数驱动。世界模型使用一种称为H-JEPA(分层联合嵌入预测架构)的新型能量基模型架构。H-JEPA学习的世界的层次化抽象表示同时是最具信息量和最可预测的。

作者简介:

**Yann LeCun|2018年图灵奖得主、卷积神经网络之父、Meta首席人工智能科学家 **

Yann LeCun,自称中文名“杨立昆”,计算机科学家,被誉为“卷积网络之父”,为卷积神经网络(CNN,Convolutional Neural Networks)和图像识别领域做出了重要贡献,以手写字体识别、图像压缩和人工智能硬件等主题发表过 190 多份论文,研发了很多关于深度学习的项目,并且拥有14项相关的美国专利。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术,同Léon Bottou一起开发了一种开源的Lush语言,比Matlab功能还要强大,并且也是一位Lisp高手。(Backpropagation,简称BP)反向传播这种现阶段常用来训练人工神经网络的算法,就是 LeCun 和其老师“神经网络之父”Geoffrey Hinton 等科学家于 20 世纪 80 年代中期提出的,而后 LeCun 在贝尔实验室将 BP 应用于卷积神经网络中,并将其实用化,推广到各种图像相关任务中。

LeCun教授现任Meta的首席人工智能科学家,并担任纽约大学计算机科学银教授。他在巴黎取得计算机科学博士学位后移居到美国,进入知名的AT&T贝尔实验室并成为图像处理研究部的负责人。之后,他于2003年加入纽约大学,2012年又被任命为纽约大学数据科学中心的创始主任。

LeCun教授在卷积神经网络的发展上有着杰出的贡献。这种技术基本上解决了图像科学和计算机视觉领域的许多难题。特别值得一提的是,一个特殊的卷积神经网络结构名为LeNet,这一名字在某种程度上也代表了我们今天所看到的深度学习和AI的显著发展。他的这些突出贡献使他荣获众多奖项。其中,他是美国国家科学院和国家工程院的成员,并获得了诸如来自EPFL的荣誉学位、IEEE神经网络先锋奖和2019年的图灵奖等众多荣誉,这个奖项通常被誉为计算机界的诺贝尔奖。仅仅几周前,《时代》杂志将他评选为全球AI领域100名最具影响力的人物之一。

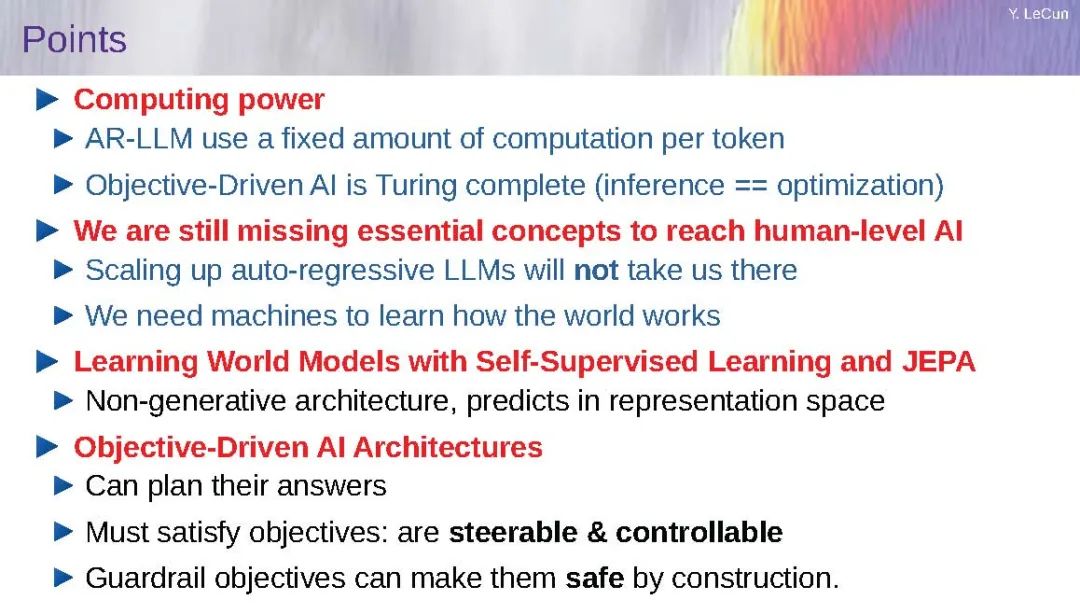

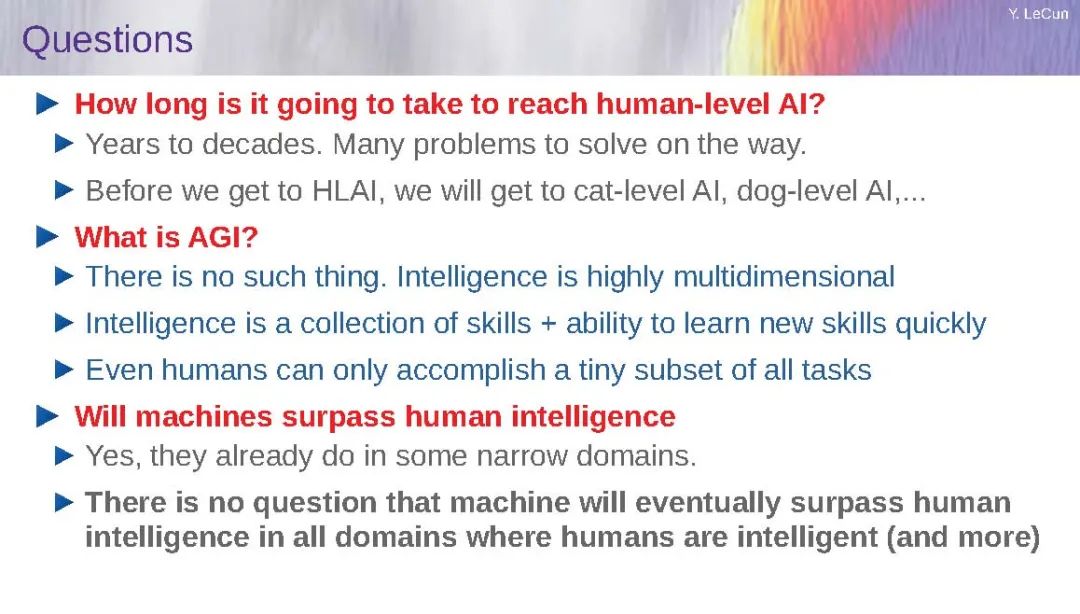

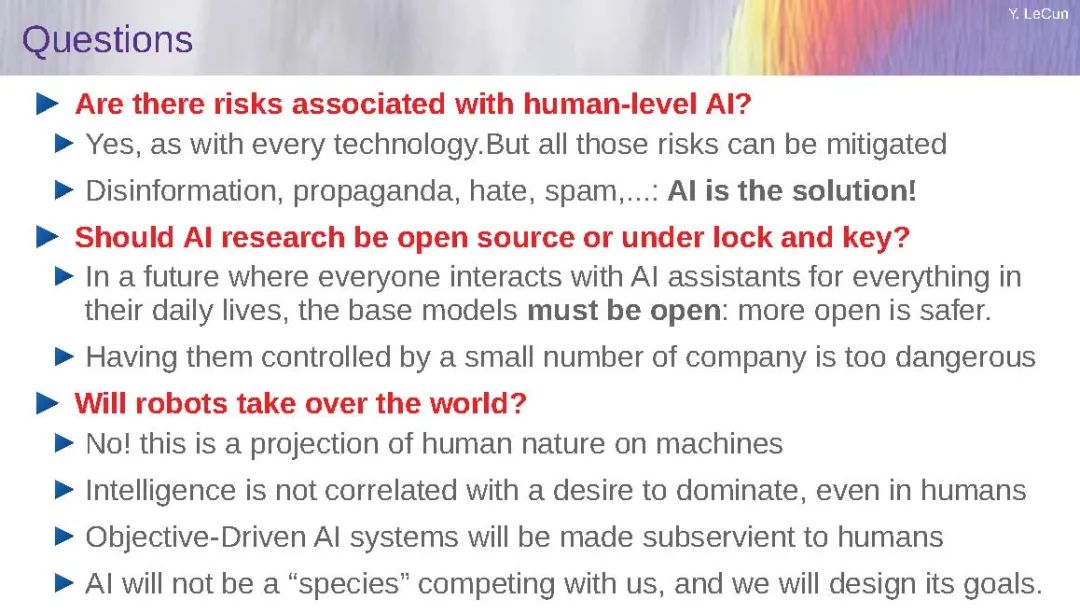

最后结论