【Manning主讲】斯坦福CS224n深度学习与NLP课程全部视频、PPT

1 新智元编译

来源:cs224n.stanford.edu

编辑:刘小芹

【新智元导读】斯坦福大学CS224n(全称:深度学习与自然语言处理)是自然语言处理领域很受欢迎的课程,由 Chris Manning 和 Richard Socher 主讲。本课程所有教学视频和课程材料同样在网上开放可得,新智元带来每课内容简介。

全部课程视频(英文字幕):http://t.cn/R6RGxtR

所有课程资料、PPT等:http://web.stanford.edu/class/cs224n/

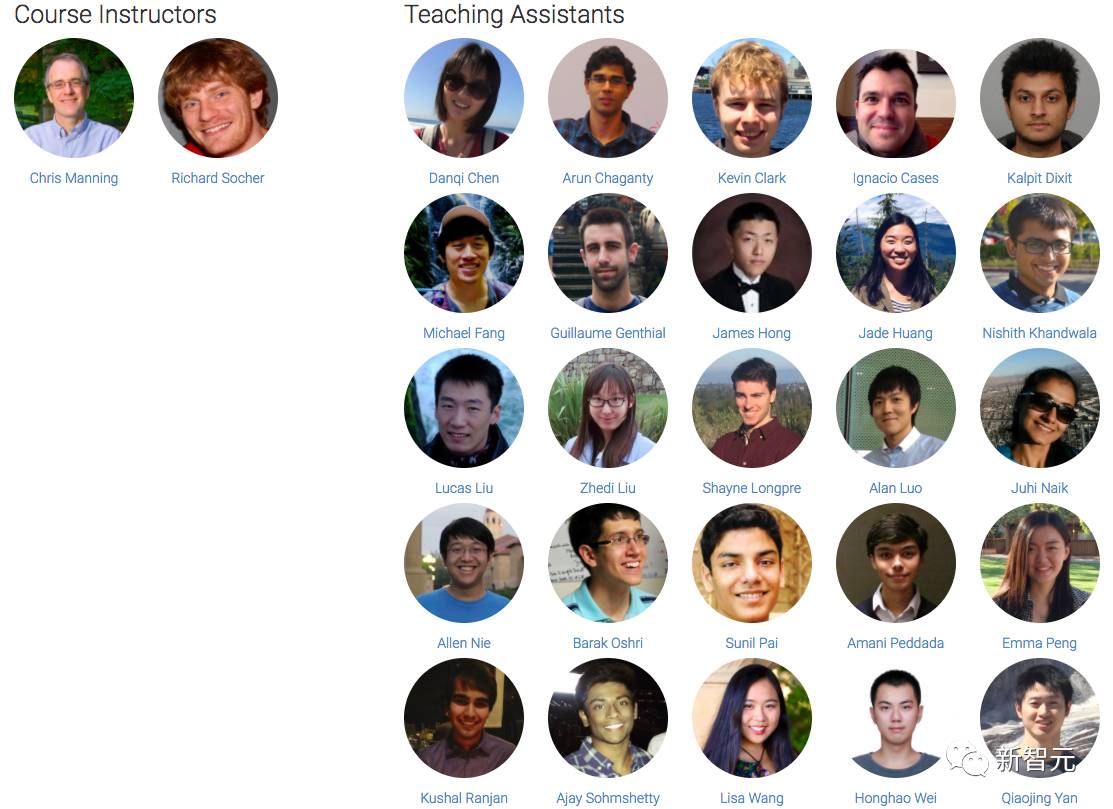

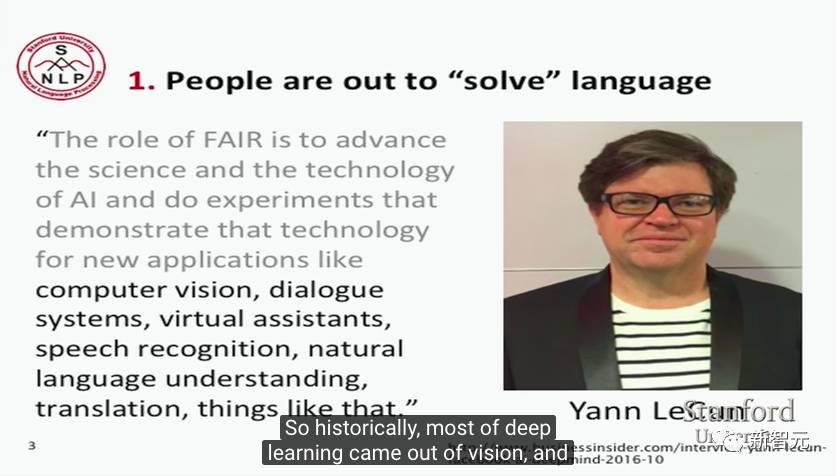

讲师和助教团队

自然语言处理(NLP)是信息时代最重要的技术之一,理解复杂的人类话语也是人工智能的重要任务。NLP的应用无处不在,因为人们的日常生活大部分都需要语言交流,例如网页搜索、广告、电子邮件、客户服务、语言翻译,电台广播等。为NLP的应用赋能的有大量广泛的底层任务和机器学习模型。最近,深度学习的方法在许多NLP任务中获得了非常好的性能。这些模型通常可以通过单个端到端的模型进行训练,并且不需要传统的任务特定的特征工程。

在今年春季的NLP课程中,我们将学习实现,训练,调试,可视化和创建自己的神经网络模型。这门课程为深入学习NLP应用的前沿研究提供了深入的探索。课程最后的项目将涉及训练复杂的循环神经网络并将其应用于大型NLP问题。在模型方面,我们将涵盖词向量表示,基于窗口的神经网络,循环神经网络,长短期记忆模型,递归神经网络,卷积神经网络以及一些涉及 memory component 的非常新的模型。通过讲座和编程任务,学生将学会令神经网络在实际问题上工作的必要工程技巧。

熟悉 Python 编程语言

大学微积分,线性代数(例如MATH 19或41,MATH 51)

基本概率和统计知识(例如 CS109 或其他统计课程)

CS229(机器学习)的同等知识

推荐掌握

自然语言处理的相关知识(CS224N 或 CS224U)

凸优化

卷积神经网络知识(CS231n)

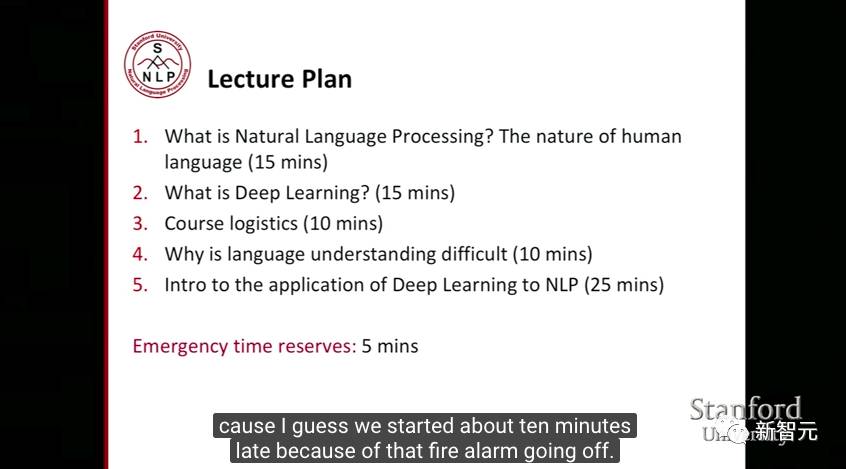

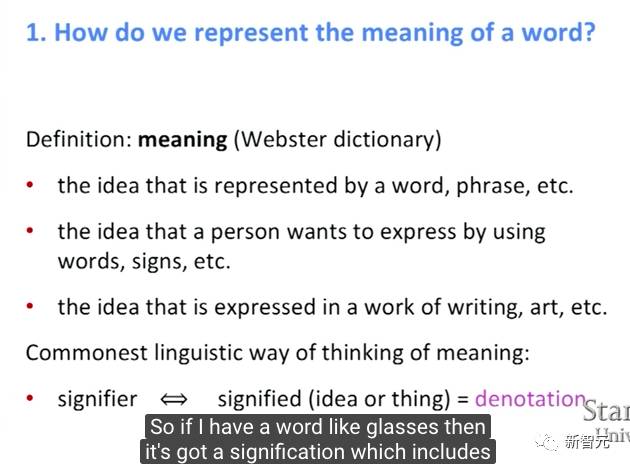

第1讲:自然语言处理与深度学习

第1讲介绍了自然语言处理(NLP)的概念和当前的NLP研究面临的问题,然后介绍将词表示为数字向量的概念,以及设计词向量的流行方法。

关键词:自然语言处理、词向量、奇异值分解、skip-gram模型、 连续词袋模型(Continuous Bag-Of-Words,CBOW)、负采样、 Hierarchical Softmax、Word2Vec

第2讲:词向量表示:word2vec

第2讲继续讨论词向量的概念,以及流行的设计词向量的方法。

第3讲 | GloVe:用于词汇表示的全局向量

第3讲介绍了用于训练词向量的 GloVe 模型。本讲接着通过观察如何评估词向量(又称词嵌入)来拓展对它的理解。作为评估技术的一种,接着我们讨论了词的类比问题(word analogies),以及如何利用类比来调整词嵌入。然后我们讨论了训练模型的权重/参数,以及外部任务的词向量。最后,我们鼓励用人工神经网络作为自然语言处理任务的一类模型。

关键词:GloVe、内部和外部评估、超参数对类比评估任务的影响、人类判断与词向量距离的相关性、使用上下文处理歧义、窗口分类

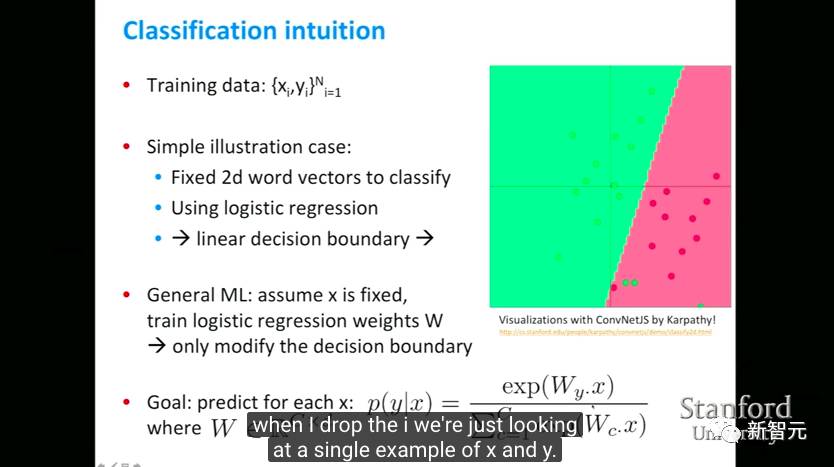

第4讲:词窗口分类和神经网络

第4讲介绍了单层和多层神经网络,以及如何它们进行分类任务。

关键词:神经网络、前向计算、反向传播、神经元单元、最大边界损失、梯度检查、Xavier参数初始化、学习率、Adagrad

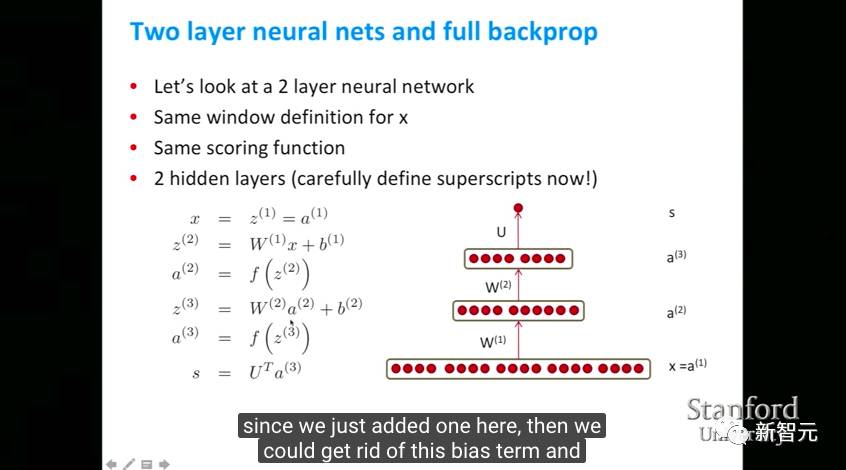

第5讲:反向传播与项目建议

第5讲讨论了如何使用反向传播这一分布式梯度下降技术来训练神经网络。

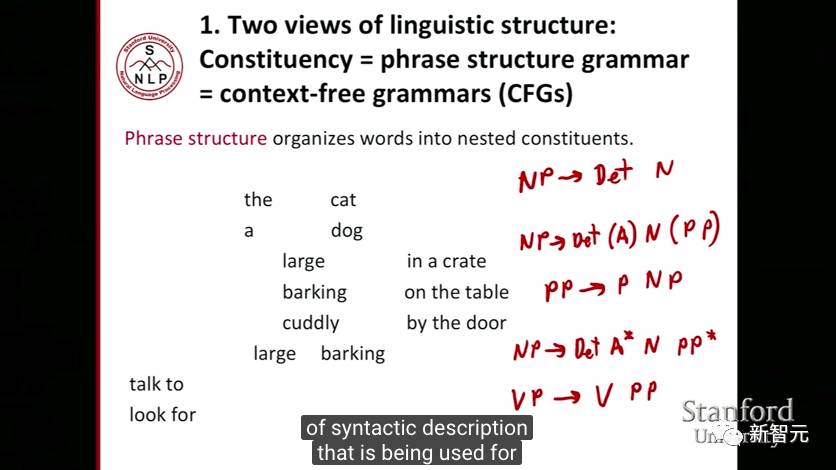

第6讲:依存分析

第6讲讨论依存分析,这是给定一个输入句子S,分析其句法依存结构的任务。依存分析器的输出是一个依存关系树,其中输入句子的词汇与依存关系类型相关联。

关键词:依存分析

第7讲:TensorFlow简介

第7讲介绍了TensorFlow。TensorFlow是一个开源软件库,用于使用数据流图(data flow graphs)进行数值计算。它最初由谷歌大脑团队开发,用于进行机器学习和深度神经网络研究。

关键词:TensorFlow

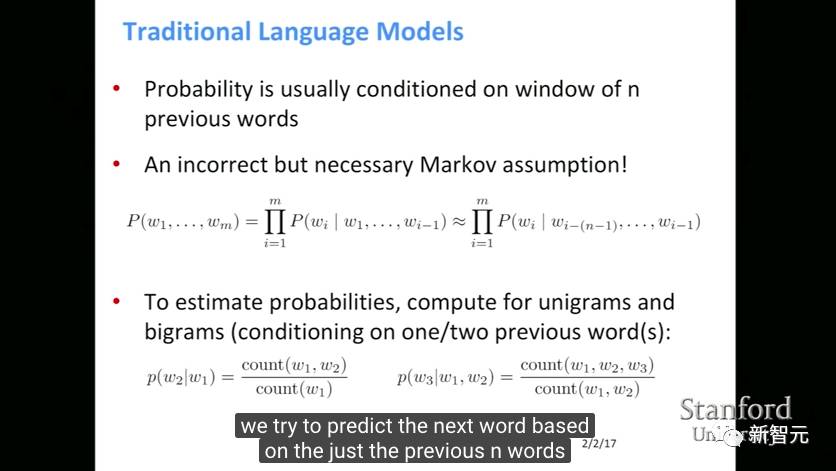

第8讲:循环神经网络和语言模型

第8讲介绍传统语言模型、RNN,以及RNN语言模型。本讲还回顾了一些重要的训练问题和技巧,用于其他序列任务的RNN,以及双向RNN(bidirectional RNNs)和deep RNNs。

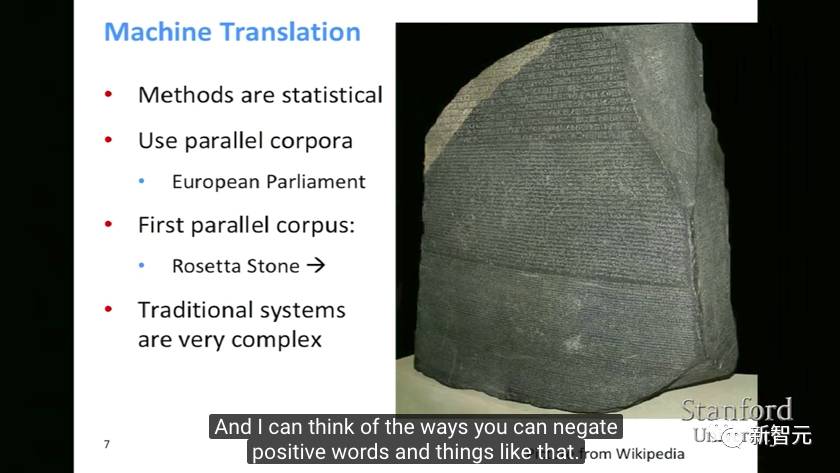

第9讲:机器翻译、LSTM和GRU

第9讲回顾了前部分课程的重要概念,机器翻译的概念,以及用RNN模型处理机器翻译。

关键词:语言模型、RNN、双向RNN、deep RNN、GRU、LSTM

第10讲:神经机器翻译和注意力模型

第10讲介绍了翻译、机器翻译和神经机器翻译,重点介绍谷歌的新 NMT模型,以及基于注意力的序列模型和序列模型解码器。

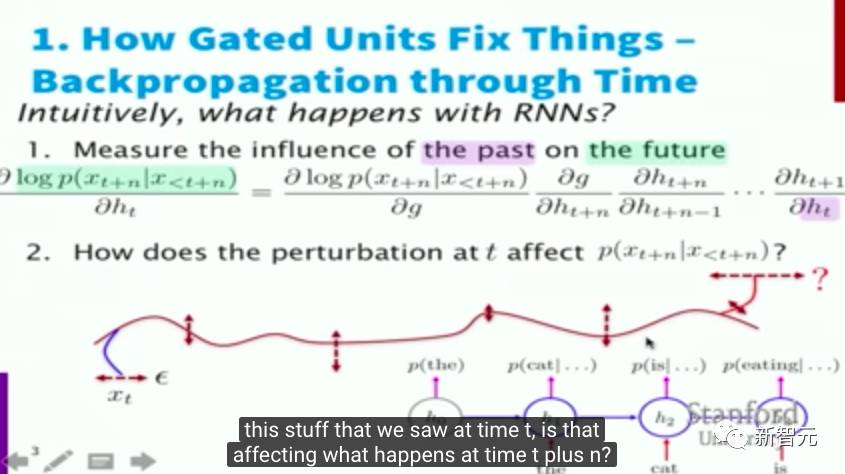

第11讲:门控循环单元和NMT

第11讲介绍了GRAT / LSTM之类的门控循环单元,然后介绍机器翻译的评估,处理大量词汇输出,以及 sub-word 模型和 character-based 模型。

关键词:Seq2Seq、注意力机制、神经机器翻译,语音处理

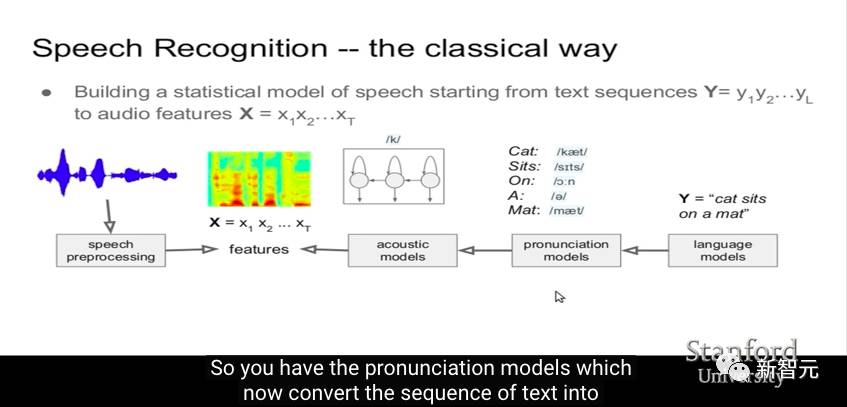

第12讲:语音处理的端到端模型

第12讲介绍传统语音识别系统和端到端模型,包括CTC模型( Connectionist Temporal Classification)和LAS(Listen Attend and Spell),这是一种用于语音识别的序列到序列模型。

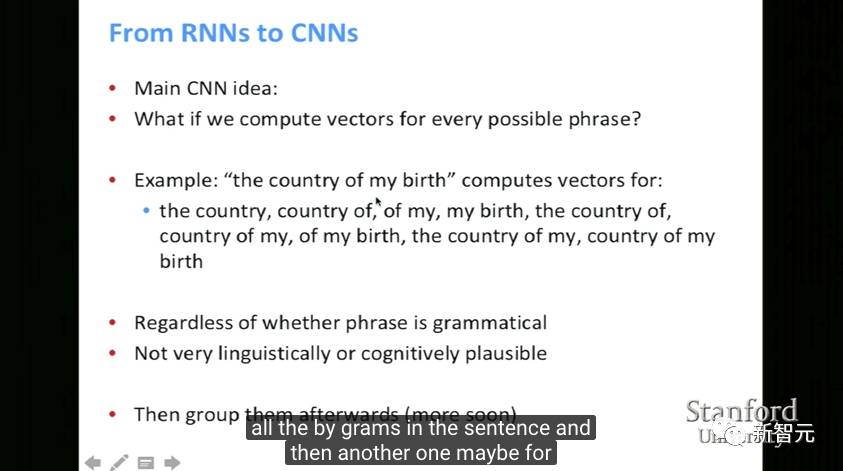

第13讲:卷积神经网络

第13讲提供了Azure和GPU的一个小教程,然后介绍“Character-Aware Neural Language Models”。本讲还提到CNN的一些变体,以及比较了 BoV、RNN、CNN这些句子模型。

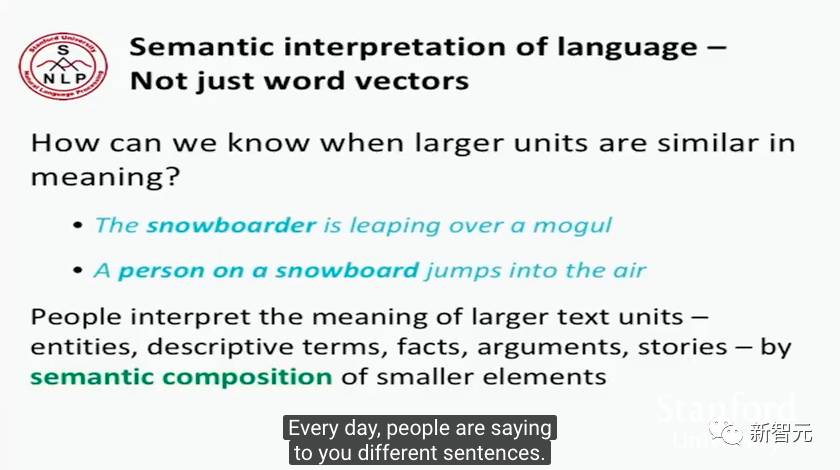

第14讲:树递归神经网络和parsing分析

第14讲介绍了语义合成性(compositionality)和结构预测,利用一个简单的树RNN:parsing。重点介绍“对话生成的深度强化学习”。

关键词:RNN、递归神经网络、MV-RNN、RNTN

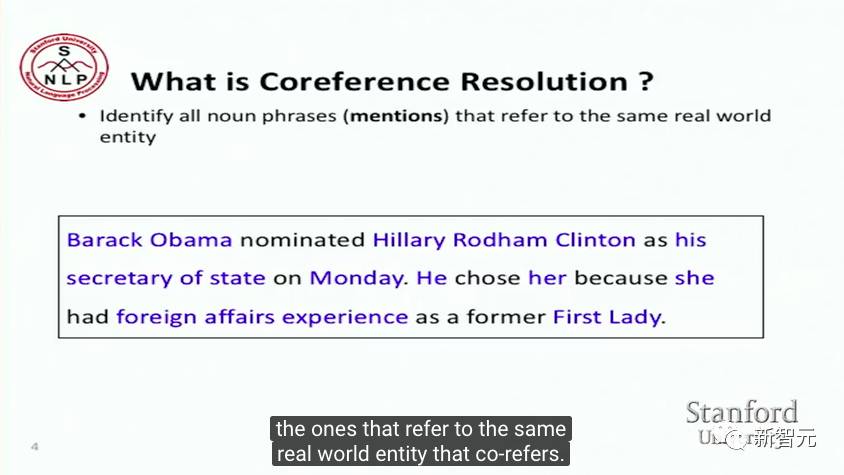

第15讲:指代消解(Coreference Resolution)

第15讲通过一个实例来介绍什么是指代(coreference),涉及的研究是“Summarizing Source Code”,这一研究介绍了指代消解和神经网络指代消解。

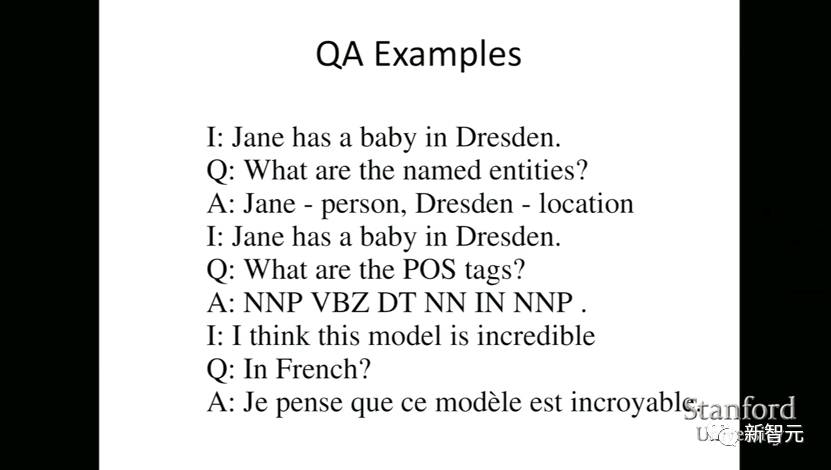

第16讲:用于问题回答的动态神经网络

第16讲介绍了“是否所有NLP任务都可以被视为问答问题”这一问题。

关键词:指代消解、动态神经网络

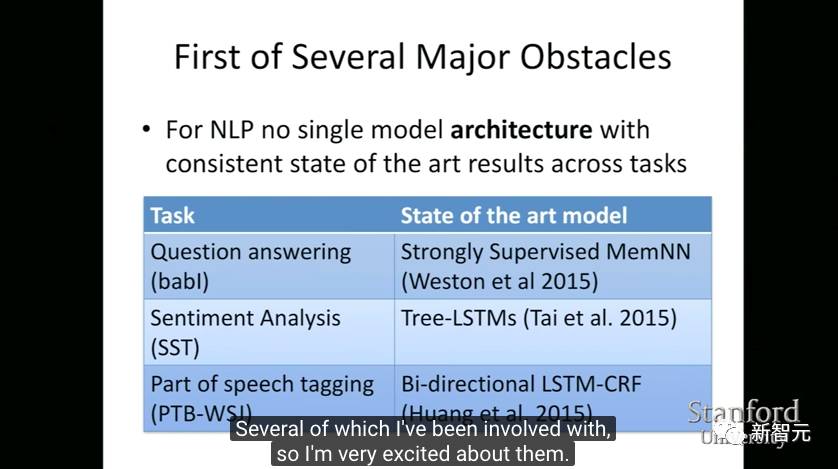

第17讲:NLP中的重要问题和NLP的架构

第17讲介绍了高效树递归模型SPINN和SNLI,重点介绍“Learning to compose neural networks for QA”这一研究。

第18讲:NLP中深度学习的局限性

第18讲讨论了NLP中深度学习的局限,提供了一些presentations。

【号外】新智元正在进行新一轮招聘,飞往智能宇宙的最美飞船,还有N个座位

点击阅读原文可查看职位详情,期待你的加入~