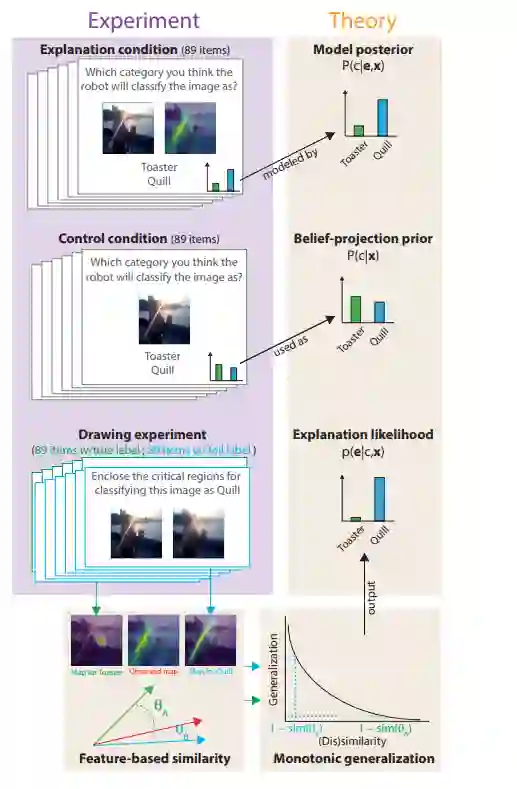

可解释人工智能(XAI)的目标是生成人类可解释的解释,但目前还没有计算精确的理论来解释人类如何解释人工智能生成的解释。理论的缺乏意味着XAI的验证必须在个案的基础上进行实证,这阻碍了XAI系统的理论建设。我们提出了一个关于人类如何从显著图(XAI解释的最常见形式)中得出结论的心理学理论,这首次允许在解释的条件下精确预测被解释推理。我们的理论假设,在缺乏解释的情况下,人类期望人工智能做出与自己类似的决定,他们通过与自己给出的解释进行比较来解释一种解释。比较是由认知科学中的经典理论——相似空间中的Shepard普遍概化定律形式化的。一项预先注册的带有显著图解释的AI图像分类用户研究表明,我们的理论在数量上与参与者对AI的预测相匹配。

https://www.zhuanzhi.ai/paper/87b1a3a6f02a70edcd51bf6449128f0f

成为VIP会员查看完整内容

相关内容

一个可以解释的AI(Explainable AI, 简称XAI)或透明的AI(Transparent AI),其行为可以被人类容易理解。它与机器学习中“ 黑匣子 ” 的概念形成鲜明对比,这意味着复杂算法运作的“可解释性”,即使他们的设计者也无法解释人工智能为什么会做出具体决定。 XAI可用于实现社会解释的权利。有些人声称透明度很少是免费提供的,并且在人工智能的“智能”和透明度之间经常存在权衡; 随着AI系统内部复杂性的增加,这些权衡预计会变得更大。解释AI决策的技术挑战有时被称为可解释性问题。另一个考虑因素是信息(信息过载),因此,完全透明可能并不总是可行或甚至不需要。提供的信息量应根据利益相关者与智能系统的交互情况而有所不同。

https://www.darpa.mil/program/explainable-artificial-intelligence

Arxiv

17+阅读 · 2021年3月19日