ACM SIGKDD(ACM SIGKDD Conference on Knowledge Discovery and Data Mining,国际数据挖掘与知识发现大会,简称 KDD)是数据挖掘领域国际顶级学术会议,今年的KDD大会将于8月23日至27日在线上召开。宾夕法尼亚州立大学ZhenhuiLi, Huaxiu Yao, Fenglong Ma等做了关于小数据学习《Learning with Small Data》教程,116页ppt涵盖迁移学习与元学习等最新课题,是非常好的学习材料!

摘要:

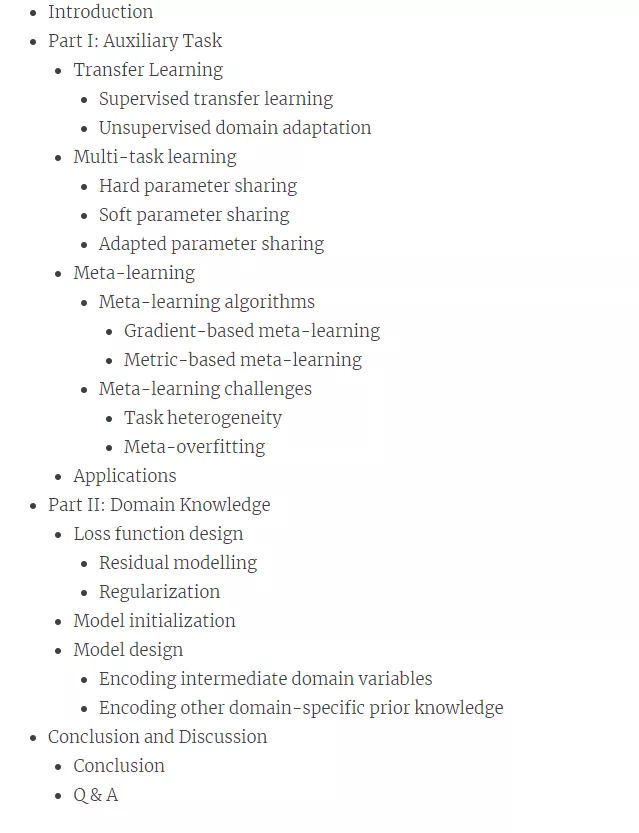

在大数据时代,数据驱动的方法在图像识别、交通信号控制、假新闻检测等各种应用中越来越受欢迎。这些数据驱动方法的优越性能依赖于大规模的标记训练数据,而实际应用中可能无法获得这些数据,即“小(标记)数据”挑战。例如,预测一个城市的突发事件,发现新出现的假新闻,以及预测罕见疾病的病情发展。在大多数情况下,人们最关心的是这些小数据案例,因此提高带有小标记数据的机器学习算法的学习效率一直是一个热门的研究课题。在本教程中,我们将回顾使用小数据进行学习的最新的机器学习技术。这些技术被组织从两个方面: (1) 提供一个全面的回顾最近的研究关于知识的泛化,迁移,和共享,其中迁移学习,多任务学习,元学习被讨论。特别是元学习,提高了模型的泛化能力,近年来已被证明是一种有效的方法; (2) 引入前沿技术,着重于将领域知识融入机器学习模型中。与基于模型的知识迁移技术不同,在现实应用中,领域知识(如物理定律)为我们提供了一个处理小数据挑战的新角度。具体地说,领域知识可以用来优化学习策略和/或指导模型设计。在数据挖掘领域,我们认为小数据学习是一个具有重要社会影响的热门话题,将吸引学术界和产业界的研究者和从业者。

目录:

地址: